Полное руководство по файлу robots.txt для WordPress

WordPress

access_time25 июля, 2018

hourglass_empty6мин. чтения

Чтобы быть уверенным, что ваш сайт хорошо ранжируется в результатах поисковых систем (Search Engine Result Pages – SERPs), вам нужно сделать его наиболее важные страницы удобным для поиска и индексирования «роботоми» («ботами») поисковых движков. Хорошо структурированный файл robots.txt поможет направить этих ботов на страницы, которые вы хотите проиндексировать (и пропустить другие).

В этой статье мы собираемся раскрыть такие вопросы:

- Что такое файл robots.txt и почему он важен

- Где находится robots.txt для WordPress

- Как создать файл robots.txt

- Какие правила должны быть в файле robots.txt для WordPress

- Как проверить файл robots.txt и отправить его в консоль Google Search.

К концу нашего обсуждения у вас будет всё необходимое для настройки отличного файла robots.txt для вашего сайт на WordPress. Начнём!

Что такое файл

robots.txt для WordPress и зачем он нуженКогда вы создаёте новый сайт, поисковые движки будут отправлять своих миньонов (или роботов) для сканирования и создания карты всех его страниц. Таким образом, они будут знать, какие страницы показывать как результат, когда кто-либо ищет по относящимся ключевым словам. На базовом уровне это достаточно просто.

Проблема состоит в том, что современные сайты содержат множество других элементом, кроме страниц. WordPress позволяет вам устанавливать, например, плагины, которые часто имеют свои каталоги. Вы не хотите показывать это в результатах поисковой выдачи, поскольку они не соответствуют содержимому.

Что делает файл robots.txt, так это обеспечивает ряд указаний для поисковых роботов. Он говорит им: «Посмотрите здесь, но не заходите в эти области!». Этот файл может настолько подробным, на сколько вы захотите и его очень просто создавать, даже если вы не технический волшебник.

Этот файл может настолько подробным, на сколько вы захотите и его очень просто создавать, даже если вы не технический волшебник.

На практике, поисковые движки всё равно будут сканировать ваш сайт, даже если вы не создадите файл robots.txt. Однако, не создавать его является весьма нерациональным шагом. Без этого файла вы оставите роботам для индексации весь контент вашего сайта и они решать, что можно показывать все части вашего сайта, даже те, которые бы вы хотели скрыть от общего доступа.

Более важный момент, без файла robots.txt, у вас будет очень много обращений для сканирования ботами вашего сайта. Это негативно скажется на его производительности. Даже если посещаемость вашего сайта ещё невелика, скорость загрузки страницы – это то, что всегда должно быть в приоритете и на высшем уровне. В конце концов, есть всего несколько моментов, которые люди не любят больше, чем медленная загрузка сайтов.

Где находится файл robots.txt для WordPress

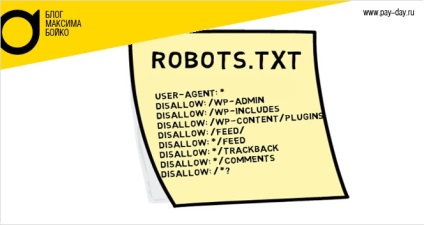

Когда вы создаёте сайт на WordPress, файл robots. txt создаётся автоматически и располагается в вашем главном каталоге на сервере. Например, если ваш сайт расположен здесь: yourfakewebsite.com, вы сможете найти его по адресу yourfakewebsite.com/robots.txt и увидеть примерно такой файл:

txt создаётся автоматически и располагается в вашем главном каталоге на сервере. Например, если ваш сайт расположен здесь: yourfakewebsite.com, вы сможете найти его по адресу yourfakewebsite.com/robots.txt и увидеть примерно такой файл:

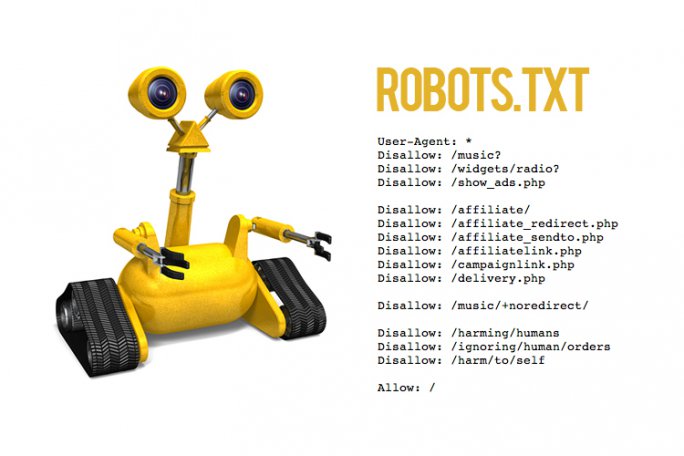

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Это пример самого простого базового файла robots.txt. Переводя на понятный человеку язык, правая часть после User-agent: объявляет, для каких роботов предназначены правила ниже. Звёздочка означает, что правило универсальное и применяется для всех ботов. В данном случае файл говорит ботам, что им нельзя сканировать каталоги wp-admin и wp-includes

Конечно же, вы можете добавить больше правил в свой файл. Прежде чем вы это сделаете, вам нужно понять, что это виртуальный файл. Обычно, WordPress robots.txt находится в корневом(root) каталоге, который часто называется public_html или www (или по названию имени вашего сайта):

Обычно, WordPress robots.txt находится в корневом(root) каталоге, который часто называется public_html или www (или по названию имени вашего сайта):

Надо отметить, что файл robots.txt для WordPress, устанавливаемый по умолчанию, не доступен для вас ни из какого каталога. Он работает, но если вы захотите внести изменения, вам нужно создать ваш собственный файл и загрузить его в

Мы рассмотрим несколько способов создания файла robots.txt для WordPress за минуту. А сейчас давайте обсудим, как определить, какие правила нужно включить в файл.

Какие правила нужно включить в файл robots.txt для WordPress

В предыдущем разделе мы видели пример генерируемого WordPress файла robots.txt. Он включает в себя только два коротких правила, но для большинства сайтов их достаточно. Давайте взглянем на два разных файла robots.

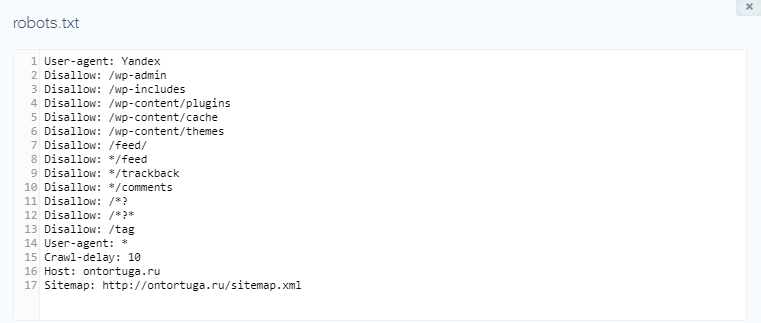

Вот наш первый пример файла robots.txt WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: /checkout/ Disallow: /images/ Disallow: /forum/

Этот файл robots.txt создан для форума. Поисковые системы обычно индексируют каждое обсуждение на форуме. В зависимости от того, какая тематика вашего форума, вы можете захотеть запретить индексацию. Так, например, Google не будет индексировать сотни коротких обсуждения пользователей. Вы также можете установить правила, указывающие на конкретную ветвь форума, чтобы исключить её, и позволить поисковым системам обходить остальные.

Вы также заметили строку, которая начинается с Allow: / вверху файла. Эта строка говорит ботам, что они могут сканировать все страницы вашего сайта, кроме установленных ниже ограничений. Также вы заметили, что мы установили эти правила как универсальные (со звёздочкой), как было в виртуальном файле WordPress robots. txt.

txt.

Давайте проверим другой пример файла WordPress robots.txt:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ User-agent: Bingbot Disallow: /

В этом файле мы устанавливаем те же правила, что идут в WordPress по умолчанию. Хотя мы также добавляем новый набор правил, которые блокируют поисковых роботов Bing от сканирования нашего сайта. Bingbot, как можно понять, это имя робота.

Вы можете совершенно конкретно задавать поисковых роботов отдельного движка для ограничения/разрешения их доступа. На практике, конечно, Bingbot очень хороший (даже если не такой хороший, как Googlebot). Однако, есть и много вредоносных роботов.

Плохой новостью является то, что они далеко не всегда следуют инструкциям из файла robots.txt (они же всё же работают как террористы). Следует иметь в виду, что, хотя большинство роботов будут использовать указания, представленные в этом файле, но вы не можете принудить их это делать.

Если глубже вникнуть в тему, вы найдёте много предложений того, что разрешать и что блокировать на своём сайте WordPress. Хотя, из нашего опыта, меньше правил часто лучше. Вот пример рекомендованного вида вашего первого файла robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/

Традиционно WordPress любит закрывать каталоги wp-admin и

Что содержится в вашем файле robots.txt будет зависеть от особенностей и потребностей вашего сайта. Поэтому смело проводите больше исследований!

Как создать файл robots.txt для WordPress (3 способа)

Как только вы решили сделать свой файл robots. txt, всё что осталось – это найти способ его создать. Вы можете редактировать robots.txt в WordPress, используя плагин или вручную. В этом разделе мы обучим вас применению двух наиболее популярных плагинов для выполнения этой задачи и обсудим, как создать и загрузить файл вручную. Поехали!

txt, всё что осталось – это найти способ его создать. Вы можете редактировать robots.txt в WordPress, используя плагин или вручную. В этом разделе мы обучим вас применению двух наиболее популярных плагинов для выполнения этой задачи и обсудим, как создать и загрузить файл вручную. Поехали!

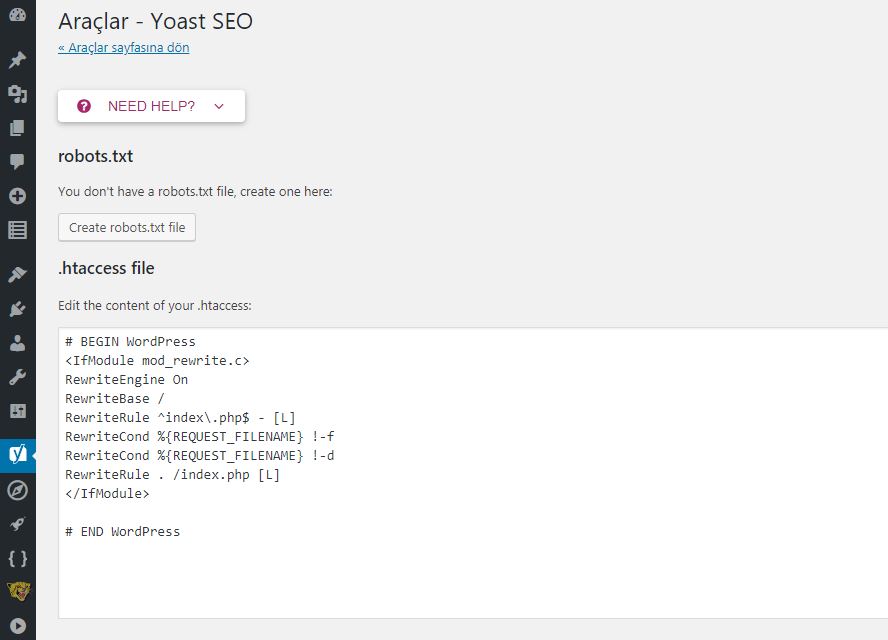

1. Использование плагина Yoast SEO

Yoast SEO вряд ли требует представления. Это наиболее известный SEO-плагин для WordPress, он позволяет вам улучшать ваши записи и страницы для лучшего использования ключевых слов. Кроме этого, он также оценит ваш контент с точки зрения удобности чтения, а это повысит аудиторию поклонников.

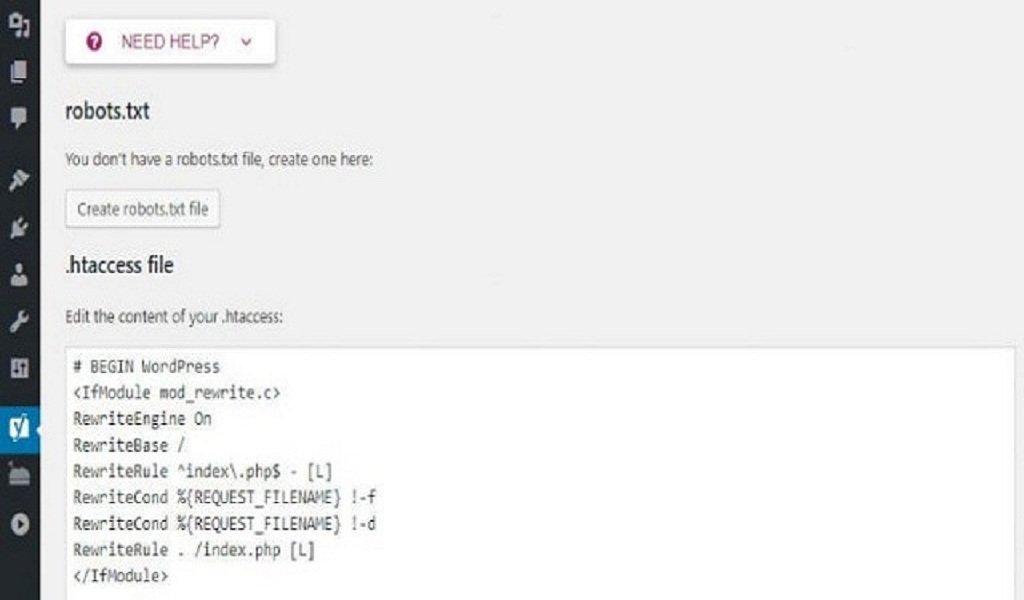

Наша команда является почитателями плагина Yoast SEO благодаря его простоте и удобству. Это относится и к вопросу создания файла robots.txt. Как только вы установите и активируете свой плагин, перейдите во вкладку SEO › Инструменты в своей консоли и найдите настройку Редактор файлов:

Нажав на эту ссылку, вы можете редактировать файл . htaccess не покидая админ консоль. Здесь же есть кнопка Создать файл robots.txt:

htaccess не покидая админ консоль. Здесь же есть кнопка Создать файл robots.txt:

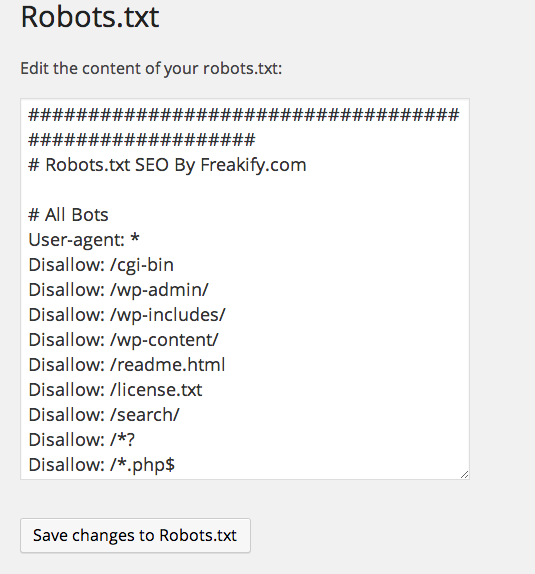

После нажатия на кнопку во вкладке будет отображён новый редактор, где вы можете напрямую редактировать ваш файл robots.txt. Обратите внимание, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots.txt.

После удаления или добавления правил нажимайте кнопку Сохранить изменения в robots.txt для вступления их в силу:

Это всё! Давайте теперь посмотрим на другой популярный плагин, который позволит нам выполнить эту же задачу.

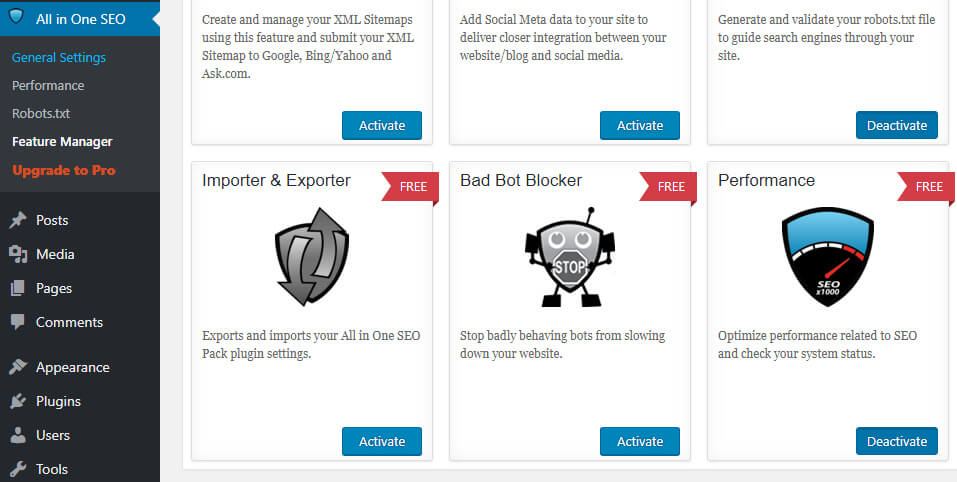

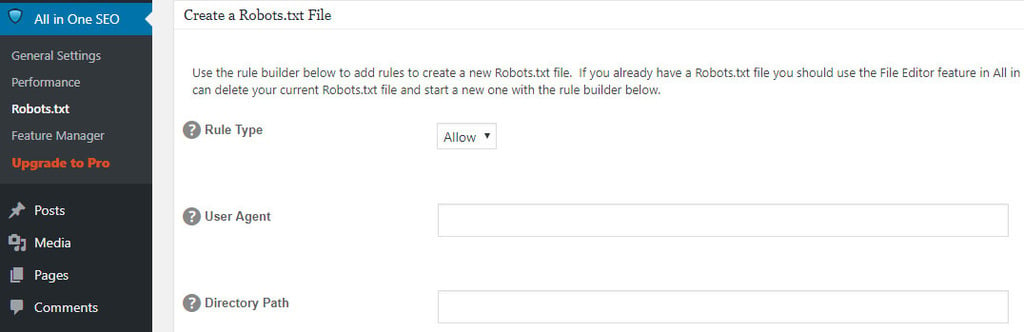

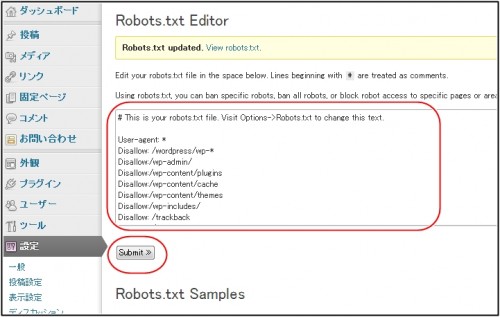

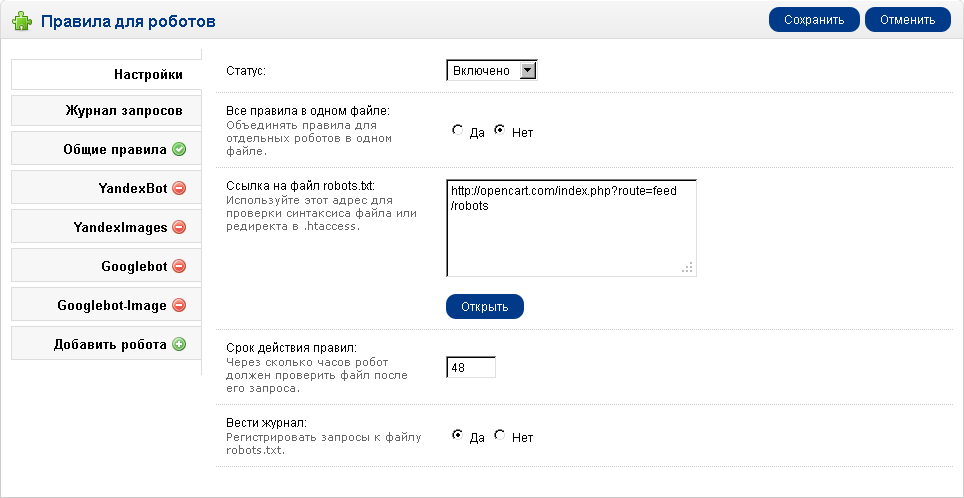

2. Применение плагина All in One SEO Pack

Плагин All in One SEO Pack – ещё один прекрасный плагин WordPress для настройки SEO. Он включает в себя большинство функций плагина Yoast SEO, но некоторые предпочитают его потому что он более легковесный. Что касается файла robots.txt, его создать в этом плагине также просто.

После установки плагина, перейдите на страницу All in One SEO > Управление модулями в консоли. Внутри вы найдёте опцию Robots.txt с хорошо заметной кнопкой Activate внизу справа. Нажмите на неё:

Теперь в меню All in One SEO будет отображаться новая вкладка Robots.txt. Если вы нажмёте на этот пункт меню, вы увидите настройки для добавления новых правил в ваш файл, сохраните внесённые изменения или удалите всё:

Обратите внимание, что вы не можете напрямую изменять файл robots.txt при помощи этого плагина. Содержимое файла будет неактивным, что видно по серому фону поля, в отличие от Yoast SEO, который позволяет вам вводить всё, что вы хотите:

Но, так как добавление новых правил очень простая процедура, то этот факт не должен расстроить вас. Более важный момент, что All in One SEO Pack также включает функцию, которая поможет вам блокировать «плохих» ботов, её вы можете найти во вкладке All in One SEO:

Это всё, что вам нужно сделать, если вы выбрали этот способ. Теперь давайте поговорим о том, как вручную создать файл robots.txt, если вы не хотите устанавливать дополнительный плагин только для этой задачи.

Теперь давайте поговорим о том, как вручную создать файл robots.txt, если вы не хотите устанавливать дополнительный плагин только для этой задачи.

3. Создание и загрузка файла

robots.txt для WordPress по FTPЧто может быть проще, чем создание текстового файла txt. Всё, что вам нужно сделать, открыть свой любимый редактор (как, например, Notepad или TextEdit) и ввести несколько строк. Потом вы сохраняете файл, используя любое имя и расширение txt. Это буквально займёт несколько секунд, поэтому вы вполне можете захотеть создать robots.txt для WordPress без использования плагина.

Вот быстрый пример такого файла:

Мы сохранили этот файл локально на компьютере. Как только вы сделали свой собственный файл вам нужно подключиться к своему сайту по FTP. Если вы не совсем понимаете, как это сделать, у нас есть руководство, посвящённое этому – использование удобного для новичков клиента FileZilla.

После подключения к своему сайту перейдите в каталог public_html. Теперь, всё что вам нужно сделать это загрузить файл robots.txt со своего компьютера на сервер. Вы можете это сделать либо нажав правой кнопкой мыши на файле в локальной FTP навигаторе или простым перетаскиванием мышью:

Это займёт всего несколько секунд. Как вы видите, этот способ не сложнее использования плагина.

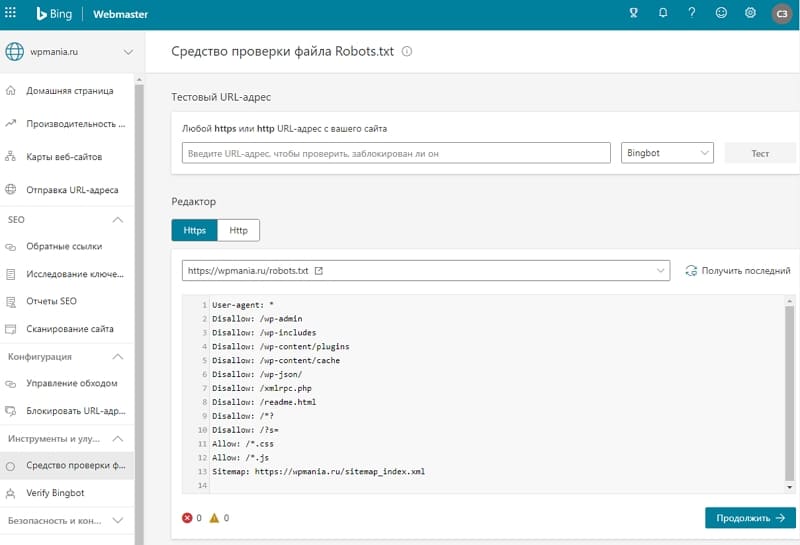

Как проверит WordPress robots.txt и отправить его в Консоль Google Search

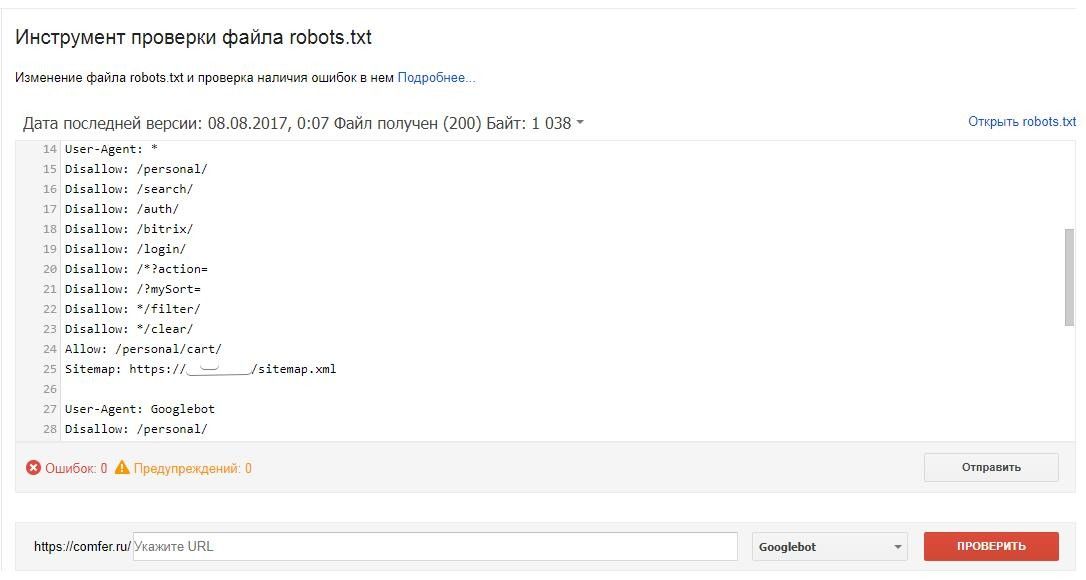

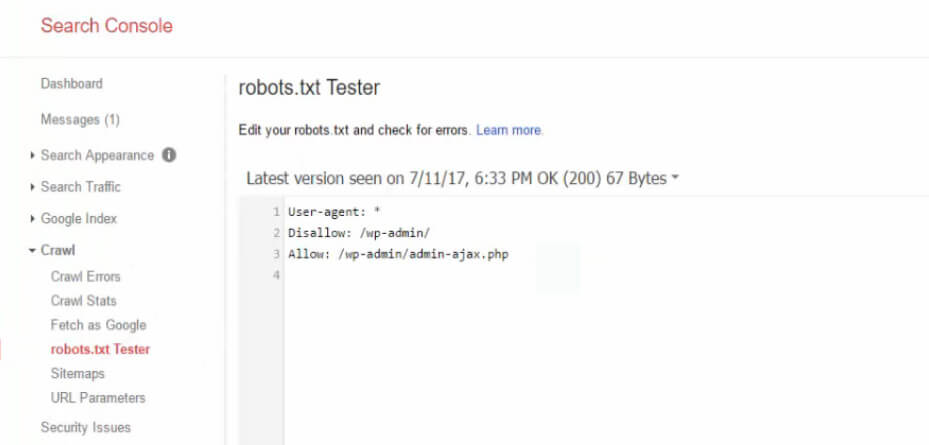

Теперь, когда ваш файл WordPress robots.txt создан и загружен на сайт, вы можете проверить его на ошибки в Консоли Google Search. Search Console – это набор инструментов Google, призванных помочь вам отслеживать то, как ваш контент появляется в результатах поиска. Один из таких инструментов проверяет robots.txt, его вы можете использовать перейдя в своей консоли в раздел Инструмент проверки файла robots.txt:

Здесь вы найдёте поле редактора, где вы можете добавить код своего файла WordPress robots. txt, и нажать Отправить в правом нижнем углу. Консоль Google Search спросит вас, хотите ли вы использовать новый код или загрузить файл с вашего сайта. Выберите опцию, которая говорит Ask Google to Update для публикации вручную:

txt, и нажать Отправить в правом нижнем углу. Консоль Google Search спросит вас, хотите ли вы использовать новый код или загрузить файл с вашего сайта. Выберите опцию, которая говорит Ask Google to Update для публикации вручную:

Теперь платформа проверит ваш файл на ошибки. Если будет найдена ошибка, информация об этом будет показана вам.

Вы ознакомились с несколькими примерами файл robots.txt WordPress, и теперь у вас есть ещё больше шансов создать свой идеальный!

Заключение

Чтобы быть уверенным, что ваш сайт представлен наилучшим образом для поисковых роботов стоит позаботиться о том, чтобы для них был открыт необходимый контент. Как мы увидели, хорошо настроенный файл robots.txt WordPress поможет показать роботам, каким образом лучше взаимодействовать с вашим сайтом. Таким образом, они помогут тем, кто ищет получить более релевантный и полезный контент.

У вас остались вопросы о том, как редактировать robots. txt в WordPress? Напишите нам в разделе комментариев ниже!

txt в WordPress? Напишите нам в разделе комментариев ниже!

Правильный robots.txt для WordPress

Относительно того, что должно быть внутри файла robots.txt до сих пор возникает куча споров. Вообще, на мой взгляд, этот файл должен содержать две обязательные вещи:

Скрывать в нём все функциональные PHP-файлы (как делают некоторые вебмастера) я не вижу смысла. А уж страницы сайта тем более. Я проводил эксперимент со скрытием страниц через

Для скрытия от индексации страниц сайта используйте метатег:

<meta name="robots" content="noindex, follow" />

Функция do_robots()

Выводит несколько директив для файла robots.txt, рекомендуемые для WordPress.

Параметров не имеет, зато имеет 1 хук и 1 фильтр.

Рассмотрим по порядку, как работает функция:

- В первую очередь функция устанавливает

Content-Typetext/plain(с кодировкой UTF-8).

- Затем запускается экшен

do_robotstxt(без параметров). - Третьим шагом идёт проверка, отмечена ли галочка «Попросить поисковые системы не индексировать сайт» в настройках чтения:

- Если отмечена, содержимое

robots.txtбудет:User-agent: * Disallow: /

Если не отмечена:

User-agent: * Disallow: /wp-admin/

- Непосредственно перед выводом срабатывает фильтр

robots_txt(WordPress 3.0+) с двумя параметрами —robots.txt) и$public(отмечена ли галочка в пункте 3).

Готовый robots.txt

К результату функции do_robots() добавим еще то, о чем я говорил в начале поста и получим вот такой robots.txt для WordPress:

User-agent: * Disallow: /wp-admin/ User-agent: Yandex Disallow: /wp-admin/ Host: truemisha.ru Sitemap: https://misha.agency/sitemap.xml

Создать его вы можете при помощи любого текстового редактора. Сохраните его там же, где находятся директории

Сохраните его там же, где находятся директории wp-admin

wp-content.Миша

Недавно я осознал, что моя миссия – способствовать распространению WordPress. Ведь WordPress – это лучший движок для разработки сайтов – как для тех, кто готов использовать заложенную структуру этой CMS, так и для тех, кто предпочитает headless решения.

Сам же я впервые познакомился с WordPress в 2009 году. Организатор WordCamp. Преподаватель в школах Epic Skills и LoftSchool.

Если вам нужна помощь с вашим сайтом или может даже разработка с нуля на WordPress / WooCommerce — пишите. Я и моя команда сделаем вам всё на лучшем уровне.

Что такое robots.txt и как его настроить

Знание о том, что такое robots.txt, и умение с ним работать больше относится к профессии вебмастера. Однако SEO-специалист — это универсальный мастер, который должен обладать знаниями из разных профессий в сфере IT. Поэтому сегодня разбираемся в предназначении и настройке файла robots.

По факту robots.txt — это текстовый файл, который управляет доступом к содержимому сайтов. Редактировать его можно на своем компьютере в программе Notepad++ или непосредственно на хостинге.

Что такое robots.txt

Представим robots.txt в виде настоящего робота. Когда в гости к вашему сайту приходят поисковые роботы, они общаются именно с robots.txt. Он их встречает и рассказывает, куда можно заходить, а куда нельзя. Если вы дадите команду, чтобы он никого не пускал, так и произойдет, т.е. сайт не будет допущен к индексации.

Если на сайте нет этого файла, создаем его и загружаем на сервер. Его несложно найти, ведь его место в корне сайта. Допишите к адресу сайта /robots.txt и вы увидите его.

Зачем нам нужен этот файл

Если на сайте нет robots.txt, то роботы из поисковых систем блуждают по сайту как им вздумается. Роботы могут залезть в корзину с мусором, после чего у них создастся впечатление, что на вашем сайте очень грязно. robots.txt скрывает от индексации:

robots.txt скрывает от индексации:

- дубли страниц;

- служебные файлы;

- файлы, которые бесполезны для посетителей;

- страницы с неуникальным контентом.

Правильно заполненный файл robots.txt создает иллюзию, что на сайте всегда чисто и убрано.

Настройка директивов robots.txt

Директивы — это правила для роботов. И эти правила пишем мы.

User-agent

Главное правило называется User-agent. В нем мы создаем кодовое слово для роботов. Если робот видит такое слово, он понимает, что это правило для него.

Пример:

User-agent: Yandex

Данное правило смогут понять только те роботы, которые работают в Яндексе. В последнее время эту строчку я заполняю так:

User-agent: *

Правило понимает Яндекс и Гугл. Доля трафика с других поисковиков очень мала, и продвигаться в них не стоит затраченных усилий.

Disallow и Allow

С помощью Disallow мы скрываем каталоги от индексации, а, прописывая правило с директивой Allow, даем разрешение на индексацию.

Пример:

Allow: /category/

Даем рекомендацию, чтобы индексировались категории.

Disallow: /

А вот так от индексации будет закрыт весь сайт.

Также существуют операторы, которые помогают уточнить наши правила.

- * – звездочка означает любую последовательность символов (либо отсутствие символов).

- $ – знак доллара является своеобразной точкой, которая прерывает последовательность символов.

Disallow: /category/$ # закрываем только страницу категорий Disallow: /category/* # закрываем все страницы в папке категории

Sitemap

Данная директива нужна для того, чтобы сориентировать робота, если он заплутает. Мы показываем роботу дорогу к Sitemap.

Пример:

Sitemap: http://site.ru/sitemap.xml

Директива host уже устарела, поэтому о ней говорить не будем.

Crawl-delay

Если сайт небольшой, то директиву Crawl-delay заполнять нет необходимости. Эта директива нужна, чтобы задать периодичность скачивания документов с сайта.

Пример:

Crawl-delay: 10

Это правило означает, что документы с сайта будут скачиваться с интервалом в 10 секунд.

Clean-param

Директива Clean-param закрывает от индексации дубли страниц с разными адресами. Например, если вы продвигаетесь через контекстную рекламу, на сайте будут появляться страницы с utm-метками. Чтобы подобные страницы не плодили дубли, мы можем закрыть их с помощью данной директивы.

Пример:

Clean-Param: utm_source&utm_medium&utm_campaign

Как закрыть сайт от индексации

Чтобы полностью закрыть сайт от индексации, достаточно прописать в файле следующее:

User-agent: * Disallow: /

Если требуется закрыть от поисковиков поддомен, то нужно помнить, что каждому поддомену требуется свой robots. txt. Добавляем файл, если он отсутствует, и прописываем магические символы.

txt. Добавляем файл, если он отсутствует, и прописываем магические символы.

Проверка файла robots

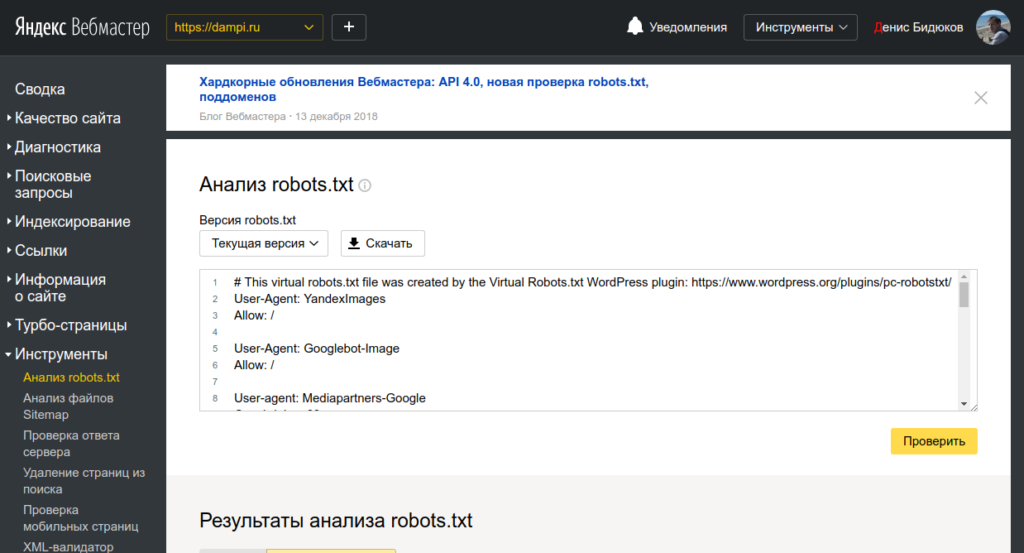

Есть потрясающий инструмент, который позволит вам включиться в творческую работу с директивами и прописать правильный robots.txt – инструмент от Яндекс.Вебмастера.

Переходим в инструмент, вводим домен и содержимое вашего файла.

Нажимаем «Проверить» и получаем результаты анализа. Здесь мы можем увидеть, есть ли ошибки в нашем robots.txt.

Но на этом функции инструмента не заканчиваются. Вы можете проверить, разрешены ли определенные страницы сайта для индексации или нет.

Вводим список адресов, которые нас интересуют, и нажимаем «Проверить». Инструмент сообщит нам, разрешены ли для индексации данные адреса страниц, а в столбце «Результат» будет видно, почему страница индексируется или не индексируется.

Здесь вас ждет простор для творчества. Пользуйтесь звездочкой или знаком доллара и закрывайте от индексации страницы, которые не несут пользы для посетителей. Будьте внимательны – проверяйте, не закрыли ли вы от индексации важные страницы.

Будьте внимательны – проверяйте, не закрыли ли вы от индексации важные страницы.

Правильный robots.txt для WordPress

Кстати, если вы поставите #, то сможете оставлять комментарии, которые не будут учитываться роботами.

User-agent: * Disallow: /cgi-bin # папка на хостинге Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ # Все служебные файлы можно закрыть другим образом: Disallow: /wp- Disallow: /xmlrpc.php # файл WordPress API Disallow: /*? # поиск Disallow: /?s= # поиск Allow: /*.css # стили Allow: /*.js # скрипты Sitemap: https://site.ru/sitemap.xml # путь к карте сайта (надо прописать свой сайт)

Правильный robots.txt для Joomla

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/ Sitemap: https://site.ru/sitemap.xml

Здесь указаны другие названия директорий, но суть одна: закрыть мусорные и служебные страницы, чтобы показать поисковиками только то, что они хотят увидеть.

Правильно настроенный файл robots.txt способен оказать позитивное влияние на продвижение сайта. Если вы хотите избавиться от мусора и навести порядок на сайте, файл robots.txt готов прийти на помощь.

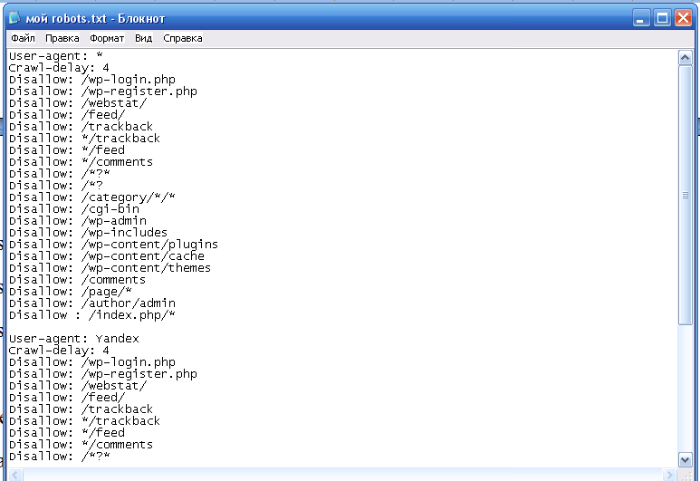

правильный пример на WordPress для Яндекса и Google

Всем привет! Сегодня я бы хотел Вам рассказать про файл robots.txt. Да, про него очень много чего написано в интернете, но, если честно, я сам очень долгое время не мог понять, как же создать правильный robots.txt. В итоге я сделал один и он стоит на всех моих блогах. Проблем с индексацией сайта я не замечаю, robots.txt работает просто великолепно.

Robots.txt для WordPress

А зачем, собственно говоря, нужен robots.txt? Ответ все тот же – продвижение сайта в поисковых системах. То есть составление robots. txt – это одно из частей поисковой оптимизации сайта (кстати, очень скоро будет урок, который будет посвящен всей внутренней оптимизации сайта на WordPress. Поэтому не забудьте подписаться на RSS, чтобы не пропустить интересные материалы.).

txt – это одно из частей поисковой оптимизации сайта (кстати, очень скоро будет урок, который будет посвящен всей внутренней оптимизации сайта на WordPress. Поэтому не забудьте подписаться на RSS, чтобы не пропустить интересные материалы.).

Одна из функций данного файла – запрет индексации ненужных страниц сайта. Также в нем задается адрес карты сайта sitemap.xml и прописывается главное зеркало сайта (сайт с www или без www).

Примечание: для поисковых систем один и тот же сайт с www и без www совсем абсолютно разные сайты. Но, поняв, что содержимое этих сайтов одинаковое, поисковики “склеивают” их. Поэтому важно прописать главное зеркало сайта в robots.txt. Чтобы узнать, какое главное (с www или без www), просто наберите адрес своего сайта в браузере, к примеру, с www, если Вас автоматически перебросит на тот же сайт без www, значит главное зеркало Вашего сайта без www. Надеюсь правильно объяснил.

Было:

Стало (после перехода на сайт, www автоматически удалились, и сайт стал без www):

Так вот, этот заветный, по-моему, правильный robots. txt для WordPress Вы можете увидеть ниже.

txt для WordPress Вы можете увидеть ниже.

Правильный Robots.txt для WordPress

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: wpnew.ru

Sitemap: https://wpnew.ru/sitemap.xml.gz

Sitemap: https://wpnew.ru/sitemap.xml

Все что дано выше, Вам нужно скопировать в текстовой документ с расширением . txt, то есть, чтобы название файла было robots.txt. Данный текстовой документ Вы можете создать, к примеру, с помощью программы Notepad++. Только, не забудьте, пожалуйста, изменить в последних трех строчках адрес wpnew.ru на адрес своего сайта. Файл robots.txt должен располагаться в корне блога, то есть в той же папке, где находятся папки wp-content, wp-admin и др. .

txt, то есть, чтобы название файла было robots.txt. Данный текстовой документ Вы можете создать, к примеру, с помощью программы Notepad++. Только, не забудьте, пожалуйста, изменить в последних трех строчках адрес wpnew.ru на адрес своего сайта. Файл robots.txt должен располагаться в корне блога, то есть в той же папке, где находятся папки wp-content, wp-admin и др. .

Те, кому же лень создавать данный текстовой файл, можете просто скачать robots.txt и также там подкорректировать 3 строчки.

Хочу отметить, что в техническими частями, о которых речь пойдет ниже, себя сильно загружать не нужно. Привожу их для “знаний”, так сказать общего кругозора, чтобы знали, что и зачем нужно.

Итак, строка:

User-agent

задает правила для какого-то поисковика: к примеру “*” (звездочкой) отмечено, что правила для всех поисковиков, а то, что ниже

User-agent: Yandex

означает, что данные правила только для Яндекса.

Disallow

Здесь же Вы “засовываете” разделы, которые НЕ нужно индексировать поисковикам. К примеру, на странице https://wpnew.ru/tag/seo у меня идет дубль статей (повторение) с обычными статьями, а дублирование страниц отрицательно сказывается на поисковом продвижении, поэтому, крайне желательно, данные секторы нужно закрыть от индексации, что мы и делаем с помощью этого правила:

К примеру, на странице https://wpnew.ru/tag/seo у меня идет дубль статей (повторение) с обычными статьями, а дублирование страниц отрицательно сказывается на поисковом продвижении, поэтому, крайне желательно, данные секторы нужно закрыть от индексации, что мы и делаем с помощью этого правила:

Disallow: /tag

Так вот, в том robots.txt, который дан выше, от индексации закрыты почти все ненужные разделы сайта на WordPress, то есть просто оставьте все как есть.

Host

Здесь мы задаем главное зеркало сайта, о котором я рассказывал чуть выше.

Sitemap

В последних двух строчках мы задаем адрес до двух карт сайта, созданные с помощью плагина Google XML Sitemaps.

Возможные проблемы

Если у Вас на блоге не стоит ЧПУ (именно так у меня происходит с тем сайтом, которого я занимаюсь продвижением), то с тем robots.txt, который дан выше, могут быть проблемы. Напомню, что без ЧПУ ссылки на сайте на посты выглядят примерно следующим образом:

А вот из-за этой строчки в robots. txt, у меня перестали индексироваться посты сайта:

txt, у меня перестали индексироваться посты сайта:

Disallow: /*?*

Как видите, эта самая строка в robots.txt запрещает индексирование статей, что естественно нам нисколько не нужно. Чтобы исправить это, просто нужно удалить эти 2 строчки (в правилах для всех поисковиков и для Яндекса) и окончательный правильный robots.txt для WordPress сайта без ЧПУ будет выглядеть следующим образом:

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

Host: wpnew. ru

ru

Sitemap: https://wpnew.ru/sitemap.xml.gz

Sitemap: https://wpnew.ru/sitemap.xml

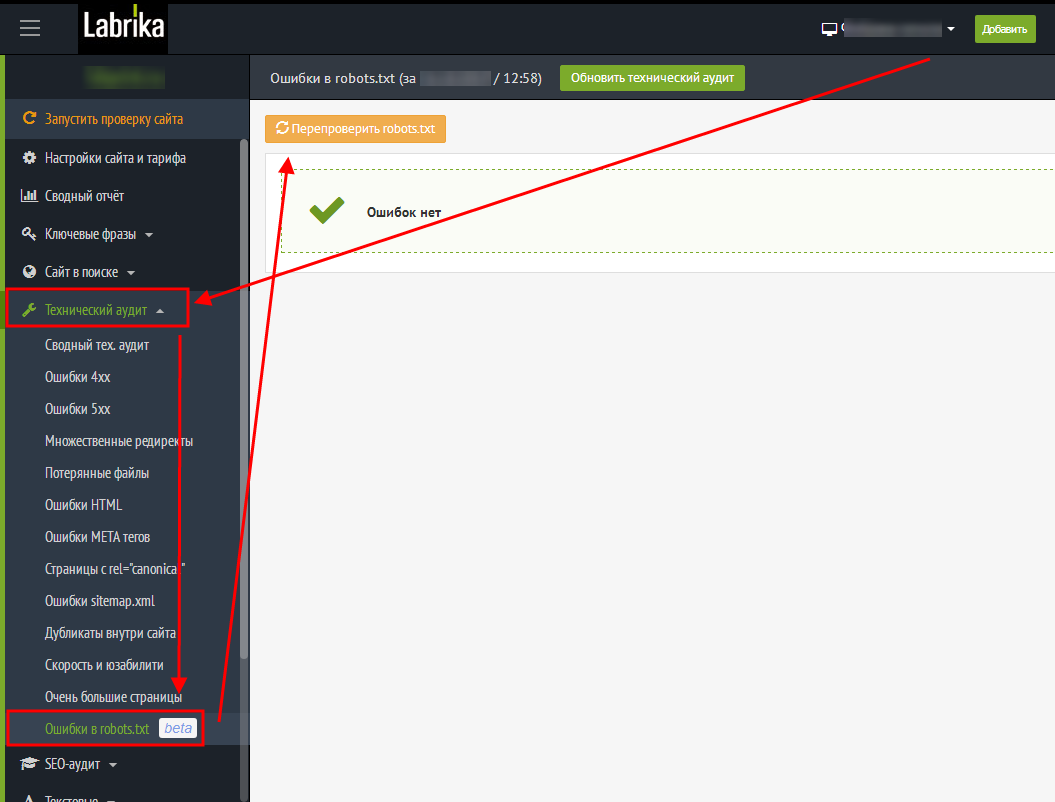

Анализ robots.txt

Чтобы проверить, правильно ли мы составили файл robots.txt я рекомендую Вам воспользоваться сервисом Яндекс Вебмастер (как регистрироваться в данном сервисе я рассказывал тут).

Заходим в раздел Настройки индексирования –> Анализ robots.txt:

Уже там нажимаете на кнопку “Загрузить robots.txt с сайта”, а затем нажимаете на кнопку “Проверить”:

Если Вы увидите примерно следующее сообщение, значит у Вас правильный robots.txt для Яндекса:

Также Вы можете в “Список URL” добавить адрес любой статьи сайта, чтобы проверить не запрещает ли robots.txt индексирование данной страницы:

Как видите, никакого запрета на индексирование страницы со стороны robots.txt мы не видим, значит все в порядке :).

Надеюсь больше вопросов, типа: как составить robots.txt или как сделать правильным данный файл у Вас не возникнет. В этом уроке я постарался показать Вам правильный пример robots.txt:

В этом уроке я постарался показать Вам правильный пример robots.txt:

Вы можете посмотреть другие варианты, как еще можно составлять robots.txt.

До скорой встречи!

P.s. Совсем недавно я добавил блог в Яндекс Каталог, что же интересного произошло? 🙂

Как оптимизировать Robots.txt для SEO в WordPress

Вы хотите оптимизировать свой файл robots.txt в WordPress? Не уверены, почему и каким образом файл robots.txt имеет важное значение для вашего SEO? В этой статье расскажем вам, как оптимизировать ваш файл robots.txt на сайте WordPress для SEO и поможем вам понять важность файла robots.txt.В последнее время, пользователи спрашивают нас, нуждаются ли сайт в файле robots.txt и какова важность его? Файл robots.txt для вашего сайта играет важную роль в общей производительности и seo оптимизации вашего сайта. Это в основном позволяет вам общаться с поисковыми системами и дают им знать, какие части вашего сайта они должны индексировать.

Нужен ли файл robots.txt?

Отсутствие файла robots.txt не остановит поисковых систем от сканирования и индексирования вашего сайта. Тем не менее, настоятельно рекомендуется создать один. Если вы хотите представить на вашем сайте в XML карту сайта для поисковых систем, то в файле поисковые системы будут искать ваш XML Sitemap, если вы не указали его в Yandex webmaster или Google Webmaster Tools.

Мы настоятельно рекомендуем, если у вас нет файла robots.txt на вашем сайте, то вы должны сразу же создать.

Где находится файл robots.txt? Как создать файл robots.txt?

Файл robots.txt, как правило, находится в корневой папке вашего сайта. Вам нужно будет подключиться к вашему сайту с использованием клиента FTP или с помощью файлового менеджера CPanel для его просмотра.

Он такой же, как любой обычный текстовый файл, и вы можете открыть его с помощью обычного текстового редактора как Блокнота.

Если у вас нет файла robots.txt в корневом каталоге вашего сайта, то вы всегда можете создать. Все, что вам нужно сделать, это создать новый текстовый файл на вашем компьютере и сохранить его в файле robots.txt. Далее, просто загрузите его в корневую папку вашего сайта.

Все, что вам нужно сделать, это создать новый текстовый файл на вашем компьютере и сохранить его в файле robots.txt. Далее, просто загрузите его в корневую папку вашего сайта.

Как использовать файл robots.txt?

Формат файла robots.txt на самом деле довольно прост. Первая строка обычно называет User-Agent. Агент пользователя на самом деле имя бота поисковой системы, которые пытаются прочитать ваш сайт. Например, Googlebot или Yandexbot. Вы можете использовать звездочку *, чтобы проинструктировать всех ботов.

В следующей строке следует разрешить или запретить инструкции для поисковых систем, чтобы они знали, какие части вы хотите, чтобы индексировались, и какие из них вы не хотите индексировать.

Смотрите пример файла robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html

В этом примере файл robots.txt для WordPress, мы поручили всем ботам индексировать наш каталог загрузки изображения.

В следующих двух строках мы им запрещаем индексировать наш каталог плагинов WordPress и файл readme.html.

Оптимизация файла Robots.txt для SEO

В руководстве для веб-мастеров, Google советует веб-мастерам, не использовать файл robots.txt, чтобы скрыть содержание низкого качества. Если вы думаете об использовании файла robots.txt, чтобы остановить Google индексировать категории, даты и другие архивные страницы, то это не может быть мудрым выбором.

Помните, что цель robots.txt является поручить ботам, что делать с содержанием, когда они сканируют ваш сайт. Это не помешает ботам сканировать ваш сайт.

Есть и другие плагины для WordPress, которые позволяют добавлять мета-теги, как NOFOLLOW и мета тег noindex в ваших страницах архива. Плагин WordPress SEO также позволяет сделать это. Мы не говорим, что вы должны иметь ваши архивные страницы deindexed, но если вы хотите сделать это, то, что правильный способ сделать это.

Вам не нужно добавлять страницу логина, каталога администратора или страницу регистрации в robots. txt, потому что логин и регистрационные страницы имеют теги NOINDEX, которые уже добавлены как мета-тег с помощью WordPress.

txt, потому что логин и регистрационные страницы имеют теги NOINDEX, которые уже добавлены как мета-тег с помощью WordPress.

Он рекомендуется запретить readme.html файл в файле robots.txt. Этот файл readme может быть использован кем-то, кто пытается выяснить, какую версию WordPress вы используете. Если бы это было физическое лицо, то они могут легко получить доступ к файлу, просто просматривая его.

С другой стороны, если кто-то работает с вредоносными запросами, чтобы найти сайты на WordPress с использованием конкретной версии, то этот тег Disallow может защитить вас от этих массовых атак.

Вы также можете запретить ваш каталог плагинов WordPress. Это будет способствовать укреплению безопасности вашего сайта, если кто-то ищет конкретный уязвимый плагин, чтобы использовать его для массовой атаки.

Добавление вашей XML Sitemap в файл robots.txt

Если вы используете плагин Йоаст в WordPress SEO или какой – либо другой плагин для генерации XML Sitemap , то ваш плагин будет пытаться автоматически добавлять связанные строки в вашем файле Sitemap в файл robots. txt.

txt.

Однако, если это не удается, то ваш плагин покажет вам ссылку на XML Sitemaps, который вы можете добавить в свой файл robots.txt вручную следующим образом:

Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Как должен выглядеть идеальный файл robots.txt?

Честно говоря, многие популярные блоги используют очень простые файлы robots.txt. Их содержание варьируются в зависимости от потребностей конкретного сайта:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Этот файл robots.txt просто сообщает всем ботам индексировать все содержание и предоставляет ссылки на XML Sitemaps сайта.

Вот еще один пример файла robots.txt, на этот раз это тот, который мы используем здесь на AndreyEx.ru:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-trackback Disallow: /wp-feed Disallow: /wp-comments Disallow: */trackback Disallow: */feed Disallow: */comments Disallow: /wp-login.php Disallow: /login.php Disallow: /wp-register.php Host: https://AndreyEx.ru User-agent: Googlebot Allow: /wp-content/plugins Allow: /wp-content/cache Sitemap: https://AndreyEx.ru/sitemap_index.xml

Это все. Мы надеемся , что эта статья помогла вам узнать , как оптимизировать ваш файл robots.txt для SEO. Вы также можете увидеть наш путеводитель по 9 лучшим WordPress SEO плагинам и инструментам, которые вы должны использовать.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Что такое robots.txt [Основы для новичков]

Успешная индексация нового сайта зависит от многих слагаемых. Один из них — файл robots.txt, с правильным заполнением которого должен быть знаком любой начинающий веб-мастер. Обновили материал для новичков.

Подробно о правилах составления файла в полном руководстве «Как составить robots.txt самостоятельно».

А в этом материале основы для начинающих, которые хотят быть в курсе профессиональных терминов.

Что такое robots.txt

Файл robots.txt — это документ в формате .txt, содержащий инструкции по индексации конкретного сайта для поисковых ботов. Он указывает поисковикам, какие страницы веб-ресурса стоит проиндексировать, а какие не нужно допустить к индексации.

Поисковый робот, придя к вам на сайт, первым делом пытается отыскать robots.txt. Если робот не нашел файл или он составлен неправильно, бот будет изучать сайт по своему собственному усмотрению. Далеко не факт, что он начнет с тех страниц, которые нужно вводить в поиск в первую очередь (новые статьи, обзоры, фотоотчеты и так далее). Индексация нового сайта может затянуться. Поэтому веб-мастеру нужно вовремя позаботиться о создании правильного файла robots.txt.

На некоторых конструкторах сайтов файл формируется сам. Например, Wix автоматически создает robots.txt. Чтобы посмотреть файл, добавьте к домену «/robots. txt». Если вы увидите там странные элементы типа «noflashhtml» и «backhtml», не пугайтесь: они относятся к структуре сайтов на платформе и не влияют на отношение поисковых систем.

txt». Если вы увидите там странные элементы типа «noflashhtml» и «backhtml», не пугайтесь: они относятся к структуре сайтов на платформе и не влияют на отношение поисковых систем.

Зачем нужен robots.txt

Казалось бы, зачем запрещать индексировать какое-то содержимое сайта? Далеко не весь контент, из которого состоит сайт, нужен поисковым роботам. Есть системные файлы, есть дубликаты страниц, есть рубрики ключевых слов и много чего еще есть, что вовсе не обязательно индексировать. Есть одно но:

Содержимое файла robots.txt — это рекомендации для ботов, а не жесткие правила. Рекомендации боты могут проигнорировать.

Google предупреждает, что через robots.txt нельзя заблокировать страницы для показа в Google. Даже если вы закроете доступ к странице в robots.txt, если на какой-то другой странице будет ссылка на эту, она может попасть в индекс. Лучше использовать и ограничения в robots, и другие методы запрета:

Запрет индексирования сайта, Яндекс

Блокировка индексирования, Google

Тем не менее, без robots. txt больше вероятность, что информация, которая должна быть скрыта, попадет в выдачу, а это бывает чревато раскрытием персональных данных и другими проблемами.

txt больше вероятность, что информация, которая должна быть скрыта, попадет в выдачу, а это бывает чревато раскрытием персональных данных и другими проблемами.

Из чего состоит robots.txt

Файл должен называться только «robots.txt» строчными буквами и никак иначе. Его размещают в корневом каталоге — https://site.com/robots.txt в единственном экземпляре. В ответ на запрос он должен отдавать HTTP-код со статусом 200 ОК. Вес файла не должен превышать 32 КБ. Это максимум, который будет воспринимать Яндекс, для Google robots может весить до 500 КБ.

Внутри все должно быть на латинице, все русские названия нужно перевести с помощью любого Punycode-конвертера. Каждый префикс URL нужно писать на отдельной строке.

В robots.txt с помощью специальных терминов прописываются директивы (команды или инструкции). Кратко о директивах для поисковых ботах:

«Us-agent:» — основная директива robots.txt

Используется для конкретизации поискового робота, которому будут давать указания. Например, User-agent: Googlebot или User-agent: Yandex.

Например, User-agent: Googlebot или User-agent: Yandex.

В файле robots.txt можно обратиться ко всем остальным поисковым системам сразу. Команда в этом случае будет выглядеть так: User-agent: *. Под специальным символом «*» принято понимать «любой текст».

После основной директивы «User-agent:» следуют конкретные команды.

Команда «Disallow:» — запрет индексации в robots.txt

При помощи этой команды поисковому роботу можно запретить индексировать веб-ресурс целиком или какую-то его часть. Все зависит от того, какое расширение у нее будет.

User-agent: Yandex Disallow: /

Такого рода запись в файле robots.txt означает, что поисковому роботу Яндекса вообще не позволено индексировать данный сайт, так как запрещающий знак «/» не сопровождается какими-то уточнениями.

User-agent: Yandex Disallow: /wp-admin

На этот раз уточнения имеются и касаются они системной папки wp-admin в CMS WordPress. То есть индексирующему роботу рекомендовано отказаться от индексации всей этой папки.

То есть индексирующему роботу рекомендовано отказаться от индексации всей этой папки.

Команда «Allow:» — разрешение индексации в robots.txt

Антипод предыдущей директивы. При помощи тех же самых уточняющих элементов, но используя данную команду в файле robots.txt, можно разрешить индексирующему роботу вносить нужные вам элементы сайта в поисковую базу.

User-agent: * Allow: /catalog Disallow: /

Разрешено сканировать все, что начинается с «/catalog», а все остальное запрещено.

На практике «Allow:» используется не так уж и часто. В ней нет надобности, поскольку она применяется автоматически. В robots «разрешено все, что не запрещено». Владельцу сайта достаточно воспользоваться директивой «Disallow:», запретив к индексации какое-то содержимое, а весь остальной контент ресурса воспринимается поисковым роботом как доступный для индексации.

Директива «Sitemap:» — указание на карту сайта

«Sitemap:» указывает индексирующему роботу правильный путь к так Карте сайта — файлам sitemap. xml и sitemap.xml.gz в случае с CMS WordPress.

xml и sitemap.xml.gz в случае с CMS WordPress.

User-agent: * Sitemap: http://pr-cy.ru/sitemap.xml Sitemap: http://pr-cy.ru/sitemap.xml.gz

Прописывание команды в файле robots.txt поможет поисковому роботу быстрее проиндексировать Карту сайта. Это ускорит процесс попадания страниц ресурса в выдачу.

Файл robots.txt готов — что дальше

Итак, вы создали текстовый документ robots.txt с учетом особенностей вашего сайта. Его можно сделать автоматически, к примеру, с помощью нашего инструмента.

Что делать дальше:

- проверить корректность созданного документа, например, посредством сервиса Яндекса;

- при помощи FTP-клиента закачать готовый файл в корневую папку своего сайта. В ситуации с WordPress речь обычно идет о системной папке Public_html.

Дальше остается только ждать, когда появятся поисковые роботы, изучат ваш robots.txt, а после возьмутся за индексацию вашего сайта.

Как посмотреть robots.txt чужого сайта

Если вам интересно сперва посмотреть на готовые примеры файла robots.txt в исполнении других, то нет ничего проще. Для этого в адресной строке браузера достаточно ввести site.ru/robots.txt. Вместо «site.ru» — название интересующего вас ресурса.

Полезное и интересное » Как правильно составить Robots.txt

Файл robots.txt является одним из самых важных при оптимизации любого сайта. Его отсутствие может привести к высокой нагрузке на сайт со стороны поисковых роботов и медленной индексации и переиндексации, а неправильная настройка к тому, что сайт полностью пропадет из поиска или просто не будет проиндексирован. Следовательно, не будет искаться в Яндексе, Google и других поисковых системах. Давайте разберемся во всех нюансах правильной настройки robots.txt.

Для начала короткое видео, которое создаст общее представление о том, что такое файл robots. txt.

txt.

Как влияет robots.txt на индексацию сайта

Поисковые роботы будут индексировать ваш сайт независимо от наличия файла robots.txt. Если же такой файл существует, то роботы могут руководствоваться правилами, которые в этом файле прописываются. При этом некоторые роботы могут игнорировать те или иные правила, либо некоторые правила могут быть специфичными только для некоторых ботов. В частности, GoogleBot не использует директиву Host и Crawl-Delay, YandexNews с недавних пор стал игнорировать директиву Crawl-Delay, а YandexDirect и YandexVideoParser игнорируют более общие директивы в роботсе (но руководствуются теми, которые указаны специально для них).

Подробнее об исключениях:

Исключения Яндекса

Стандарт исключений для роботов (Википедия)

Максимальную нагрузку на сайт создают роботы, которые скачивают контент с вашего сайта. Следовательно, указывая, что именно индексировать, а что игнорировать, а также с какими временны́ми промежутками производить скачивание, вы можете, с одной стороны, значительно снизить нагрузку на сайт со стороны роботов, а с другой стороны, ускорить процесс скачивания, запретив обход ненужных страниц.

Следовательно, указывая, что именно индексировать, а что игнорировать, а также с какими временны́ми промежутками производить скачивание, вы можете, с одной стороны, значительно снизить нагрузку на сайт со стороны роботов, а с другой стороны, ускорить процесс скачивания, запретив обход ненужных страниц.

К таким ненужным страницам относятся скрипты ajax, json, отвечающие за всплывающие формы, баннеры, вывод каптчи и т.д., формы заказа и корзина со всеми шагами оформления покупки, функционал поиска, личный кабинет, админка.

Для большинства роботов также желательно отключить индексацию всех JS и CSS. Но для GoogleBot и Yandex такие файлы нужно оставить для индексирования, так как они используются поисковыми системами для анализа удобства сайта и его ранжирования (пруф Google, пруф Яндекс).

Директивы robots.txt

Директивы — это правила для роботов. Есть спецификация W3C от 30 января 1994 года и расширенный стандарт от 1996 года. Однако не все поисковые системы и роботы поддерживают те или иные директивы. В связи с этим для нас полезнее будет знать не стандарт, а то, как руководствуются теми или иными директивы основные роботы.

В связи с этим для нас полезнее будет знать не стандарт, а то, как руководствуются теми или иными директивы основные роботы.

Давайте рассмотрим по порядку.

User-agent

Это самая главная директива, определяющая для каких роботов далее следуют правила.

Для всех роботов:User-agent: *

Для конкретного бота:User-agent: GoogleBot

Обратите внимание, что в robots.txt не важен регистр символов. Т.е. юзер-агент для гугла можно с таким же успехом записать соледующим образом:user-agent: googlebot

Ниже приведена таблица основных юзер-агентов различных поисковых систем.

| Бот | Функция |

|---|---|

| Googlebot | основной индексирующий робот Google |

| Googlebot-News | Google Новости |

| Googlebot-Image | Google Картинки |

| Googlebot-Video | видео |

| Mediapartners-Google | Google AdSense, Google Mobile AdSense |

| Mediapartners | Google AdSense, Google Mobile AdSense |

| AdsBot-Google | проверка качества целевой страницы |

| AdsBot-Google-Mobile-Apps | Робот Google для приложений |

| Яндекс | |

| YandexBot | основной индексирующий робот Яндекса |

| YandexImages | Яндекс. Картинки Картинки |

| YandexVideo | Яндекс.Видео |

| YandexMedia | мультимедийные данные |

| YandexBlogs | робот поиска по блогам |

| YandexAddurl | робот, обращающийся к странице при добавлении ее через форму «Добавить URL» |

| YandexFavicons | робот, индексирующий пиктограммы сайтов (favicons) |

| YandexDirect | Яндекс.Директ |

| YandexMetrika | Яндекс.Метрика |

| YandexCatalog | Яндекс.Каталог |

| YandexNews | Яндекс.Новости |

| YandexImageResizer | робот мобильных сервисов |

| Bing | |

| Bingbot | основной индексирующий робот Bing |

| Yahoo! | |

| Slurp | основной индексирующий робот Yahoo! |

Mail. Ru Ru |

|

| Mail.Ru | основной индексирующий робот Mail.Ru |

| Rambler | |

| StackRambler | Ранее основной индексирующий робот Rambler. Однако с 23.06.11 Rambler перестает поддерживать собственную поисковую систему и теперь использует на своих сервисах технологию Яндекса. Более не актуально. |

Disallow и Allow

Disallow закрывает от индексирования страницы и разделы сайта.

Allow принудительно открывает для индексирования страницы и разделы сайта.

Но здесь не все так просто.

Во-первых, нужно знать дополнительные операторы и понимать, как они используются — это *, $ и #.

* — это любое количество символов, в том числе и их отсутствие. При этом в конце строки звездочку можно не ставить, подразумевается, что она там находится по умолчанию.

$ — показывает, что символ перед ним должен быть последним.

# — комментарий, все что после этого символа в строке роботом не учитывается.

Примеры использования:

Disallow: *?s=

Disallow: /category/$

Следующие ссылки будут закрыты от индексации:

http://site.ru/?s=

http://site.ru/?s=keyword

http://site.ru/page/?s=keyword

http://site.ru/category/

Следующие ссылки будут открыты для индексации:

http://site.ru/category/cat1/

http://site.ru/category-folder/

Во-вторых, нужно понимать, каким образом выполняются вложенные правила.

Помните, что порядок записи директив не важен. Наследование правил, что открыть или закрыть от индексации определяется по тому, какие директории указаны. Разберем на примере.

Allow: *.css

Disallow: /template/

http://site.ru/template/ — закрыто от индексирования

http://site.ru/template/style.css — закрыто от индексирования

http://site. ru/style.css — открыто для индексирования

ru/style.css — открыто для индексирования

http://site.ru/theme/style.css — открыто для индексирования

Если нужно, чтобы все файлы .css были открыты для индексирования придется это дополнительно прописать для каждой из закрытых папок. В нашем случае:

Allow: *.css

Allow: /template/*.css

Disallow: /template/

Повторюсь, порядок директив не важен.

Sitemap

Директива для указания пути к XML-файлу Sitemap. URL-адрес прописывается так же, как в адресной строке.

Например,

Sitemap: http://site.ru/sitemap.xml

Директива Sitemap указывается в любом месте файла robots.txt без привязки к конкретному user-agent. Можно указать несколько правил Sitemap.

Host

Директива для указания главного зеркала сайта (в большинстве случаев: с www или без www). Обратите внимание, что главное зеркало указывается БЕЗ http://, но С https://. Также если необходимо, то указывается порт.

Директива поддерживается только ботами Яндекса и Mail.Ru. Другими роботами, в частности GoogleBot, команда не будет учтена. Host прописывается только один раз!

Пример 1:Host: site.ru

Пример 2:Host: https://site.ru

Crawl-delay

Директива для установления интервала времени между скачиванием роботом страниц сайта. Поддерживается роботами Яндекса, Mail.Ru, Bing, Yahoo. Значение может устанавливаться в целых или дробных единицах (разделитель — точка), время в секундах.

Пример 1:Crawl-delay: 3

Пример 2:Crawl-delay: 0.5

Если сайт имеет небольшую нагрузку, то необходимости устанавливать такое правило нет. Однако если индексация страниц роботом приводит к тому, что сайт превышает лимиты или испытывает значительные нагрузки вплоть до перебоев работы сервера, то эта директива поможет снизить нагрузку.

Чем больше значение, тем меньше страниц робот загрузит за одну сессию. Оптимальное значение определяется индивидуально для каждого сайта. Лучше начинать с не очень больших значений — 0.1, 0.2, 0.5 — и постепенно их увеличивать. Для роботов поисковых систем, имеющих меньшее значение для результатов продвижения, таких как Mail.Ru, Bing и Yahoo можно изначально установить бо́льшие значения, чем для роботов Яндекса.

Оптимальное значение определяется индивидуально для каждого сайта. Лучше начинать с не очень больших значений — 0.1, 0.2, 0.5 — и постепенно их увеличивать. Для роботов поисковых систем, имеющих меньшее значение для результатов продвижения, таких как Mail.Ru, Bing и Yahoo можно изначально установить бо́льшие значения, чем для роботов Яндекса.

Clean-param

Это правило сообщает краулеру, что URL-адреса с указанными параметрами не нужно индексировать. Для правила указывается два аргумента: параметр и URL раздела. Директива поддерживается Яндексом.

Пример 1:

Clean-param: author_id http://site.ru/articles/

http://site.ru/articles/?author_id=267539 — индексироваться не будет

Пример 2:

Clean-param: author_id&sid http://site.ru/articles/

http://site.ru/articles/?author_id=267539&sid=0995823627 — индексироваться не будет

Яндекс также рекомендует использовать эту директиву для того, чтобы не учитывались UTM-метки и идентификаторы сессий. Пример:

Пример:

Clean-Param: utm_source&utm_medium&utm_campaign

Другие параметры

В расширенной спецификации robots.txt можно найти еще параметры Request-rate и Visit-time. Однако они на данный момент не поддерживаются ведущими поисковыми системами.

Смысл директив:

Request-rate: 1/5 — загружать не более одной страницы за пять секунд

Visit-time: 0600-0845 — загружать страницы только в промежуток с 6 утра до 8:45 по Гринвичу.

Закрывающий robots.txt

Если вам нужно настроить, чтобы ваш сайт НЕ индексировался поисковыми роботами, то вам нужно прописать следующие директивы:

User-agent: * Disallow: /

Проверьте, чтобы на тестовых площадках вашего сайта были прописаны эти директивы.

Правильная настройка robots.txt

Для России и стран СНГ, где доля Яндекса ощутима, следует прописывать директивы для всех роботов и отдельно для Яндекса и Google.

Чтобы правильно настроить robots. txt воспользуйтесь следующим алгоритмом:

txt воспользуйтесь следующим алгоритмом:

- Закройте от индексирования админку сайта

- Закройте от индексирования личный кабинет, авторизацию, регистрацию

- Закройте от индексирования корзину, формы заказа, данные по доставке и заказам

- Закройте от индексирования ajax, json-скрипты

- Закройте от индексирования папку cgi

- Закройте от индексирования плагины, темы оформления, js, css для всех роботов, кроме Яндекса и Google

- Закройте от индексирования функционал поиска

- Закройте от индексирования служебные разделы, которые не несут никакой ценности для сайта в поиске (ошибка 404, список авторов)

- Закройте от индексирования технические дубли страниц, а также страницы, на которых весь контент в том или ином виде продублирован с других страниц (календари, архивы, RSS)

- Закройте от индексирования страницы с параметрами фильтров, сортировки, сравнения

- Закройте от индексирования страницы с параметрами UTM-меток и сессий

- Проверьте, что проиндексировано Яндексом и Google с помощью параметра «site:» (в поисковой строке наберите «site:site.

ru»). Если в поиске присутствуют страницы, которые также нужно закрыть от индексации, добавьте их в robots.txt

ru»). Если в поиске присутствуют страницы, которые также нужно закрыть от индексации, добавьте их в robots.txt - Укажите Sitemap и Host

- По необходимости пропишите Crawl-Delay и Clean-Param

- Проверьте корректность robots.txt через инструменты Google и Яндекса (описано ниже)

- Через 2 недели перепроверьте, появились ли в поисковой выдаче новые страницы, которые не должны индексироваться. В случае необходимости повторить выше перечисленные шаги.

Пример robots.txt

# Пример файла robots.txt для настройки гипотетического сайта https://site.ru User-agent: * Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: */?s= Disallow: *sort= Disallow: *view= Disallow: *utm= Crawl-Delay: 5 User-agent: GoogleBot Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: */?s= Disallow: *sort= Disallow: *view= Disallow: *utm= Allow: /plugins/*.css Allow: /plugins/*.js Allow: /plugins/*.png Allow: /plugins/*.jpg Allow: /plugins/*.gif User-agent: Yandex Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: */?s= Disallow: *sort= Disallow: *view= Allow: /plugins/*.css Allow: /plugins/*.js Allow: /plugins/*.png Allow: /plugins/*.jpg Allow: /plugins/*.gif Clean-Param: utm_source&utm_medium&utm_campaign Crawl-Delay: 0.5 Sitemap: https://site.ru/sitemap.xml Host: https://site.ru

Как добавить и где находится robots.txt

После того как вы создали файл robots.txt, его необходимо разместить на вашем сайте по адресу site.ru/robots.txt — т.е. в корневом каталоге. Поисковый робот всегда обращается к файлу по URL /robots.txt

Как проверить robots.txt

Проверка robots.txt осуществляется по следующим ссылкам:

Типичные ошибки в robots.txt

В конце статьи приведу несколько типичных ошибок файла robots. txt

txt

- robots.txt отсутствует

- в robots.txt сайт закрыт от индексирования (Disallow: /)

- в файле присутствуют лишь самые основные директивы, нет детальной проработки файла

- в файле не закрыты от индексирования страницы с UTM-метками и идентификаторами сессий

- в файле указаны только директивы

Allow: *.css

Allow: *.js

Allow: *.png

Allow: *.jpg

Allow: *.gif

при этом файлы css, js, png, jpg, gif закрыты другими директивами в ряде директорий - директива Host прописана несколько раз

- в Host не указан протокол https

- путь к Sitemap указан неверно, либо указан неверный протокол или зеркало сайта

P.S.

Если у вас есть дополнения к статье или вопросы, пишите ниже в комментариях.

Если у вас сайт на CMS WordPress, вам будет полезна статья «Как настроить правильный robots. txt для WordPress».

txt для WordPress».

P.S.2

Полезное видео от Яндекса (Внимание! Некоторые рекомендации подходят только для Яндекса).

WordPress Руководство Robots.txt — что это такое и как его использовать

Вы когда-нибудь слышали термин robots.txt и задавались вопросом, как он применим к вашему веб-сайту? На большинстве веб-сайтов есть файл robots.txt, но это не значит, что большинство веб-мастеров его понимают. В этом посте мы надеемся изменить это, предложив более подробное описание файла robots.txt WordPress, а также того, как он может контролировать и ограничивать доступ к вашему сайту. К концу вы сможете ответить на такие вопросы, как:

Есть много чего рассказать, так что приступим!

Что такое роботы WordPress.текст?

Прежде чем мы сможем говорить о файле robots.txt WordPress, важно определить, что в данном случае представляет собой «робот». Роботы — это любой тип «бота», который посещает веб-сайты в Интернете. Самый распространенный пример — сканеры поисковых систем. Эти боты «ползают» по сети, чтобы помочь поисковым системам, таким как Google, индексировать и ранжировать миллиарды страниц в Интернете.

Роботы — это любой тип «бота», который посещает веб-сайты в Интернете. Самый распространенный пример — сканеры поисковых систем. Эти боты «ползают» по сети, чтобы помочь поисковым системам, таким как Google, индексировать и ранжировать миллиарды страниц в Интернете.

Итак, боты есть, вообще , вещь для интернета хорошая… или хотя бы необходимая вещь. Но это не обязательно означает, что вы или другие веб-мастера хотите, чтобы боты работали без ограничений.Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию стандарта исключения роботов в середине 1990-х годов. Robots.txt — это практическая реализация этого стандарта — , он позволяет вам контролировать, как участвующие боты взаимодействуют с вашим сайтом. . Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Эта «участвующая» часть, тем не менее, важна. Robots.txt не может заставить бота следовать его директивам. А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже авторитетные организации игнорируют и некоторые команды , которые вы можете поместить в Robots.txt. Например, Google проигнорирует любые правила, которые вы добавляете в свой robots.txt, о том, как часто заходят его сканеры. Если у вас много проблем с ботами, вам может пригодиться такое решение безопасности, как Cloudflare или Sucuri.

А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже авторитетные организации игнорируют и некоторые команды , которые вы можете поместить в Robots.txt. Например, Google проигнорирует любые правила, которые вы добавляете в свой robots.txt, о том, как часто заходят его сканеры. Если у вас много проблем с ботами, вам может пригодиться такое решение безопасности, как Cloudflare или Sucuri.

Почему вам следует заботиться о своем файле Robots.txt?

Для большинства веб-мастеров преимущества хорошо структурированного файла robots.txt можно разделить на две категории:

- Оптимизация ресурсов сканирования поисковых систем путем указания им не тратить время на страницы, которые вы не хотите индексировать. Это помогает гарантировать, что поисковые системы сосредоточатся на сканировании наиболее важных для вас страниц.

- Оптимизация использования вашего сервера за счет блокировки ботов, тратящих ресурсы впустую.

Robots.

txt конкретно не о контроле того, какие страницы индексируются в поисковых системах

txt конкретно не о контроле того, какие страницы индексируются в поисковых системахRobots.txt не является надежным способом контролировать, какие страницы индексируются поисковыми системами.Если ваша основная цель — предотвратить включение определенных страниц в результаты поисковых систем, правильным подходом будет использование метатега noindex или другого аналогичного прямого метода.

Это связано с тем, что ваш файл Robots.txt напрямую не говорит поисковым системам не индексировать контент — он просто говорит им не сканировать его. Хотя Google не будет сканировать отмеченные области внутри вашего сайта, сам Google заявляет, что если внешний сайт ссылается на страницу, которую вы исключаете с помощью файла Robots.txt, Google все равно может проиндексировать эту страницу.

Джон Мюллер, аналитик Google для веб-мастеров, также подтвердил, что, если на странице есть ссылки, указывающие на нее, даже если она заблокирована файлом robots.txt, все равно может проиндексироваться. Вот что он сказал на видеовстрече в Центре веб-мастеров:

Вот что он сказал на видеовстрече в Центре веб-мастеров:

Здесь следует иметь в виду одну вещь: если эти страницы заблокированы файлом robots.txt, то теоретически может случиться так, что кто-то случайно сделает ссылку на одну из этих страниц. И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован роботами.текст. Таким образом, мы не узнаем, что вы не хотите, чтобы эти страницы действительно индексировались.

Если они не заблокированы файлом robots.txt, вы можете разместить на этих страницах метатег noindex. И если кто-то будет ссылаться на них, и мы просканируем эту ссылку и подумаем, что, может быть, здесь есть что-то полезное, тогда мы будем знать, что эти страницы не нужно индексировать, и мы можем просто полностью пропустить их из индексации.

Итак, в связи с этим, если у вас есть что-то на этих страницах, что вы не хотите индексировать, не запрещайте их, используйте вместо этого noindex .

Как создать и отредактировать файл WordPress Robots.txt

По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы не пошевелите пальцем, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/robots.txt» в конец своего доменного имени. Например, «https://kinsta.com/robots.txt» вызывает файл robots.txt, который мы используем здесь, в Kinsta:

Пример файла Robots.txt

Поскольку этот файл виртуальный, вы не можете его редактировать.Если вы хотите отредактировать файл robots.txt, вам нужно будет фактически создать физический файл на своем сервере, которым вы можете управлять по мере необходимости. Вот три простых способа сделать это…

Как создать и отредактировать файл Robots.txt с помощью Yoast SEO

Если вы используете популярный плагин Yoast SEO, вы можете создать (а позже отредактировать) файл robots.txt прямо из интерфейса Yoast. Однако, прежде чем вы сможете получить к нему доступ, вам необходимо включить расширенные функции Yoast SEO, перейдя в SEO → Dashboard → Features и переключившись на страницы дополнительных настроек :

Однако, прежде чем вы сможете получить к нему доступ, вам необходимо включить расширенные функции Yoast SEO, перейдя в SEO → Dashboard → Features и переключившись на страницы дополнительных настроек :

Как включить расширенные функции Yoast

После активации вы можете перейти к SEO → Инструменты и нажать Редактор файлов :

Как получить доступ к редактору файлов Yoast

Если у вас еще нет физического робота.txt, Yoast даст вам возможность Создать файл robots.txt :

Как создать Robots.txt в Yoast

И как только вы нажмете эту кнопку, вы сможете редактировать содержимое своего файла Robots.txt прямо из того же интерфейса:

Как редактировать Robots.txt в Yoast

По мере чтения мы подробнее рассмотрим, какие типы директив следует добавлять в файл robots.txt WordPress.

Как создать и отредактировать файл Robots.txt с помощью универсального SEO

Если вы используете почти такой же популярный, как Yoast All in One SEO Pack плагин, вы также можете создавать и редактировать свои роботы WordPress. txt прямо из интерфейса плагина. Все, что вам нужно сделать, это перейти к All in One SEO → Feature Manager и Активировать файл Robots.txt feature:

txt прямо из интерфейса плагина. Все, что вам нужно сделать, это перейти к All in One SEO → Feature Manager и Активировать файл Robots.txt feature:

Как создать Robots.txt в All In One SEO

Затем вы сможете управлять своим файлом Robots.txt, перейдя в All in One SEO → Robots.txt:

Как редактировать Robots.txt в All In One SEO

Как создать и отредактировать файл Robots.txt через FTP

Если вы не используете плагин SEO, который предлагает robots.txt, вы по-прежнему можете создавать файл robots.txt и управлять им через SFTP. Сначала с помощью любого текстового редактора создайте пустой файл с именем «robots.txt»:

Как создать свой собственный файл Robots.txt

Затем подключитесь к своему сайту через SFTP и загрузите этот файл в корневую папку вашего сайта. Вы можете внести дополнительные изменения в свой файл robots.txt, отредактировав его через SFTP или загрузив новые версии файла.

Что помещать в файл robots.txt

Хорошо, теперь у вас есть физический робот.txt на вашем сервере, который вы можете редактировать по мере необходимости. Но что вы на самом деле делаете с этим файлом? Как вы узнали из первого раздела, robots.txt позволяет вам контролировать, как роботы взаимодействуют с вашим сайтом. Вы делаете это с помощью двух основных команд:

- User-agent — позволяет настраивать таргетинг на определенных ботов. Пользовательские агенты — это то, что боты используют для идентификации себя. С их помощью вы можете, например, создать правило, которое применяется к Bing, но не к Google.

- Запретить — позволяет запретить роботам доступ к определенным областям вашего сайта.

Существует также команда Allow , которую вы будете использовать в нишевых ситуациях. По умолчанию все на вашем сайте помечено как Allow , поэтому нет необходимости использовать команду Allow в 99% случаев. Но он пригодится, если вы хотите Запретить доступ к папке и ее дочерним папкам, но Разрешить доступ к одной конкретной дочерней папке.

Но он пригодится, если вы хотите Запретить доступ к папке и ее дочерним папкам, но Разрешить доступ к одной конкретной дочерней папке.

Вы добавляете правила, сначала указывая, к какому User-agent должно применяться правило, а затем перечисляя, какие правила применять, используя Disallow и Allow .Есть также некоторые другие команды, такие как Crawl-delay и Sitemap , но это либо:

- Игнорируется большинством основных поисковых роботов или интерпретируется совершенно по-разному (в случае задержки сканирования)

- Изменилось с помощью таких инструментов, как Google Search Console (для карт сайта)

Давайте рассмотрим некоторые конкретные примеры использования, чтобы показать вам, как все это сочетается.

Как использовать Robots.txt для блокировки доступа ко всему сайту

Допустим, вы хотите заблокировать всем поисковым роботам доступ к вашему сайту. На живом сайте это вряд ли произойдет, но для сайта разработки это пригодится. Для этого вы должны добавить этот код в свой файл robots.txt WordPress:

На живом сайте это вряд ли произойдет, но для сайта разработки это пригодится. Для этого вы должны добавить этот код в свой файл robots.txt WordPress:

Агент пользователя: *

Disallow: / Что происходит в этом коде?

Звездочка * рядом с User-agent означает «все пользовательские агенты». Звездочка — это подстановочный знак, означающий, что он применяется к каждому пользовательскому агенту. / косая черта рядом с Disallow означает, что вы хотите запретить доступ к всем страницам , которые содержат «yourdomain.com / ”(т.е. каждая страница вашего сайта).

Как использовать Robots.txt, чтобы заблокировать доступ одного бота к вашему сайту

Давайте изменим ситуацию. В этом примере мы сделаем вид, что вам не нравится, что Bing сканирует ваши страницы. Вы полностью работаете в команде Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать сканирование вашего сайта только Bing, замените подстановочный знак * звездочку на Bingbot:

Чтобы заблокировать сканирование вашего сайта только Bing, замените подстановочный знак * звездочку на Bingbot:

Подпишитесь на информационный бюллетень

Мы увеличили наш трафик на 1187% с помощью WordPress.

Мы покажем вам, как это сделать.

Присоединяйтесь к более чем 20 000 других людей, которые получают нашу еженедельную рассылку с инсайдерскими советами по WordPress!

Пользовательский агент: Bingbot

Disallow: / По сути, приведенный выше код говорит , что только применяет правило Disallow к ботам с пользовательским агентом «Bingbot» . Теперь вы вряд ли захотите блокировать доступ к Bing, но этот сценарий действительно пригодится, если есть конкретный бот, которому вы не хотите получать доступ к своему сайту.На этом сайте есть хороший список известных имен User-agent большинства сервисов.

Как использовать Robots.txt для блокировки доступа к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и всем ее подпапкам). Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

- Вся папка wp-admin

- wp-login.php

Вы можете использовать следующие команды:

Агент пользователя: *

Запретить: / wp-admin /

Запретить: / wp-login.php Как использовать Robots.txt для разрешения доступа к определенному файлу в запрещенной папке

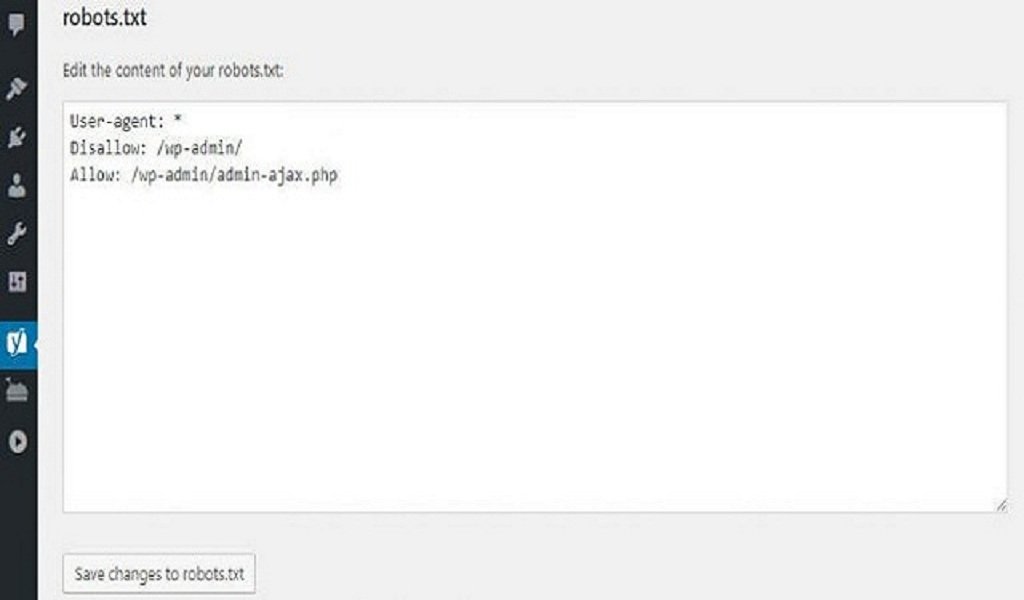

Хорошо, теперь допустим, что вы хотите заблокировать всю папку, но все же хотите разрешить доступ к определенному файлу внутри этой папки. Здесь вам пригодится команда Allow . И это действительно очень применимо к WordPress. Фактически, виртуальный файл robots.txt WordPress прекрасно иллюстрирует этот пример:

Агент пользователя: *

Запретить: / wp-admin /

Разрешить: / wp-admin / admin-ajax. php

php Этот фрагмент блокирует доступ ко всей папке / wp-admin / , за исключением файла /wp-admin/admin-ajax.php .

Как использовать Robots.txt, чтобы запретить ботам сканировать результаты поиска WordPress

Одна специальная настройка WordPress, которую вы, возможно, захотите сделать, — это запретить поисковым роботам сканировать ваши страницы результатов поиска. По умолчанию WordPress использует параметр запроса «? S =». Итак, чтобы заблокировать доступ, все, что вам нужно сделать, это добавить следующее правило:

Агент пользователя: *

Запретить: /? S =

Disallow: / search / Это также может быть эффективным способом остановить мягкие ошибки 404, если вы их получаете.Обязательно прочтите наше подробное руководство о том, как ускорить поиск в WordPress.

Как создать разные правила для разных ботов в robots.txt

До сих пор все примеры касались одного правила за раз. Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в объявление User-agent для каждого бота. Например, если вы хотите создать одно правило, которое применяется к , все боты , а другое правило, которое применяется к , только Bingbot , вы можете сделать это следующим образом:

Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в объявление User-agent для каждого бота. Например, если вы хотите создать одно правило, которое применяется к , все боты , а другое правило, которое применяется к , только Bingbot , вы можете сделать это следующим образом:

Агент пользователя: *

Запретить: / wp-admin /

Пользовательский агент: Bingbot

Disallow: / В этом примере всем ботам будет заблокирован доступ к / wp-admin /, но Bingbot будет заблокирован от доступа ко всему вашему сайту.

Тестирование файла Robots.txt

Вы можете проверить свой файл robots.txt WordPress в консоли поиска Google, чтобы убедиться, что он правильно настроен. Просто нажмите на свой сайт и в разделе «Сканирование» нажмите «Тестер robots.txt». Затем вы можете отправить любой URL, включая вашу домашнюю страницу. Вы должны увидеть зеленый Разрешено , если все доступно для сканирования. Вы также можете проверить URL-адреса, которые вы заблокировали, чтобы убедиться, что они действительно заблокированы, или Disallowed .

Вы должны увидеть зеленый Разрешено , если все доступно для сканирования. Вы также можете проверить URL-адреса, которые вы заблокировали, чтобы убедиться, что они действительно заблокированы, или Disallowed .

Тестовый файл robots.txt

Остерегайтесь спецификации UTF-8

BOM обозначает отметку порядка байтов и, по сути, является невидимым символом, который иногда добавляется к файлам старыми текстовыми редакторами и т.п.Если это произойдет с вашим файлом robots.txt, Google может неправильно его прочитать. Вот почему так важно проверять файл на наличие ошибок. Например, как показано ниже, в нашем файле был невидимый символ, и Google жалуется на непонимание синтаксиса. Это по существу делает недействительной первую строку нашего файла robots.txt, что не очень хорошо! У Гленна Гейба есть отличная статья о том, как бомба UTF-8 может убить вашего SEO.

Спецификация UTF-8 в вашем файле robots.txt

Робот Googlebot находится в основном в США.

Также важно не блокировать Googlebot из США, даже если вы нацеливаетесь на регион за пределами США.Иногда они выполняют локальное сканирование, но робот Google в основном находится в США.

Робот Googlebot в основном находится в США, но иногда мы также выполняем локальное сканирование. https://t.co/9KnmN4yXpe

— Центр поиска Google (@googlesearchc) 13 ноября 2017 г.

Что популярные сайты WordPress помещают в свой файл Robots.txt

Чтобы предоставить некоторый контекст для перечисленных выше пунктов, вот как некоторые из самых популярных сайтов WordPress используют своих роботов.txt файлы.

TechCrunch

TechCrunch Файл Robots.txt

Помимо ограничения доступа к ряду уникальных страниц, TechCrunch, в частности, запрещает поисковым роботам:

Еще они установили особые ограничения для двух ботов:

Если вам интересно, IRLbot — это сканер из исследовательского проекта Техасского университета A&M. Это странно!

Это странно!

Фонд Обамы

Файл Robots.txt Фонда Обамы

Фонд Обамы не делал никаких специальных дополнений, предпочитая ограничивать доступ исключительно к / wp-admin /.

Angry Birds

Angry Birds Файл Robots.txt

Angry Birds имеет те же настройки по умолчанию, что и The Obama Foundation. Ничего особенного не добавлено.

Дрифт

Drift Robots.txt Файл

Наконец, Drift решает определить свои карты сайта в файле Robots.txt, но в остальном оставляет те же ограничения по умолчанию, что и The Obama Foundation и Angry Birds.

Правильно используйте Robots.txt

Завершая наше руководство по robots.txt, мы хотим еще раз напомнить вам, что использование команды Disallow в вашем файле robots.txt — это не то же самое, что использовать тег noindex . Robots.txt блокирует сканирование, но не обязательно индексацию. Вы можете использовать его для добавления определенных правил, определяющих, как поисковые системы и другие боты взаимодействуют с вашим сайтом, но он не будет явно контролировать, индексируется ваш контент или нет.