Читайте про Дубли страниц в нашем словаре SEO терминов

Дубли страниц — различные интернет-страницы конкретного ресурса с максимально схожим или полностью идентичным контентом. Бытует мнение, что дубликаты являются совершенно безобидными. Это относится лишь к пользователям, для которых присутствие таких страниц не играет особой роли. Но в отношении продвижения и ранжирования сайтов поисковиками они способны создать негативный эффект.

Отрицательные факторы влияния дублей:

- Индексация. Дублирующийся контент заставляет ботов поисковых систем терять драгоценный краулинговый бюджет на такие страницы. При этом действительно важная информация сайта может остаться без индексации.

- Понижение процента общей уникальности контента, размещенного на портале.

- Внешние ссылки продвигаемых интернет-страниц теряют вес. Это происходит, когда посетитель делится ссылкой на страницу-дубликат.

- Неуникальный контент.

- Возможность продвижения нерелевантной интернет-страницы. Поисковик способен отображать в результатах выдачи совершенно не ту страницу, которую оптимизатор пытается продвинуть.

Страничные дубли являются частичными, либо же полными. В полных дублях контент абсолютно идентичен, в частичных – контент похож. При этом более безопасными и безобидными считаются частичные дубли, ведь они не дают сайту сильно пострадать из-за своего присутствия. Хотя постепенное понижение в ранжировании все равно может происходить. Что касается полных дубликатов, то подобные страницы зачастую обнаруживаются в интернет-магазинах (карточки и описание товаров).

Почему же появляются дубли? Например, они в состоянии автоматически генерироваться движком сайта. Либо же речь может идти о корректировке структуры портала. В этом случае старые адреса не только сохраняются, но и дополнительно получают новые адреса.

Поиск страниц-дублей на сайте

Далее будут представлены самые эффективные способы поиска дублей интернет-страниц.

Сканирование ресурса благодаря специализированным приложениям

Выявлять дубликаты можно с помощью особых программ (например, Screaming Frog Seo Spider, NetPeak Spider), которые являются платными или бесплатными. Такие приложения умеют довольно быстро сканировать ресурс, чтобы найти дубли. В этих программах возможно осуществить выгрузку списка URL-адресов. Есть возможность отсортировать результаты по тегам Description и Title. Это позволяет оперативно находить повторяющийся текстовый контент.

Вебмастер Google или Yandex

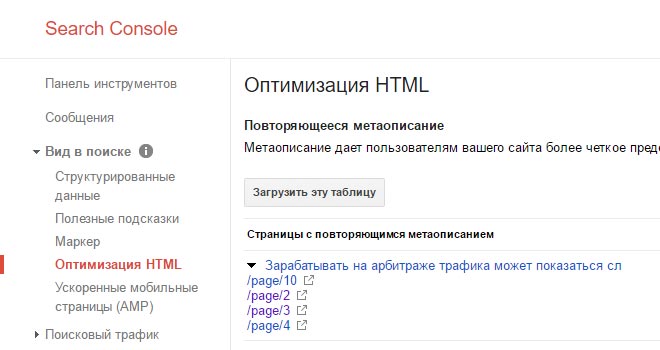

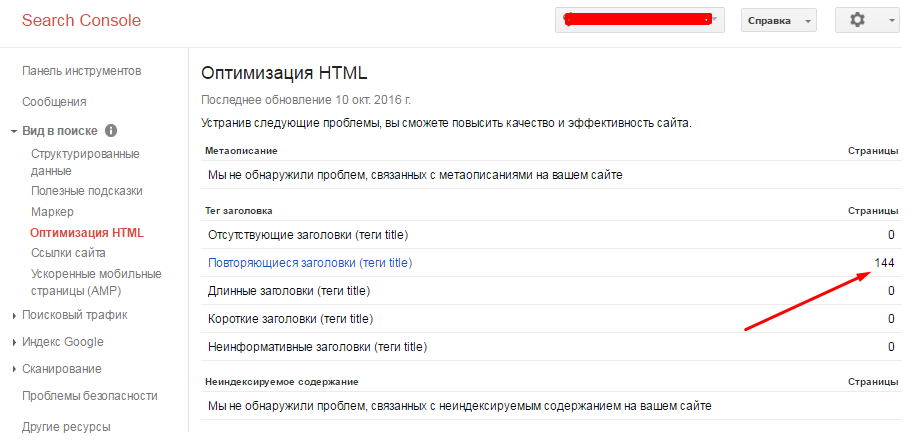

Вот как происходит поиск дублей в соответствующей консоли Google:

- открываем панель инструментов;

- нажимаем на пункт «Вид в поиске»;

- выбираем «Оптимизация HTML».

Теперь дубликаты можно увидеть в разделе «Повторяющиеся заголовки».

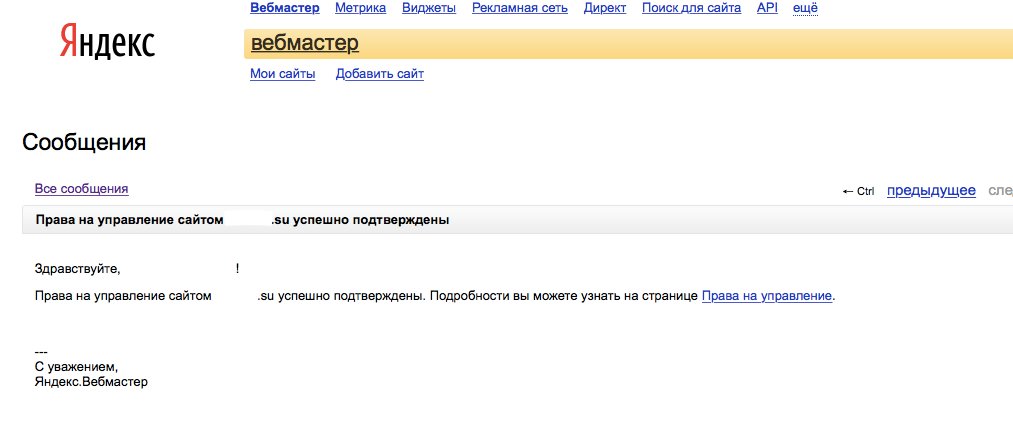

Ищем дубли страниц в Яндексе:

- находим пункт «Страницы в поиске», который располагается в сервисе Яндекс.Вебмастер;

- переходим в «Исключенные страницы»;

- сейчас нам нужна «Сортировка: Дубль»;

- не забываем применять действия;

- система осуществит выдачу повторяющихся страниц.

Если это необходимо, то всегда можно выгрузить готовый список для собственных нужд.

Ручной поиск

Профессиональный вебмастер способен отыскать дубли вручную. Как правило, для этих целей используется url-адрес ресурса. Он многократно вводится с помощью различных вариаций (например, добавляются какие-то знаки или символы).

Оператор «site:»

Открываем поисковую строку, чтобы ввести «site:site_name.ru». В выдаче появятся все страницы вашего ресурса, прошедшие индексацию. Такой метод дает возможность отыскать не только страницы-дубли, но и «мусорный» контент.

Удаляем дубли страниц

Нет желания постоянно заниматься выявлением дублей страниц, а также их закрытием от поисковиков? Тогда лучше раз и навсегда от них избавиться.

Файл .htaccess и 301 редирект

Если дубли появились абсолютно случайно (к примеру, был использован двойной пробел), то можно воспользоваться обычной настройкой 301 редиректа. Для этого нужно установить необходимое перенаправление при помощи файла .htaccess.

Запрет индексации страниц-дублей через robots.txt

Есть возможность закрыть некоторые интернет-страницы от роботов поисковых систем. В файле robots.txt прописываем:

User-agent: *

Disallow: /page-name

Такой способ будет максимально эффективен в отношении служебных страниц, повторяющих контент главной страницы площадки. Если же интернет-страница уже присутствует в индексе, тогда данный метод может не работать.

Указание канонической старницы

Мы можем задать каноническую страницу для последующего индексирования используя тег rel=»canonical». При этом она будет открыта для просмотра. Это очень полезно для различных фильтров, а также страниц-сортировок. Нужно лишь указать соответствующий атрибут canonical в теге <link>. Причем делается это в коде HTML текущей интернет-страницы.

При этом она будет открыта для просмотра. Это очень полезно для различных фильтров, а также страниц-сортировок. Нужно лишь указать соответствующий атрибут canonical в теге <link>. Причем делается это в коде HTML текущей интернет-страницы.

Мета-тег

Есть возможность насильно запретить роботам поисковиков индексировать определенные документы при помощи тега noindex. Благодаря этому специальные боты не будут переходить по ссылкам. Сам тег располагается в блоке <meta name=»robots» content=»noindex, nofollow> или <meta name=»robots» content=»noindex, follow>

Данный вариант очень часто применяется, когда речь заходит о вкладках с пользовательскими отзывами о том или ином товаре или услуге.

Когда повторяющийся контент будет удален (или скрыт), то рекомендуется осуществить повторную проверку ресурса. Причем делать это нужно регулярно, чтобы случайно не выпасть из рейтинга поисковых систем. Важно, чтобы количество страниц с дублирующимися материалами было сведено к минимуму, либо же вообще равнялось нулю.

Поиск дублей страниц сайта | Как проверить онлайн и убрать дубли

Сколько раз делаю технический аудит какого-нибудь клиентского сайта, так обязательно нахожу дубли страниц. Это особенная проблема для больших интернет магазинов. Давайте сейчас разберемся, как эту проблему диагностировать и решить.

Дубли сайта — это страницы с идентичным или почти одинаковым контентом но разными URL.

Дублями могут быть мета-теги title и description, могут быть дубли текста или полного контента, то есть всего содержимого страницы. Наиболее часто дублями бывают страницы пагинации, карточки товаров, страницы фильтра или теги.

Причем частичное совпадение контента допустимо, например, в каких-то карточках товаров могут дублироваться характеристики или какие-то блоки на странице могут дублироваться, например, отзывы. Но если взять сайт в целом, то каждая страница на сайте должна быть уникальной.

От дублей страниц очень много бед для сайта.

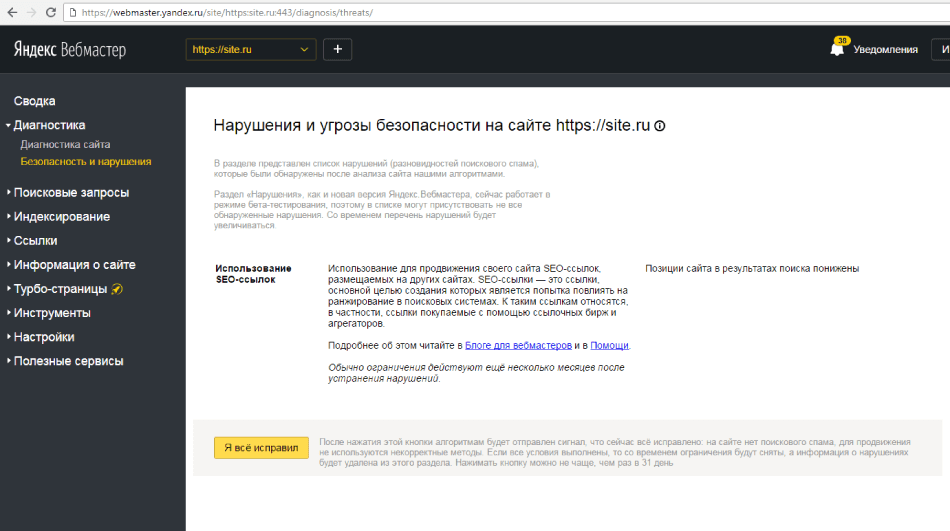

Например, яндекс идентифицирует дубли, они отображаются в яндекс вебмастере, он просто выплевывает их из выдачи.

А google наоборот их хранит и при достижении какого-то критического значения накладывает фильтр на сайт. В общем, вреда от дублей для сайта много и поэтому от них обязательно нужно избавляться.

Но для начала их нужно идентифицировать, и есть несколько способов поиска и проверки дублей страниц сайта онлайн, я разберу способы ручные и способы автоматизированные. Эти способы являются универсальными и подойдут для любого движка, будь то wordpress, битрикс, opencart, joomla и других.

Проверка дублей через яндекс вебмастер

Самый простой способ, если у вас есть яндекс вебмастер, вы можете зайти в раздел «Индексирование — страницы в поиске».

Выбрать здесь «Исключенные страницы» и посмотреть, нет ли у вас вот такой картины.

Вебмастер показывает, что это дубли, и если такое присутствует, то нужно от этого избавляться. Дальше я покажу, какие есть варианты исправить их.

Поиск через индекс поисковых систем

Следующий способ также ручной — нужно вбить в поисковую строку google такую комбинацию site:santerma.shop (после двоеточия адрес вашего сайта), и покажутся все страницы, которые есть в индексе поисковой системы.

Аналогично работает и в яндексе.

Затем вручную пройтись по сайту и посмотреть, какие есть проблемы. Например, вот видно, есть какие-то дубликаты заголовков — интернет магазин сантехники и водоподготовки САНТЕРМА.

Можно перейти и посмотреть, что это за дубликаты, заголовки у них одинаковые, получается страницы тоже могут быть одинаковые.

Это страницы пагинации, о чем я и говорил, что очень часто дублями является такие страницы. То есть сами страницы не являются дублями, но здесь дубли мета-теги, тайтл у всех этих страниц одинаковый.

Это означает, что вот таких страниц «Интернет магазин сантехники и водоподготовки» очень много, соответственно, эту проблему тоже нужно решать, для страниц пагинации делают rel canonical.

Как проверить дубли с помощью Screaming Frog

Следующий способ, как можно проверить онлайн и найти дубли страниц на сайте, уже является автоматическим, с помощью программы Screaming frog. Загружаем адрес сайта, нажимаем «Старт», и программа начинает парсить весь сайт.

Затем переходим в раздел Page title, нажимаем сортировку, и вот опять видно, что тайтлы полностью идентичные, причем разные url, а тайтлы везде одинаковые.

Это очень грубая ошибка, ее нужно исправлять, то есть тайтл для каждой страницы должен быть уникальным.

Как найти дубли сайта онлайн с помощью Saitreport

Еще один способ, как найти дубли сайта — через сервис Saitreport. Я записывал обзор по этому сервису, посмотрите видео:

Вкратце скажу, что дубли страниц можно найти во вкладке «Контент», спускаемся вниз и здесь вот есть «Полные дубликаты», «Почти дубликаты» и «Очень похожие».

Нас интересуют вот эти полные совпадения и почти дубликаты, особенно полные совпадения, переходим сюда и видим, что достаточно много дублей.

По URL видно, что эта страницы фильтров, две полностью идентичные страницы. Самое главное, чтобы фильтр был закрыт от индексации, чтобы весь этот мусор не попал в индекс. Если это просто находится на сайте, но не в индексе, то ничего страшного нет, но если этот мусор попадет в индекс, то можно легко похерить сайт.

Проверка дублей страниц index.php и index.html

И последний способ найти дубли — проверить файлы index.php и index.html, которые могут отвечать за отображение главной страницы сайта. Часто бывает, что на сайтах эти файлы настроены неправильно.

Чтобы это проверить нужно к адресу главной страницы через слэш прописать index.php. Если все настроено правильно, то должен произойти 301 редирект (сайт перебросит с index.php на главную страницу) или должна открыться страница 404 ошибки.

Но если по адресу site. ru/index.php открывается опять главная страница, то это является дублем, то есть страница site.ru/index.php дублирует главную страницу.

ru/index.php открывается опять главная страница, то это является дублем, то есть страница site.ru/index.php дублирует главную страницу.

В этом случае нужно проверить внутренние страницы — также через слэш прописать index.php. Скорее всего опять откроются дубли внутренних страниц, иногда открывается опять главная, получаются многократные дубли через неправильную настройку этого файла.

Аналогично нужно проверить файл index.html. Как я сказал, должен произойти или 301 редирект (перебросить на главную страницу) или открыться страница 404 ошибки.

Как убрать дубли

Итак, что теперь делать с этими дублями, которые найдены? Вариантов много, и каждый вариант нужно выбирать в зависимости от ситуации, сайта, потому что один и тот же вариант может подойти одному сайту, но не подойдет другому.

Самое главное, нужно определить, насколько важны эти страницы для продвижения сайта. Есть ли на них трафик или может быть планируется, и дальше действовать в соответствии с этой важностью.

Если эта страницы не важны, то есть варианты:

- закрыть их от индексации;

- настроить на них canonical;

- совсем удалить их сайта.

Если же это страницы важные, то нужно их уникализировать:

- переписать метатеги;

- переписать заголовоки;

- переписать контент;

- сделать каждую страницу уникальный, чтобы она несла пользу посетителю и продвигалась в поиске.

Для закрепления материала, посмотрите более подробное и наглядное видео по поиску дублей:

Итак, я надеюсь, что статья была полезной для вас! Пишите ваши вопросы, комментарии, может что-то не понятно, просто пишите, если статья понравилась, я рад любой обратной связи. Поделитесь ею с друзьями в социальных сетях!

Сергей Моховиков

SEO специалист

Здравствуйте! Я специалист по продвижению сайтов в поисковых системах Яндекс и Google. Веду свой блог и канал на YouTube, где рассказываю самые эффективные технологии раскрутки сайтов, которые применяю сам в своей работе.

Веду свой блог и канал на YouTube, где рассказываю самые эффективные технологии раскрутки сайтов, которые применяю сам в своей работе.

Вы можете заказать у меня следующие услуги:

Загрузка…листалки, версии для печати и другое; Как защитить контент.

Многие перечисленные выше доработки направлены на то, чтобы на сайте не создавались лишние страницы, точные копии существующего контента. Опасность наличия таких страниц описана в третьей главе. Они могут повлечь за собой как некорректный выбор релевантной страницы, так и наложение санкций на сайт.

Существуют два вида дублей – полные и нечеткие.

Полные дубли – это страницы, содержание которых идентично друг другу, различны только их URL.

Нечеткие дубли – это страницы, которые содержат очень большое количество одинаковой информации, но они не полностью идентичны; их URL также различны.

Источники дублей в сети различны. В одних случаях дубли появляются из-за технических недоработок web-мастеров, в других – в результате осознанного влияния оптимизатора на ответ поисковой машины.

За технические ошибки и форматы документов отвечают непосредственно владелец и разработчик сайта. Дубли текста же могут появляться, в том числе, в результате кражи контента с сайта-первоисточника. Однако борьба оптимизаторов с «нахлебниками» не имеет отношения к технической оптимизации, поэтому далее речь пойдет о недоработках на сайте, автоматически генерирующих дублированные страницы.

Чаще всего проблема решается устранением всех дублей, адреса которых будут отдавать и посетителям, и поисковой системе 404 ошибку, при этом необходимо позаботиться об устранении еще и всех образовавшихся битых ссылок.

Большинство рекомендаций по работе с дублями можно свести к следующему:

1. Закрыть от индексации в файле robots.txt все имеющиеся на сайте дубли.

2. При формировании страниц, которые являются дублями, в их мета-теги прописывать <meta name=»robots» content=»noindex,nofollow»/>. Это запретит роботу индексировать данные страницы и переходить по ссылкам с этих страниц.

Это запретит роботу индексировать данные страницы и переходить по ссылкам с этих страниц.

Внутри сайта дубли страниц могут создаваться по разным причинам. Например, дубли могут возникнуть из-за повторения контента в анонсе и на самой странице новости. Другой случай – когда «версия для печати» полностью дублирует основную страницу и т.д.

3. Использовать тег <link rel=»canonical» href=»адрес оригинала» /> на всех автоматически генерируемых страницах.

Однако каждый частный случай появления дублей страниц на сайте нужно рассматривать отдельно и применять те меры, которое будут приемлемы для этого конкретного сайта. Ниже приведены самые распространенные причины автоматической генерации дублей страниц на сайте и варианты их устранения.

«Листалки»

Если на сайте присутствует многостраничный каталог, то очень часто вторая, третья и другие его страницы могут содержать много повторяющейся информации. Это могут быть одинаковые мета-теги или текстовые блоки, которые отображаются на всех страницах каталога из-за особенностей CMS сайта. Получается, что на множестве страниц присутствует один и тот же текст, что особенно плохо, если этот текст оптимизирован для продвижения – он просто «растворяется» в множестве дублей.

Получается, что на множестве страниц присутствует один и тот же текст, что особенно плохо, если этот текст оптимизирован для продвижения – он просто «растворяется» в множестве дублей.

Чтобы не допускать дублирования контента в «листалках», можно воспользоваться следующими методами:

1. Закрыть все дублирующиеся страницы через robots.txt, мета-тег “ROBOTS” или использовать тег «rel=”canonical”».

2. Сделать так, чтобы все значимые текстовые блоки отображались только на первой странице и не дублировались на остальных. Это целесообразно, если в продвижении находится только первая страница и на ней остается весь контент, релевантный запросу. Эти работы выполняют разработчики, а вы должны указать им необходимость их выполнения.

Помимо дублей контента на страницах «листалок» также очень часто встречается проблема одинаковых мета-тегов на всех страницах каталога. В этом нет большого вреда, но их уникализация может дать дополнительные бонусы при ранжировании ресурса. Наиболее удобный вариант работы с мета-тегами – создать единый шаблон title и мета-тегов в зависимости от содержания страницы.

Наиболее удобный вариант работы с мета-тегами – создать единый шаблон title и мета-тегов в зависимости от содержания страницы.

Нередко встречается, что «листалка» содержит развернутое описание товара, и точно такой же текст фигурирует на странице с карточкой товара. За счет этого происходит дублирование контента, что может негативно сказаться на ранжировании. У поискового робота возникает диссонанс: какую страницу считать более релевантной?

Чтобы предотвратить такое дублирование, можно:

1. Закрыть страницы «листалки» в robots.txt.

2. Публиковать в «листалках» только небольшую часть из описания товара или услуги со ссылкой на полную версию описания или на карточку товара.Сортировка, фильтрация и поиск

В случае если на сайте располагаются формы сортировки, фильтрации и поиска, то, как правило, результат формируется на отдельной странице с динамическим URL. Эта страница может содержать фрагменты текстов с других страниц сайта. Если не проводить работу с множественными страницами результатов сортировки (или поиска), то они будут открыты для индексации роботами поисковых систем.

В сортировке участвует несколько категорий, фильтрация идет в разных сочетаниях, поиск двух разных слов может привести к одному результату – все это порождает очень много автоматически сгенерированных страниц. А это нарушает лицензию поисковых систем, в частности, Яндекса.

Самый простой способ бороться с такими дублями — закрывать страницы результатов от индексации в robots.txt.

Например, строчка, закрывающая результаты поиска, может принять следующий вид: Disallow: /search=*

Рекомендуется периодически анализировать URL страниц сайта, попадающих в индекс, чтобы вовремя устранять проблемы с сортировкой, фильтрацией и поиском. В качестве алгоритма анализа можем предложить следующее решение:

1. Проанализировать параметры, найденные инструментом GoogleWebmaster и указанные в разделе «Конфигурация – Параметры URL».

Как часто проверять сайт на дубли страниц?

Это зависит от объема контента, периодичности обновлений, наличия поиска.

В среднем такую проверку рекомендуется устраивать раз в месяц.

В среднем такую проверку рекомендуется устраивать раз в месяц.2. Отобрать параметры, которые являются «незначащими», и задать в Google Webmaster команду «пропускать при индексации». Для настройки сайта под Яндекс следует указать данные параметры в robots.txt как маски для закрытия от индексации.

3. Проанализировать адреса страниц в индексе с помощью Яндекс.Вебмастер (раздел «Индексирование сайта -> Страницы в поиске»). Выявить одинаковые мета-теги (аналогичный инструмент есть и в Google Webmaster), одинаковые адреса с переставленными параметрами (например, первый «/?pr=gr&cost=big» и второй «/?cost=big&pr=gr»), количество страниц одной статьи за счет комментариев. Как только выявлены дубли, необходимо дать задание разработчику, чтобы он закрыл их от индексации.

4. Установить и устранить причину дублей, используя один из перечисленных ранее способов или их комбинацию. В идеале следует пересмотреть структуру сайта и алгоритм формирования URL.

Сортировка, фильтрация и поиск являются важными навигационными элементами сайта; без них нельзя обойтись, особенно на большом сайте, т.к. это серьезно влияет на юзабилити. Но при использовании данных элементов нужно предвидеть возможные проблемы дублирования, периодически проводить проверки и своевременно устранять выявленные недочеты.

Версия для печати

Страница «Версия для печати» имеет большое значение для удобства использования сайта, поэтому ссылки на такие страницы рекомендуется ставить на всех карточках товаров, на странице контактов и в других значимых разделах сайта. Однако страница с версией для печати отличается от основной страницы только отсутствием графической составляющей, т.е. весь контент, как правило, дублируется.

Фактически проблема нечетких дублей в данном случае решается аналогично проблеме полных дублей. Можно воспользоваться атрибутом rel=canonical, мета-тегом «robots» или прописать запрет на индексацию дубля в файле robots.txt. Однако в последнем случае ссылка с оригинала будет передавать вес на страницу печати, что приведет к потере веса продвигаемой страницей. Чтобы этого избежать, ссылку «версия для печати» на странице-оригинале необходимо дополнительно закрыть тегом nofollow. В этом случае робот не будет пытаться переходить по данной ссылке и ошибок сканирования не возникнет.

Чтобы этого избежать, ссылку «версия для печати» на странице-оригинале необходимо дополнительно закрыть тегом nofollow. В этом случае робот не будет пытаться переходить по данной ссылке и ошибок сканирования не возникнет.

Также можно создать версию страницы для печати через технологии JavaScript и CSS. Это позволит избежать проблемы с дублями и оптимизирует взаимодействие сайта со сканирующим роботом. Однако к этой работе потребуется привлечь веб-разработчика.

CMS и неосознанные дубли

Некоторые системы управления сайта (CMS) автоматически создают несколько дублей каждой страницы. Например, в WordPress дубли возникают из-за повторения контента в анонсах и на самих страницах. Другая популярная CMS – Joomla – также создает множество дублей из-за того, что одна и та же страница может быть получена множеством различных способов.

Самая распространенная ошибка – передача лишних параметров. Этим грешат более 90% движков. Например, исходная страница site.ru/index.php?id=602, и только она должна индексироваться. Из-за идентификатора сессий и особенностей формирования динамических страниц появляются дубли: site.ru/index.php? showid=602&fs=12&345?SessionID=98765432156789.

Из-за идентификатора сессий и особенностей формирования динамических страниц появляются дубли: site.ru/index.php? showid=602&fs=12&345?SessionID=98765432156789.

Другой случай – наличие главной страницы по разным адресам, например, http://site.ru/ и http://site.ru/index.php.

Часть дублей обычно закрывается от индексации средствами самой CMS, но оставшуюся часть придется дополнительно закрывать методами, описанными выше: настраивать robots.txt (директива сlean-param и/или запрет индексации дублей), работать с битыми ссылками, настраивать 301 редиректы.

Бывает, что проблемы с дублями начинаются при переносе сайта с одной CMS на другую. В этом случае старые параметры накладываются на страницы нового движка, что может вызвать образование большого количества дублей. Поэтому при переносе сайта первое время необходимо контролировать техническую сторону вопроса более тщательно.

Внутренние и внешние дубли

Дубли могут быть созданы не только автоматически, но и вручную вполне осознанно. Например, на сайте есть две страницы. Первая – главная, вторая — страница «О компании», которая совпадает с главной (в свое время некогда было написать текст на эту страницу).

Например, на сайте есть две страницы. Первая – главная, вторая — страница «О компании», которая совпадает с главной (в свое время некогда было написать текст на эту страницу).

Подобная ситуация может встретиться и с каталогом однотипной продукции. Самый верный способ — сделать все страницы на сайте уникальными, но если это невозможно, необходимо прибегнуть к ранее перечисленным советам.

За внутренние дубли санкции на сайт не накладываются, но могут возникнуть сложности в передаче веса. Если же у сайта есть внешние дубли (кто-то украл контент и разместил его на своем домене), то возможна пессимизация сайта со стороны поисковых систем.

К сожалению, бывают случаи, когда уникальную информацию с сайта растаскивают по сети, и сайт из-за этого не может занять высокие позиции.

Яндекс очень серьезно относится к использованию на сайте неуникальных текстов (раздел «Яндекс.Помощь», подраздел «Советы вебмастеру»):

«Мы стараемся не индексировать или не ранжировать высоко: сайты, копирующие или переписывающие информацию с других ресурсов и не создающие оригинального контента…».

Один из способов запретить копировать текст с вашего сайта – заменить тег body на страницах сайта на тег body onco py=«return false». Другой способ – использовать специальный java-скрипт, который запретит использование правой кнопки мыши на web-странице, затрудняя копирование текста и изображений. Однако через исходный код страницы произвести копирование текста будет возможно, но при этом сохранятся все ссылки.

Такая позиция оправдывается главным принципом поисковых систем – информация в выдаче должна быть релевантной, актуальной и качественной. Неуникальный контент нельзя назвать качественным, для поисковых систем это ведет к увеличению индексных баз и повышенной нагрузке на поисковые сервера.

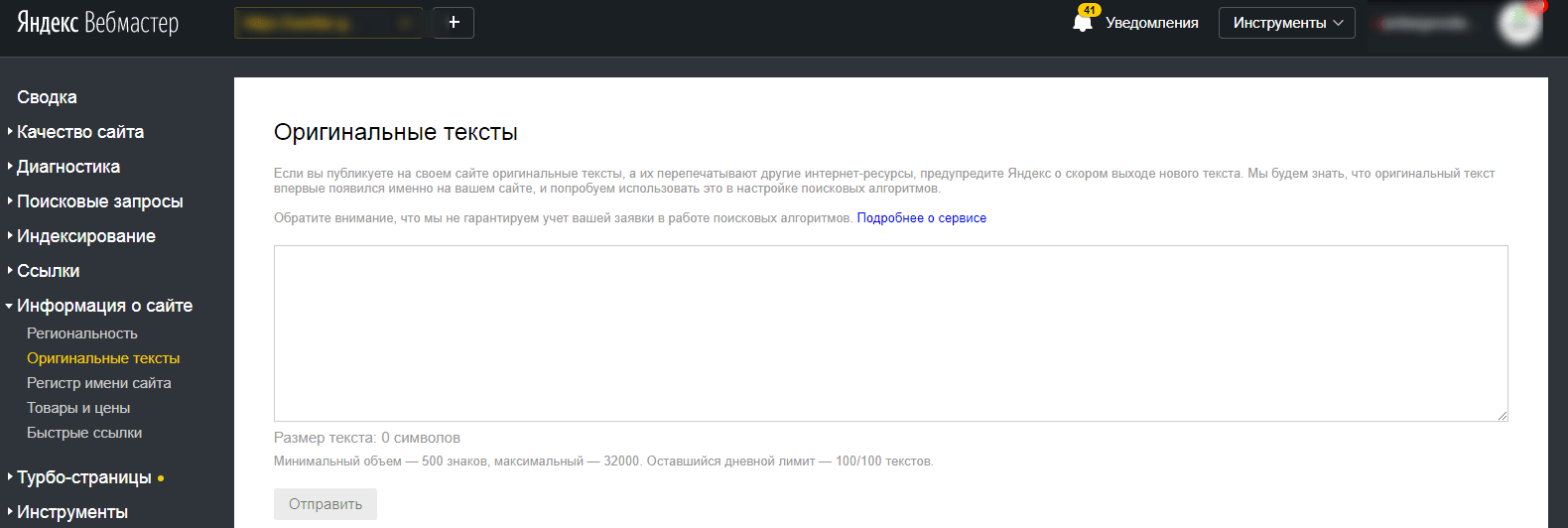

Как защитить контент

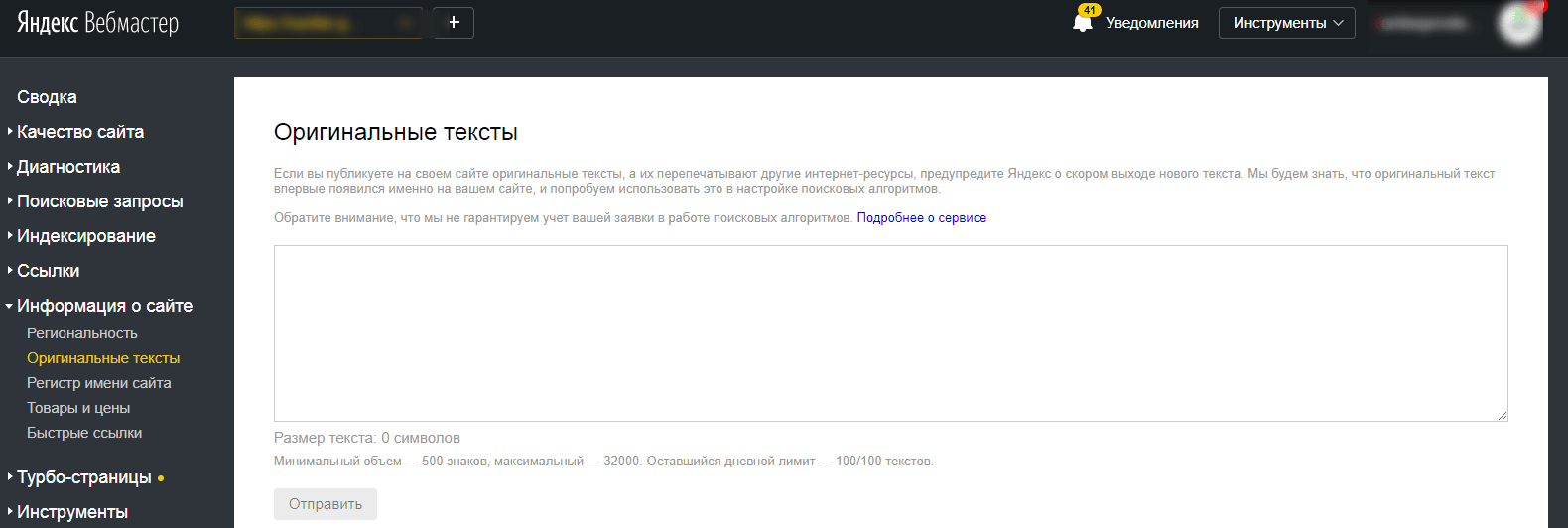

Поисковым системам сложно установить первоисточник, но соответствующие исследования ведутся. Например, Яндекс предложил веб-мастерам защитить контент с помощью сообщения о размещенном на сайте материале через сервис «Оригинальные тексты» в панели Яндекс. Вебмастер. Таким образом, при краже контента Яндекс будет знать, кто правонарушитель, и сайт не будет понижен в выдаче.

Вебмастер. Таким образом, при краже контента Яндекс будет знать, кто правонарушитель, и сайт не будет понижен в выдаче.

Есть еще один вариант появления дублированного контента на сайте – когда вы сами как владелец сайта позаимствовали его на других ресурсах. Такие действия уменьшают доверие поисковых систем к сайту и приводят к сложностям в продвижении. Среди сайтов, участвующих в отборе в ТОП-10, даже малейший недочет может сыграть не в пользу вашего сайта. Первая десятка должна быть разнообразной и отвечающей полностью на запрос пользователя, поэтому сайтов с двумя одинаковыми текстами в ней быть не может. Уникальность контента – это одно из главных требований, предъявляемых к сайту. Уважайте авторские права других людей!

Вернуться назад: Внутренние корректировки страниц сайтаЧитать далее: Оптимизация текста

поиск, причины появления и удаление

Краткое содержание статьи:

Техническая оптимизация сайта включает в себя множество

различных этапов. Особое место среди этих пунктов занимает отслеживание и

устранение дублей страниц. Они могут быть полными и неполными. Например, в

первом случае это зеркала главной страницы — site.ru и www.site.ru. Неполные

дубли проявляются, как одинаковые участки текстов на разных URL-адресах. Такие

копии важно найти и удалить.

Особое место среди этих пунктов занимает отслеживание и

устранение дублей страниц. Они могут быть полными и неполными. Например, в

первом случае это зеркала главной страницы — site.ru и www.site.ru. Неполные

дубли проявляются, как одинаковые участки текстов на разных URL-адресах. Такие

копии важно найти и удалить.

Опасность дублей на сайте

Поисковые системы негативно реагируют на совпадающий материал в пределах одного ресурса. Из-за их появления могут понизиться позиции сайта или появиться фильтры. Вот основные опасные моменты, которые возникают на портале, если поисковый робот обнаружит дубль страницы:

- Определение неверных релевантных URL-адресов в поисковой выдаче. Робот не может точно определить, какая страница является реальной, а где дубль. Из-за этого начинают скакать позиции, сайт опускается всё ниже.

- Неправильное

распределение ссылочного веса. Закупка внешних ссылок заканчивается тем,

что происходит путаница с URL-адресами.

Появляются рекомендации пользователей

интернета на дубли, а не на основной ресурс. Робот такое поведение расценивает

плохо, отправляет сайт под фильтр.

Появляются рекомендации пользователей

интернета на дубли, а не на основной ресурс. Робот такое поведение расценивает

плохо, отправляет сайт под фильтр. - Контент становится неуникальным. Копии текстов и картинок — это негативное влияние на ранжирование всего портала. Поэтому нельзя вставлять одинаковую информацию на разных URL-адресах. Продвигайте страницы сайта по разным ключевым запросам.

- Поисковики Google и Яндекс могут наложить санкции на портал. Манипуляции с дублями страниц воспринимаются роботами этих систем, как способ манипуляции для попадания в верхние строчки выдачи. Не хотите фильтров — боритесь с таким контентом!

К сожалению, многие владельцы сайтов не знают об опасности дублей страниц. В целях экономии они используют одинаковые тексты на страницах и потом удивляются, почему их ресурс занимает нижние строчки в поисковой выдаче.

Как появляются дубли страниц на сайте?

Перед тем, как заняться их поиском, нужно понять причину их

появления. Дубли страниц на сайте чаще всего возникают по следующим причинам:

Дубли страниц на сайте чаще всего возникают по следующим причинам:

- Применение системы управления контентом. Сбой возникает, когда запись на портале может относиться к различным рубрикам или разделам. При этом их домены включены в адрес сайта самой записи. Часто такое встречается на информационных ресурсах или в блогах. Поэтому важно контролировать работу CMS.

- Ошибки в технических разделах. Часто такое можно встретить в системах управлениях Bitrix и Joomla. Происходит это при нелогичной генерации одной из функций сайта — регистрации, фильтра или внутреннего поиска. В этом случае появляются дубли, но URL страницы не учитывается.

- Человеческий фактор. С любым сайтом работают люди, которые пишут тексты и проводят оптимизацию каждой страницы. Но даже специалист может ошибиться или где-то полениться. Часто такое происходит с текстами, когда нет времени писать разный контент.

- Технические

ошибки.

Если к несовершенной работе системы управления контентом добавить

человеческий фактор, то возникают странно прописанные адреса. Часто они

являются дублями каких-то страниц.

Если к несовершенной работе системы управления контентом добавить

человеческий фактор, то возникают странно прописанные адреса. Часто они

являются дублями каких-то страниц.

Невозможно избавиться от дубликатов на сайте, если не уметь их находить. Поэтому каждый владелец ресурса должен понимать, как это делается.

Поиск дублей

Копии на портале можно искать несколькими проверенными способами:

- использование программы XENU (Xenu Link Sleuth). Она поможет отыскать не только дубли, но и битые ссылки. Программу используют для поиска полных копий. XENU требует скачивания на свой компьютер, разработана только для операционной системы Windows. С установкой программы не должно возникнуть сложностей. Во время ввода страницы для проверки, обращайте внимание на наличие символом слеш «/» в конце.

- с помощью расширенного поиска Google. В строку поиска нужно вставить адрес главной или интересующей страницы. После этого система предложит полный список страниц, которые проиндексированы.

Проанализировав его, можно отыскать копии.

Проанализировав его, можно отыскать копии.

- с помощью web-мастерской Google. Владельцу сайта нужно будет пройти регистрацию. Увидеть копии страниц можно в разделе «Оптимизация Html». Ещё там будет представлен список одинаковых <Title>. Но неполные дубли этим методом не отыщешь.

- за счёт seo-платформа Serpstat. Для работы придётся пройти регистрацию.Выбираем раздел «Аудит сайта», потом «Суммарный отчёт». В течение определённого времени система покажет дублей Title, Description, h2. В бесплатной версии ресурса имеются ограничения, но информации достаточно для выявления копий.

Отыскав все дубли страницы, и проанализировав причины их появления, можно смело начать их удалять. Ни в коем случае не игнорируйте эти пункты, иначе копии снова начнут возникать на портале.

Простые способы удалить дубли страниц на сайте

Копии в Title,

Description и h2

исправляются в ручном режиме. А дубли страниц устраняем этими способами:

А дубли страниц устраняем этими способами:

- Через robots.txt — это самый лёгкий вариант. Необходимо только прописать нужные директивы.

- Воспользоваться 301 редиректом. С помощью этой директивы можно перенаправить роботов поисковых систем с дубля на оригинальную страницу. 301 редирект сообщает о том, что странички больше не существует.

- Link rel=»canonical» — вариант подходит для страниц с разными URL, но одинаковыми тестами. В код имеющегося дубля необходимо внедрить следующий тег — <link=»canonical» href=»http://site.ru/cat1/page.php»>. Он указывает на страницу, которая нуждается в индексации.

Попасть под фильтры Panda и АГС может любой сайт с дублями. Поэтому от копий нужно избавляться в первую очередь. В противном случае это отразиться на ранжировании. Вы потеряете позиции в поисковой выдаче, следовательно, и потенциальные клиенты или читатели не смогут находить ваш ресурс.

Если самостоятельно отыскать и удалить дубли страниц на

сайте не получается, то обратитесь за помощью к специалистам компании Grand-SEO.

Яндекс Вебмастер (Webmaster Yandex): от А до Я

В предыдущей статье про Вебмастер Гугл я рассказал, что Вебмастер — это Ваш способ заявить поисковой системе.

Яндекс выпустил сервис в 2007 году, официально открыв его для владельцев сайтов 21 декабря.

На сегодня он оброс дополнительными функциями, выдает огромное количество информации, необходимой для SEO оптимизатора, и фактически без него невозможно провести полноценный аудит сайта.

Анализ ошибок и отчетов Вебмастера Яндекс позволяет провести достаточно глубокий аудит любого вебсайта, выявить причины падения отдельных страниц в индексе и дать ответы на многие вопросы.

ОТОБРАЖЕНИЕ САЙТА В ЯНДЕКСЕ

Все мы знаем, что в контекстной рекламе мы можем решить, как будет выглядеть наше объявление.

Также мы можем в любой момент его отредактировать.

В естественной выдаче Вы тоже можете решить, что будет отображаться и как.

В выдаче в органике отображение Вашего сайта называется Сниппет.

По факту у Вас нет прямой возможности редактировать.

Но я расскажу, какие элементы можно изменять.

Отображение сайта в выдаче обычно можно схематически изобразить так:

Заголовок — изменяется непосредственно в HTML коде Вашей страницы.

Это тот самый Title, который Вы можете редактировать в админке своего сайта.

Есть определенные рекомендации по созданию кликабельных и привлекательных Title.

- Используйте ключевые слова страницы.

- Используйте большие буквы. Это упрощает восприятие. Но не КАПЛОК.

- Старайтесь изложить в Title, о чем эта страница в 60-65 символах.

Вы можете воспользоваться специальной утилитой КАЛЬКУЛЯТОРА ЗАГОЛОВКОВ, а также ознакомиться с техникой Эверест, как при помощи Title увеличить кликабельность своих страниц в органике.

КАЛЬКУЛЯТОР TITLEОписание. Ранее — это был тег Description, но после недавних изменений в технике формирования сниппетов, теперь в описании отображается наиболее релевантный поисковому запросу фрагмент контента страницы.

Текст может выбираться из фрагментов микроразметки Open Graph и Schema.org.

Это не значит, что тег дескрипшн заполнять не нужно.

Если Вы его не заполните, Яндекс понизит Ваши позиции (об этом ниже).

Если Вам нужно сделать так, чтобы не все подставлялось в сниппет, запретите индексирование отдельных фрагментов контента в коде при помощи тега noindex.

Если нужно закрыть от индексации ссылку, поставьте для нее тег Nofollow.

По микроразметке и сниппете рекомендую ознакомиться с официальным гайдом от Яндекс.

В поисковой выдаче фрагменты описания будут подсвечены жирным шрифтом по ключевым словам для удобства выбора нужной странички.

Быстрые ссылки. Отображается обычно для сайтов с высоким уровнем доверия, а также с хорошим трафиком.

Если сайт отображается с верхнем блоке ТОП5 выдачи, под Заголовком может отображаться блок быстрых ссылок.

Какие ссылки отображать и выводить, Вы можете изменить в вебмастере.

Но Вы не можете добавить их самостоятельно — Вам придется выбирать из предложенных.

Фавикон. Современные CMS предлагают добавить его без особых трудностей.

Это — та маленькая иконка, которая отображается сразу рядом с выдачей и в браузере в вкладке.

Помните, фавикон должен быть простым и понятным стилизованным логотипом Вашей компании — его должны узнавать пользователи.

Специальные данные. Яндекс также выводит помимо быстрых ссылок и сниппета, еще и другие.

Первый — хлебные крошки.

Если Ваша страница находится на втором и третьем уровне вложенности, Яндекс отобразит в сниппете символически путь к этой странице.

Это достигается за счет микроразметки BreadCrump.

Второй элемент — это физический адрес компании.

Достигается за счет прописывания микроразметки Company, где Вы прописываете реальный адрес, телефон, время работы компании.

И третий элемент — экспериментальный — если Вы используете чат Jivosite на своем сайте.

Да, Яндекс провел эксперимент с Jivosite и сайты с этим модулем получили возможность начать чат с клиентом без посещения самого сайта.

Некоторые элементы можно контролировать и изменять непосредственно из Вебмастера.

ГЛАВА 1:

Использование Яндекс Вебмастера

В этой главе мы расскажем, как добавить свой сайт в Вебмастер Яндекса и дать доступ своим сотрудникам.

Вебмастер от российского поисковика Яндекс отличается достаточно простым интерфейсом и понятен большинству владельцев сайтов и оптимизаторов.

Для начала работы рекомендуется добавить свой сайт (для входа воспользуйтесь своей учеткой в Яндексе), карту сайта и предоставить доступ своим коллегам и партнерам.

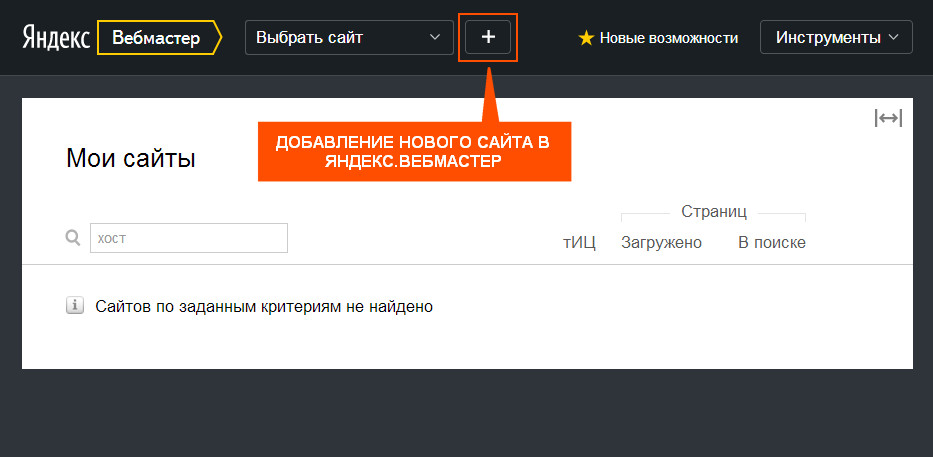

ДОБАВЛЕНИЕ САЙТА В ВЕБМАСТЕР ЯНДЕКС

Для добавления сайта перейдите по ссылке на Webmaster.Yandex.Ru, нажмите кнопку + и напишите URL Вашего сайта (полностью, с учетом http:// или https://).

ПЕРЕЙТИ в ЯНДЕКС ВЕБМАСТЕРЗатем система предложит Вам подтвердить право на владение своим сайтом.

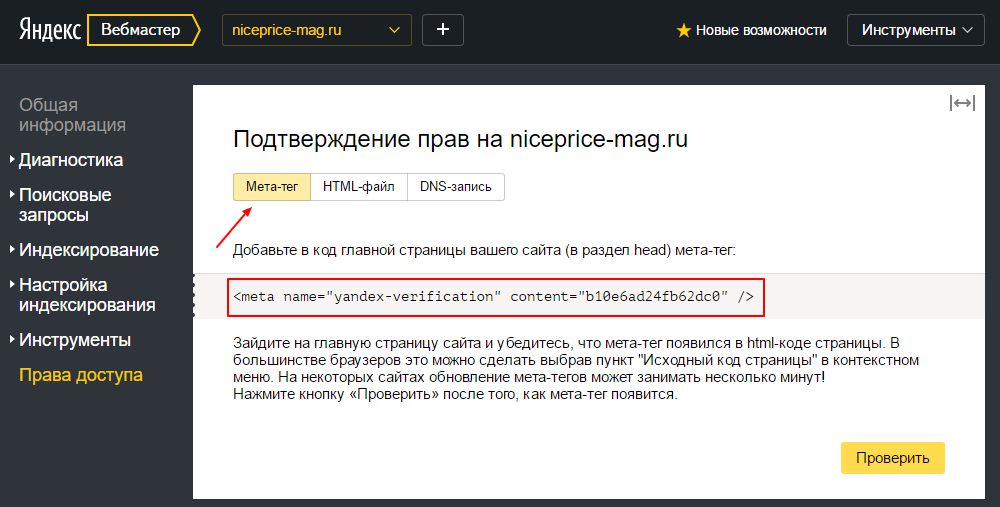

Через метатег.

Для этого скопируйте указанный код в окошке и отредактируйте шапку сайта, разместив его перед закрывающим тегом </head>.

Затем нажмите кнопку Проверить.

Через HTML файл.

Зайдите на Ваш FTP (или в диспетчер файлов на хостинге) и загрузите файл (клик на верхнюю ссылку с названием файла скачивает его на Ваш жесткий диск).

Проверьте, чтобы файл открывался (кликните после его установки на хостинге на нижнюю ссылку в окне вебмастера).

Затем нажмите кнопку Проверить для подтверждения владения сайтом.

Через DNS запись.

Просто зайдите в настройки DNS и добавьте запись типа TXT с указанным текстом.

Затем подождите несколько часов и подтвердите владение сайтом, нажав кнопку Проверить.

Убедитесь, что Вы выбрали правильную версию домена!

Например, если Вы выбрали домен с WWW., а подтверждаете владение сайтом без WWW, ничего не сработает.

КАК ДАТЬ ДОСТУП НА ЯНДЕКС.

ВЕБМАСТЕР

ВЕБМАСТЕРДоступ для Яндекс.Вебмастера обязательно должен быть у Вашего SEO-оптимизатора.

Для этого перейдите в раздел Права Доступа и в окошке Делегирование праввпишите Яндекс почту Вашего оптимизатора.

При этом в разделе Метод проверки будет показано, каким образом логин получил права на сайт.

ГЛАВА 2:

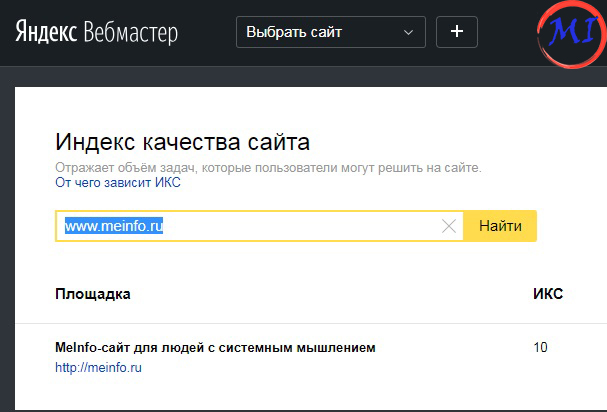

Индекс Качества Сайта

Что известно о новой пузомерке Яндекса?Как ее использовать для анализа сайта?

В чем отличие от почившего ТИЦ?

В этой главе мы все узнаем подробно.

Мы знаем, что Google отказался от своего фактора PageRank (или скрыл его метод расчета, и само значение скрыл).

Совсем недавно Яндекс внедрил новый показатель качества сайта — ИКС (или Индекс Качества Сайта).

Он пришел на смену устаревшему ТИЦ (который учитывал индекс цитирования ссылками сайтами из Яндекс.Каталога).

Так как Яндекс.Каталог уже ушел на покой, ТИЦ давно нужно было заменить.

Вебмастер Яндекс отображает ИКС вместо ТИЦ.

Вы можете провероить ИКС для любого сайта по ссылке.

Сейчас ИКС рассчитывается по следующим критериям:

- Размер аудитории сайта. Чем больше трафик Вашего сайта, тем выше потенциальный ИКС. Увеличить его можно за счет привлечения трафика на свой сайт за счет контекста, Email рассылок, рефералов и соцсетей, а также оффлайн-маркетинга.

- Уровень удовлетворенности пользователей на сайте. Улучшайте время пользователя на сайте, уменьшайте показатель отказов.

- Уровень доверия пользователей к сайту. Обычно наличие роста брендового трафика — хороший знак, что Вы становитесь более известны и поисковик начинает Вас лучше ранжировать

- Уровень доверия Яндекса к Вашему сайту. Да, у Яндекса есть свой чеклист, где он оценивает Ваш сайт по собственным параметрам. Об этом далее

- Другие критерии. Влияние асессоров (сотрудников Яндекс), скрытые алгоритмы поисковика.

Мы знаем, что ИКС для зеркал передается идентичный.

Если доменные имена совпадают, ИКС основого сайта совпадает с зеркалом.

Если Ваш сайт занимается публикацией материалов (статейник или блог), Вы можете разместить код Вашего ИКС на Вашем сайте — это будет красноречивый знак о качестве Вашего ресурса для Яндекса: ссылки с сайта с высоким ИКС ценятся гораздо выше.

ГЛАВА 3:

Возможности Вебмастера Яндекс

В этой главе мы рассмотрим, как можно использовать Яндекс Вебмастер новичку, и на какие разделы обратить внимание в первую очередь.Эти данные удивят своей полезностью даже опытных специалистов.

Теперь перейдем непосредственно к функционалу, как ним пользоваться.

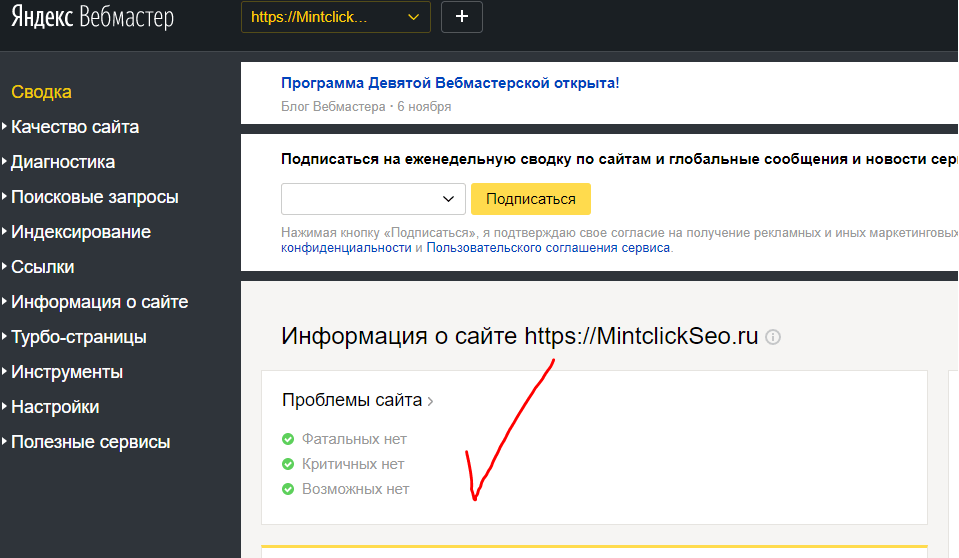

Раздел СВОДКА встречает Вас готовым набором виджетов и отображает ключевые новости (изменения) для Вашего сайта.

В Виджетах при помощи списков и инфографики отображаются последние изменения на сайте — проблемы, клики, обход поискового робота, новые ссылки на Вас и изменение индекса ИКС.

Из главного экрана перейти на более глубокие отчеты.

Диагностика сайта

Проверка сайта на ошибки, безопасность и нарушения (диагностика).

Ошибки делятся на несколько типов: фатальные, критичные, возможные проблемы и рекомендации.

Отчеты по ошибкам достаточно подробные и позволяют оперативно на них реагировать на нарушения.

Ошибки делятся на Фатальные, Критичные, Возможные и Рекомендации.

Фатальные ошибки Вашего сайта

Фатальные ошибки, которые Вы можете допустить:

- Сайт закрыт от индексации в файле robots.txt. Проверить его можно при помощи специальной утилиты в вебмастере (о ней — ниже).

- Есть ошибки DNS (вашего хостинга). Если Вы видите эту ошибку, сайт может выпасть из индекса на долгое время.

- Не загружается главная страница. Из-за различных сбоев хостинга или работы сайта, если поисковик не может получить документ главной страницы, то Вы можете потерять сайт из выдачи.

- На сайте обнаружены проблемы с безопасностью. Есть огромное количество ошибок и нарушений, которые может применить к Вам Яндекс.

Нарушения безопасности — очень опасные нарушения, и могут повлечь к необратимым последствиям для Вашего сайта

После восстановления сайта от нарушения может пройти от двух до четырех недель на анализ выдачи — после обхода поискового робота пересматривается текущий показатель качества сайта и отдельных страниц.

Я кратко расскажу, что может быть применено к сайту за каждое нарушение.

Общие нарушения

- Дорвей. Если Вы создали сайт, который переводит пользователей на другой сайт, то использование дорвеев — это методика черного SEO и Яндекс за это наказывает понижений позиций или удалением из индекса.

- Клоакинг. Вид нарушения, когда Вы показываете поисковику один контент, а пользователю — другой (например, перенаправляете пользователей на закрытые от индексации страницы, а в индексе находятся безвредные версии). Этим промышляют сайты по продаже порнографического и запрещенного законодательством контента и товаров.

- Партнерские программы. Если Вы предлагаете услуги и продукцию из других сайтов, при этом сам сайт не имеет никакого полезного уникального контента. Например, в Казахстане модно создавать парсинг-клоны сайтов магазина IKEA (оригинальная компания IKEA там не работает, а товар востребован), где все страницы парсятся на основе оригинального сайта.

Ссылочные нарушения

- Покупка ссылок для продвижения.

Да, если Вас Яндекс заподозрит в закупке ссылок на сторонних ресурсах, Вы приедете в Минусинск (не город). От такого фильтра избавиться очень трудно — так как Вам придется снимать ссылки вручную (обращаясь к владельцам сайтов и хостинг-провайдерам с просьбой снять ссылки). Кстати это — слабое место, ведь недобросовестные конкуренты могут накупить на Вас ссылок с мусорных ресурсов, а Вы не можете никак от этого защититься. По факту алгоритм должен блокировать некачественные ссылки, но пока это лишь в теории.

Да, если Вас Яндекс заподозрит в закупке ссылок на сторонних ресурсах, Вы приедете в Минусинск (не город). От такого фильтра избавиться очень трудно — так как Вам придется снимать ссылки вручную (обращаясь к владельцам сайтов и хостинг-провайдерам с просьбой снять ссылки). Кстати это — слабое место, ведь недобросовестные конкуренты могут накупить на Вас ссылок с мусорных ресурсов, а Вы не можете никак от этого защититься. По факту алгоритм должен блокировать некачественные ссылки, но пока это лишь в теории. - Размещение (продажа) SEO ссылок. Да, подобный процесс касается и сайтов, которые размещают SEO ссылки. Исходящие ссылки должны быть тематическими, неспамными и вести на целевой контент.

Текстовые нарушения

- SEO тексты. Да, создание текстов, которые влияют на выдачу поисковой системы, является нарушением и к Вам может быть применен фильтр. Один из них — Баден-Баден, второй — более грубый — Переоптимизация.

- Сайты с бесполезным (малополезным) контентом, с нарушениями правил рекламы и распространением спама.

- Спам поисковых запросов. Создание множества страниц, заточенных под разные повторяющиеся поисковые запросы, и перенасыщенные контентом с поисковыми запросами. Обычно Вы можете подумать, что это может коснуться тегов, разделов каталога и фильтров, но это не так: фильтр направлен на запросный спам в текстовых блоках в подвале страниц, созданных для вывода посадочной страницы под поисковые ключи.

- Скрытый текст. Использование текста, который написан нулевым шрифтом или скрыт под изображением или в скрываемом блоке, напичканный ключевыми словами, который поисковик ошибочно считает полезным. В случае нарушения выдача будет понижена.

Мошенничество и взлом

- Накрутка ПФ (поведенческого фактора). Как известно, показатель отказов — фактор ранжирования, и иногда хочется его улучшить… любой ценой. Я бы не советовал — за это нарушение Ваш сайт может надолго вылететь из поиска.

- Предложение по накрутке ПФ (мотивация пользователей накручивать Вам поведенческие факторы) наказывается тем же.

- Подключение платных услуг подписки для мобильных пользователей. Да, Яндекс, если заподозрит Вас в этом, резко даст о себе знать.,

- На сайте обнаружены нежелательные программы или файлы (кряки, зараженные файлы, украденный контент). Наличие подобных элементов может послужить сигналом для удаления страниц из индекса.

- Опасные сайты. Если Ваш сайт подвергся заражению, он будет помечен как небезопасный.

- Фишинг. В отличие от партнерок, некоторые сайты могут быть похожи на популярные порталы — практически точными копиями. Такие сайты создаются для воровства личных данных (логины, пароли, учетные данные) пользователей

- Кликджекинг — аналогично фишингу, сайты, которые позволяют украсть личные данные пользователя, не ставя его в известность

Что делать, если Яндекс ошибся?

Методы Яндекса очень точные, и он редко ошибается.

Шанс ошибки по статистике около 1%.

Но вдруг Вам повезло войти в этот процент, Вы получили подобное письмо счастья, и Ваш сайт понизился в выдаче, или совсем вылетел из нее?

Тогда перейдите по ссылке, выберите и заполните форму.

Опишите тщательно ситуацию.

И терпеливо ждите ответа.

Критичные ошибки

Есть две критичные ошибки, которые не являются фатальными, но могут сказаться на Вашем ИКС. Мы рекомендуем их исправить как можно быстрее.

- Битые ссылки. Если на сайте много внутренних ссылок, которые не работают (отдают ошибку), это усложняет навигацию. Поисковый робот выдаст страницы с ошибками и порекомендует их исправить

- Долгий ответ сервера. Если Ваш хостинг отвечает больше 3 секунд, Ваш сайт получит понижение позиций. Если Вы увидели такую ошибку, свяжитесь с Вашим провайдером услуг хостинга (выберите VPS или подключите более мощный тариф или смените его).

Возможные ошибки

Список ошибок из этой категории может повлиять на качество, релевантность и скорость индексации Ваших страниц.

- Ошибки файла Robots.txt (нет файла, или в файле обнаружены ошибки)

- Ошибки файла Sitemap.xml (нет файла, файл давно не обновлялся, не прописан в Robots или в индекс загружены ненужные страницы или в файле есть ошибки)

- Ошибки в уникальных страницах (есть дубли контента)

- Ошибки редиректов главной страницы (неверно настроен 301 редирект)

- Ошибка кода 404 Not Found (ответа на запрос на несуществующие страницы)

- Ошибки качества рекламы на сайте согласно IAB Russia.

- Ошибки в мета данных (отсутствуют теги Title и Description на страницах в индексе).

Все ошибки вполне исправимы — просто приведите в порядок файл sitemap, robots и пропишите грамотно заголовки и описания для индексируемых страниц.

Рекомендации Яндекс

Финальный список чеклиста оптимизатора уже скорее влияет на отображение и правильность индексации Вашего сайта.

Старайтесь и тут не наломать дров и не забыть про каждый пункт.

- Настройка региона для выдачи. Укажите город и страну для гео принадлежности Вашего сайта. Сайты с городами — поддоменами — для каждого поддомена для каждого города пропишите в вебмастере уникальный город (предварительно добавьте каждый в вебмастер).

- Сайт не найден в Яндекс Справочнике (или Яндекс Картах).

- Нет фавикона.

- Сайт не оптимизирован для мобильных. Сейчас — это важный фактор ранжирования в связи с ростом мобильного трафика. Если Вы увидели эту ошибку, передайте этот список Вашему программисту.

- Ошибка Яндекс Метрики. Сам счетчик должен обязательно быть установлен корректно для всех индексируемых страниц сайта.

- Неверная разметка для видео-контента. Используйте корректно разметку для видео на своем сайте. Полную инструкцию для программиста можно прочесть тут.

Держите этот чеклист перед глазами — и при помощи вебмастера Яндекс Вы всегда сделаете технический аудит без всяких трудностей!

ГЛАВА 4:

Раздел индексирования

Часто бывает ситуация, когда Ваш многостраничный сайт попадает в индекс с ошибками, или не полностью?В этом разделе Вы сможете контролировать индексацию сайта в Яндексе и ключевые слова, по которым Вы получаете показы и трафик.

В данном разделе находится инструментарий, отвечающий за статус нахождения страниц сайта в индексе Яндекса.

Индексация — автоматический процесс, и происходит за счет поискового робота, который руководствуется настроенной картой сайта и файлом robots, а также тегами разметки на Ваших страницах (index, follow и микроразметки).

Но также в вебмастере и ручные методы запуска механизма индексации — например в случае сбоя робота, Вы можете его перенаправить вручную.

Изучим все инструменты подробно.

Статистика запросов

Простой и понятный способ посмотреть, какие поисковые запросы работают на Вашем сайте: какую позицию они занимают, как часто Ваш сайт отображается в поиске.

Оценивайте как для каждого запроса, так и для всего сайта в целом Позицию, Клики, средний CTR.

В разделе ВСЕ ЗАПРОСЫ и ГРУППЫ Вы можете собрать запросы в группы (Избранные или создать собственные), пользоваться простыми фильтрами для отображения данных.

На основе этих данных стройте стратегию продвижения

- Улучшайте контент на страниц, где есть смысл усилить позиции.

- Работайте над сниппетами (Title и Description) для запросов, где у Вас высокая позиция, но низкий CTR.

- Создавайте новый контент для тех запросов, где у Вас нет позиций и у Вас нет целевых страниц.

Статистика обхода

Данный раздел сайта помогает узнать, как поисковый робот Яндекс индексирует и обходит Ваши страницы.

Можно выявить, какие страницы робот обошел, а с какими возникли трудности из-за ошибок индексации.

Страницы в поиске

Отображает статистику индексации Вашего сайта — в динамике.

Сколько страниц было добавлено и удалено из индекса.

И по какой причине.

Например, недостаточно качественные страницы, выпавшие из индекса, отображаются в этом отчете.

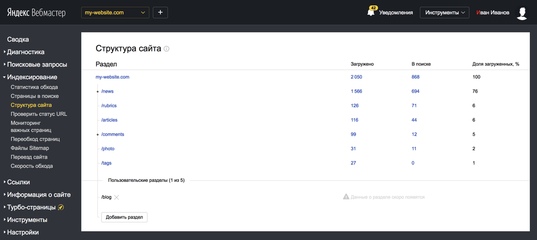

Структура сайта

Данный раздел позволяет отследить иерархию по уровням загруженных страниц и процент индексации каждого подраздела.

Именно по этому отчету Яндекс может выделить наиболее важные разделы Вашего сайта для отображения сниппета “Быстрые ссылки”.

Утилита для переезда сайта (индексирование).

Позволяет безболезненно переехать с одного домена на другой без потери позиций.

Важные страницы и переобход страниц (индексирование) позволяет отслеживать до 100 важных страниц и провести приоритетный обход роботом Яндекса до 20 новых страниц.

Проверить статус URL

Позволяет оперативно проверить наличие ссылки в поисковой базе Яндекс (и код отклика – 200, 301, 403 или 404).

Отслеживайте Важные страницы

Любой SEO оптимизатор должен знать, как его страницы индексируются в поиске.

Для удобства отслеживания страниц создали специальный инструмент.

Просто добавляйте списком отслеживаемые страницы и проследите за их ответом.

Если Вы не можете определиться, Яндекс Вебмастер предлагает на выбор Вам наиболее рекомендованные страницы — которые лучше всего индексируются и привлекают трафик.

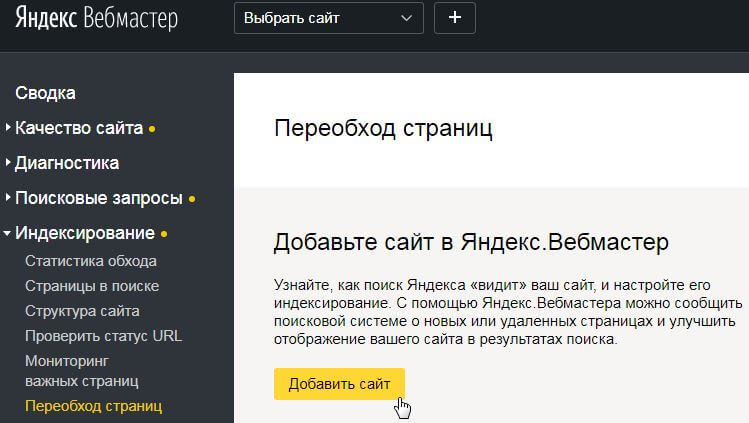

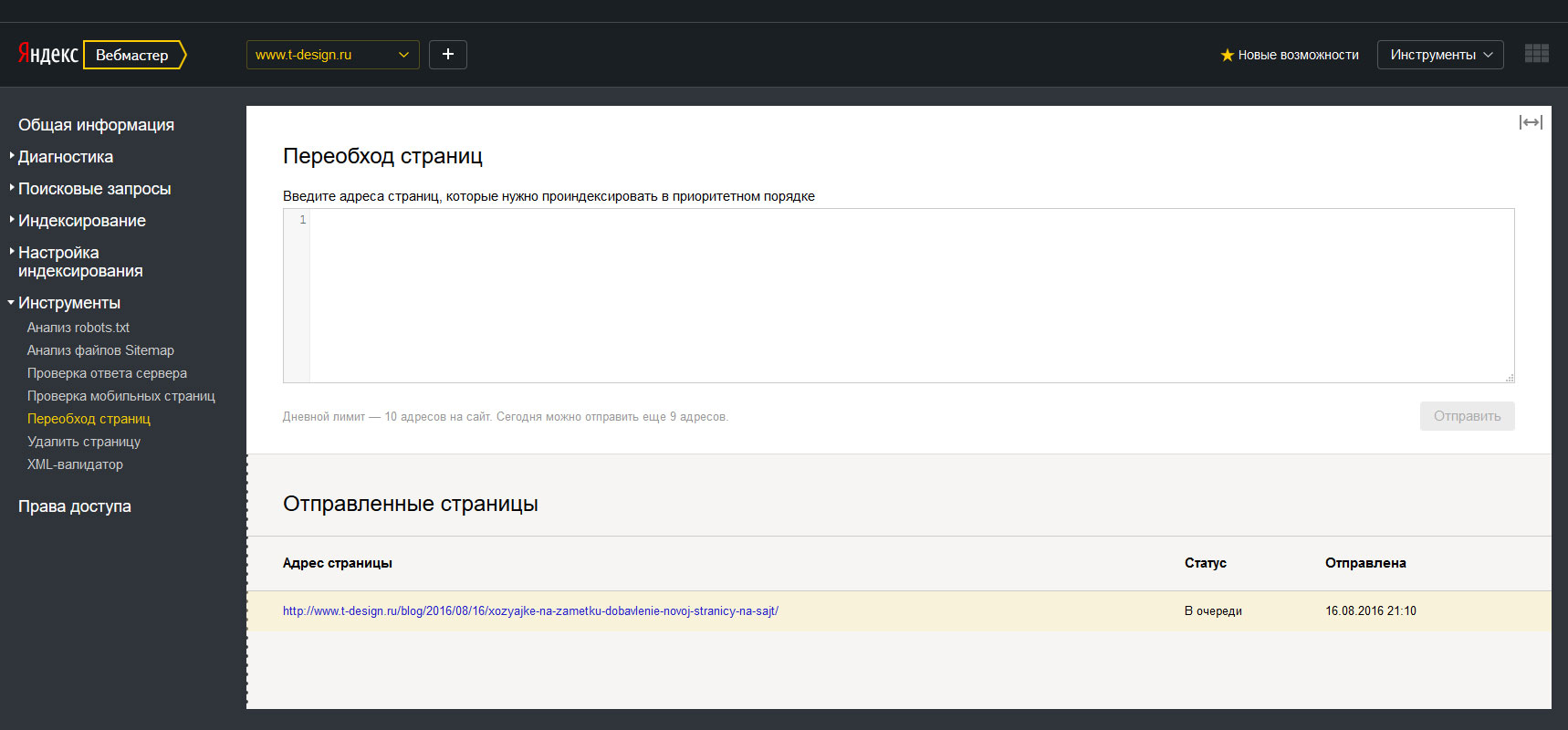

Переобход страниц

Отдельный инструмент, который позволяет проверить обход страниц поисковым роботом.

Да, если вдруг у Вас медленно проводится индексация, но нужно все же ускорить добавление в индекс новых страниц, есть ручной метод для этих целей.

В день можно попросить обойти робота в ручном приоритетном порядке.

Зачем это нужно?

Например, если Ваша страница была недоступна (отдала ответ 404 сервера), она может быть исключена из индекса.

Для повторной индексации потребуется повторно роботу обойти эту страницу, а робот Яндекса очень медлителен.

Поэтому в таком случае запускайте обход отдельных страниц вручную.

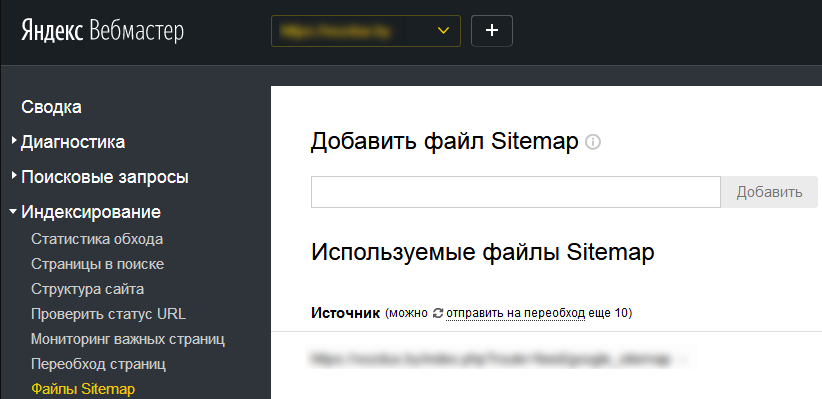

Файлы Sitemap.xml

Карта сайта — это файл, содержащий список страниц для индексации.

Это не вебстраница на сайте, на которой Вы сделали ссылки!

Это отдельный файл, который находится на Вашем FTP сайта и отвечает за время обновления каждой страницы, которую Вы хотите передать списком для поисковика.

Если у Вас нет карты сайта, создайте ее.

Для добавления карты сайта в Яндекс перейдите по ссылке.

Введите ссылку на файл карты сайта и нажмите кнопку Добавить.

Также Яндекс.Вебмастер по умолчанию может подтянуть карту сайта непосредственно из файла robots.txt.

Инструмент позволяет отследить все ошибки непосредственно в картах сайта и показывает объем ссылок, которые передаются в Яндекс для индексации.

Просто кликните на Ошибки и изучите полученный отчет со списком ссылок.

Внесите правки в файлы sitemap и попробуйте снова.

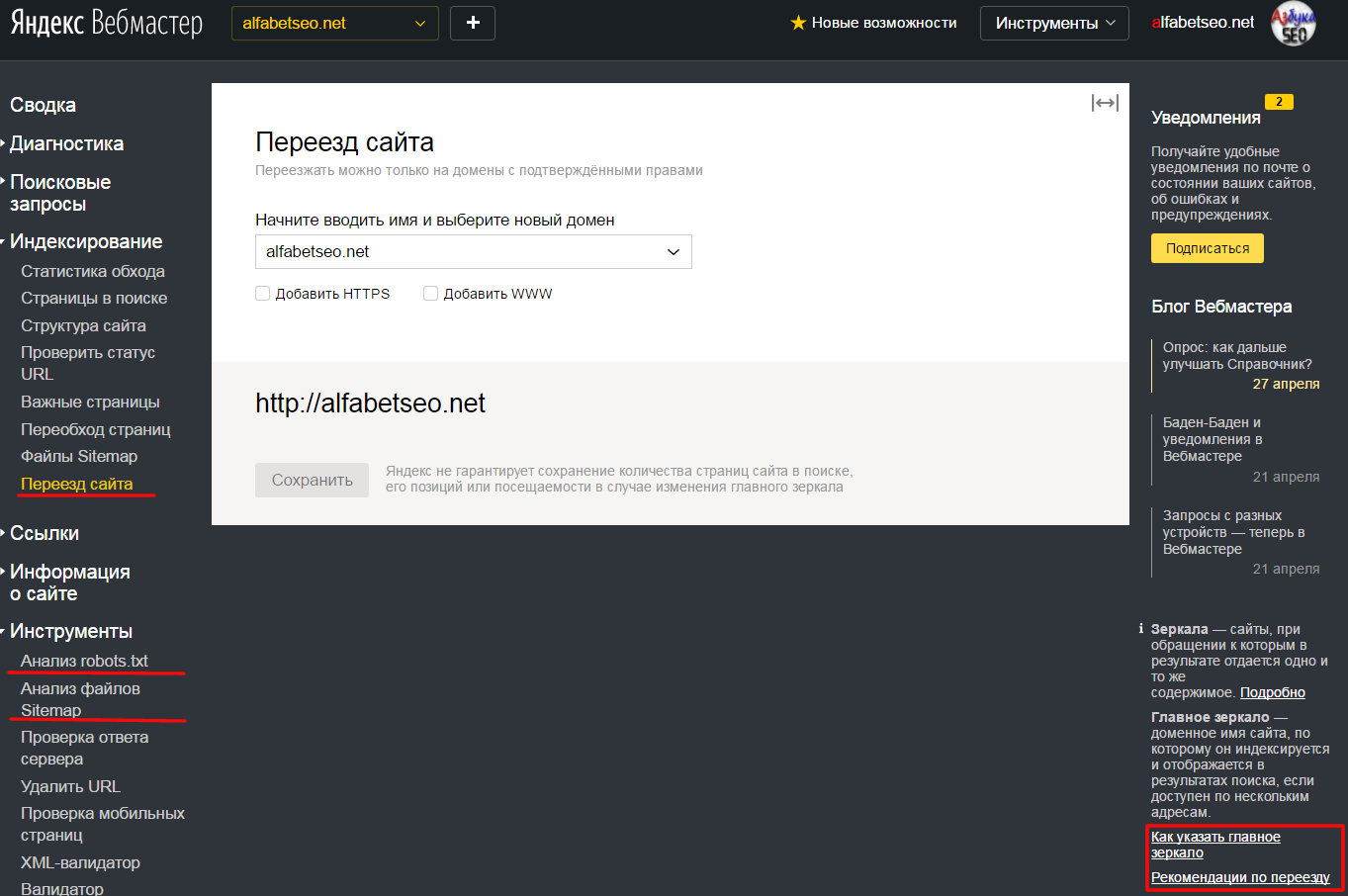

Переезд Сайта

Иногда приходится переезжать со старого домена на новый.

Например, если Вы съезжаете с WWW. домена на обычный.

Или установили HTTPS сертификат.

Для вебмастера это — разные сайты.

И нужно об этом сообщить.

Или например — переехали вообще с старого домена на новый.

Для удобства, в Яндекс Вебмастере есть соответствующий раздел.

Выберите новый домен из списка с подтвержденными правами.

При помощи галочек Вы можете добавить к домену HTTPS и WWW (по мере необходимости).

Затем нужно нажать Сохранить и дождаться изменения в индексации.

Если все сделали правильно, Яндекс произведет переезд сайта без ухудшения его позиций.

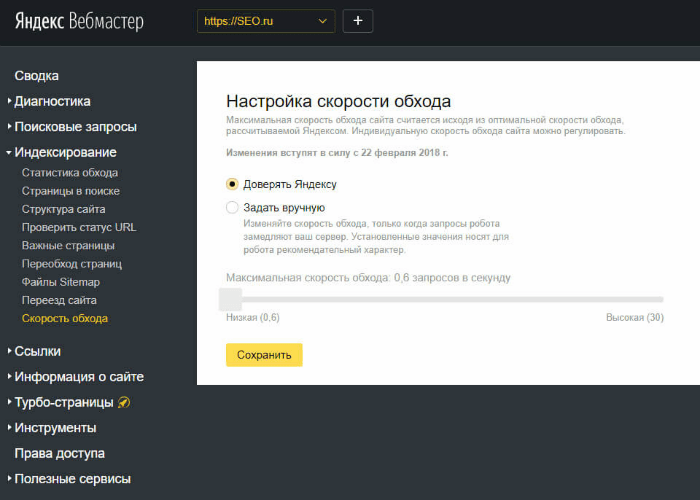

Скорость обхода

Если Вы считаете, что робот Яндекса замедляет Ваш сайт или же индексация сайта проходит достаточно медленно, Вы можете внести корректировки на скорость обхода Вашего сайта.

Мы рекомендуем этот раздел менять только в крайнем случае и выставить по умолчанию пункт “Доверять Яндексу”.

Средняя скорость обхода равна 3 запросам в одну секунду на Ваш сайт.

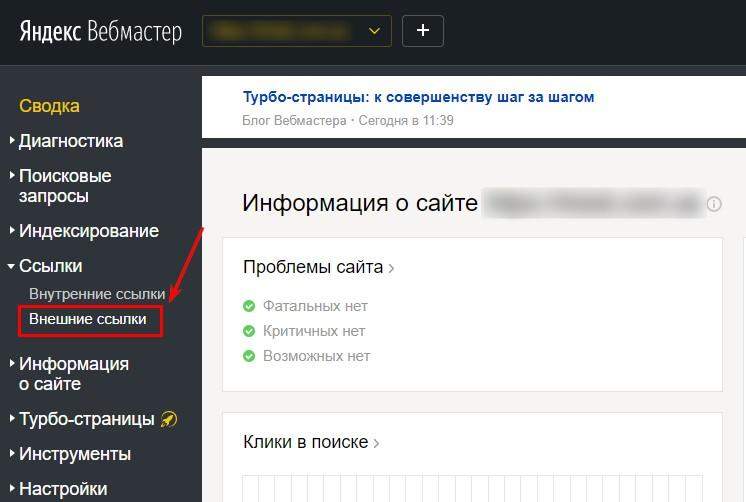

ГЛАВА 5:

Раздел ссылочного анализа

Самый недооцененный раздел Яндекс Вебмастера.Но при помощи него можно решить множество задач — как сделать перелинковку, так и изучить внешний ссылочный профиль сайта.

Раздел ссылочного анализа

Ссылочный анализ для Вебмастера является не менее важным, чем раздел индексации.

Ссылки Вашего сайта являются важным фактором ранжирования.

На Вашем сайте по факту должны быть все исходящие рабочие ссылки (как на внешние источники, так и внутренние), так и у Вас должен быть хороший ссылочный профиль.

Анализ внутренних ссылок в Вебмастере

Раздел внутренних ссылок выдает список внутренних неработающих URL на Вашем сайте.

Проанализируйте Вашу карту сайта и внутренние ссылки на Вашем сайте и удалите битые нерабочие URLы.

Внешние ссылки

Как мы изучили, внешние ссылки — это важный инструмент вебмастера.

Если Вы хотите видеть, какие ссылки на Вас ставятся и с каким ИКС (индексом качества) — Вы можете изучить непосредственно в этом разделе.

Помните, что за покупку SEO ссылок на бирже Вы рискуете получить фильтр Минусинск и потерять значительно в выдаче.

Поэтому мы рекомендуем изучать Ваш ссылочный профиль и вовремя реагировать на некачественное проведение.

Помните, хорошие ссылки следует создавать только белыми методами.

Мы их расписывали в этой статье.

Также можете изучить в нашем материале, чем отличаются черные и белые методы продвижения.

Если вдруг Вы заподозрили, что Ваша SEO компания размещает на Вас некачественные ссылки, или же в этом деле были замечены Ваши конкуренты, мы рекомендуем изучить отчет по внешним ссылкам и вовремя известить SEO отдел.

Мы можем помочь проанализировать качество ссылочного профиля Вашего сайта.

Для этого заполните форму и мы свяжемся с Вами в течение дня.

ГЛАВА 6:

Изменение информации о сайте

В этом разделе мы рассмотрим, как можно изменить региональность Вашего сайта, а также сообщить об оригинальном контенте для защиты от кражи.

Предыдущие разделы отвечали за индексацию сайта и ссылки.

Это действительно важные факторы ранжирования.

Но следует знать, что важно не просто быть в индексе.

Важно быть в индексе по правильным ключевым словам.

В этом нам поможет раздел Информации о Сайте.

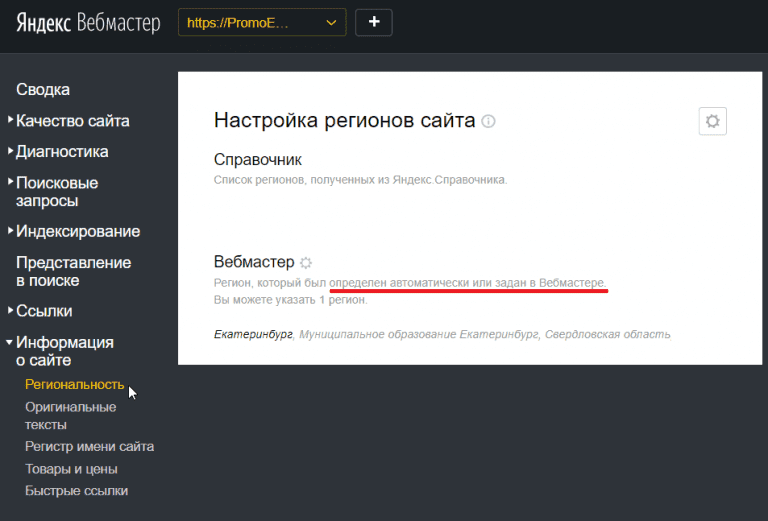

Региональность

Очень лаконичный и простой раздел.

По факту регион присваивается сайту при помощи двух инструментов — справочника и собственно — вебмастера.

В справочнике можно выбрать таргетинг вручную.

Здесь Вы можете настроить для своего сайта регион согласно Яндекс Карт.

При клике на раздел ИЗМЕНИТЬ РЕГИОНЫ Вас переадресует на Яндекс.Справочник, где будет предложено отредактировать Ваши данные на Яндекс.Картах.

Вы можете присвоить нужный город, адрес и телефон Вашей компании, а также категорию бизнеса.

Для верификации следует подождать некоторое время — в случае подтверждения Вы получите соответствующее уведомление.

В Яндекс.Вебмастере Вы можете прописать вручную регион, но для верификации потребуется указать страницу, где указаны Ваши адресные данные.

Защита от копирования оригинальных текстов

Часто бывает ситуация, когда Вы пишете тексты, но их успевают у Вас украсть?

Или же нужно успеть написать свой контент первым?

А Вы можете опубликовать контент, но в индекс попадаете медленнее конкурентов?

Раздел “Оригинальные тексты” позволяет добавить тексты до их предварительной заливки на сайт во избежание воровства (перепечатывания) Вашего уникального контента.

В день можно заливать не более 100 текстов объемом от 500 до 32 тыс. символов.

Очередность добавления контента отображается ниже.

Регистр имени сайта

Иногда хочется выделить составное имя в своем названии.

Например, если оно состоит из двух слов.

И нужно, чтобы в выдаче каждый слог был выделен разным регистром?

Перейдите в раздел Регистр Имени Сайта и пропишите его так, как Вам нужно.

И желательно опишите причину.

Это не влияет на SEO и результаты выдачи, но влияет на отображение Вашего сайта в результатах.

Есть определенные ограничения: нельзя делать 5 заглавных букв подряд, заглавные буквы аббревиатур должны подтверждаться контентом сайта, слитные слова.

Слова, разделенные дефисом, не подвергаются изменению.

В нижнем регистре всегда прописываются домены первого уровня (com.ua, org, ru) и префиксы (www., ftp.).

Товары и цены

Вы знаете, что у Яндекса есть свой инструмент для привлечения трафика для интернет-магазина — Яндекс.Маркет.

Но Вы можете улучшить свое отображение сниппетов в выдаче.

Первоначально подключите свой магазин к Яндекс.Маркету.

Ознакомьтесь с лицензионным соглашением и создайте Файл YML со списком Ваших товаров.

Он Вам дальше пригодится.

После добавления магазина в Яндекс.Маркет в вебмастере Вы сможете прописать все необходимые данные и отредактировать сниппеты.

Раздел “Товары и цены” позволяет подключить к Вашему сайту Яндекс.Маркет.

Создайте YML файл со списком выгружаемых товаров и зарегистрируйтесь в Яндекс.Маркет и отслеживайте работу Вашего магазина.

Быстрые ссылки

Мы уже рассказали, что в сниппете мы не можем повлиять на быстрые ссылки.

Но в Вебмастере есть инструмент, который позволяет выбрать из подходящих быстрых ссылок нужные.

Вы можете отключить ненужные (1) быстрые ссылки, а также отсортировать весь список по весу.

Вес ссылок распределяется благодаря внутренней перелинковке.

Распределяйте правильно вес внутренних ссылок по сайту, чтобы важные ссылки получали больше разделов.

Это обычно достигается за счет хлебных крошек, организованного каталога и удобной навигации в статьях и товарных страницах.

Если Вы выбрали нужные быстрые ссылки, Вы можете изучить, как будет выглядеть Ваш сниппет.

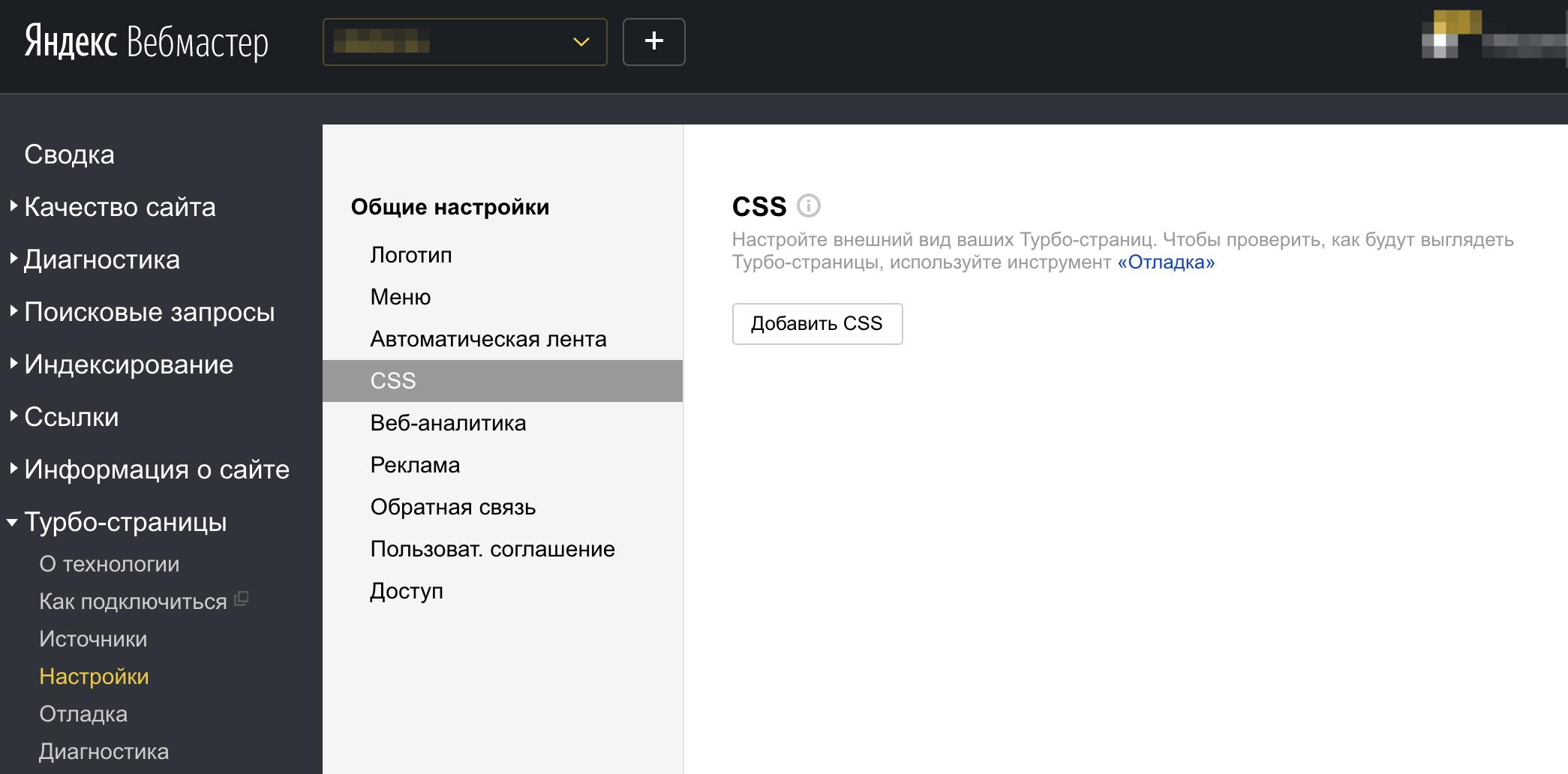

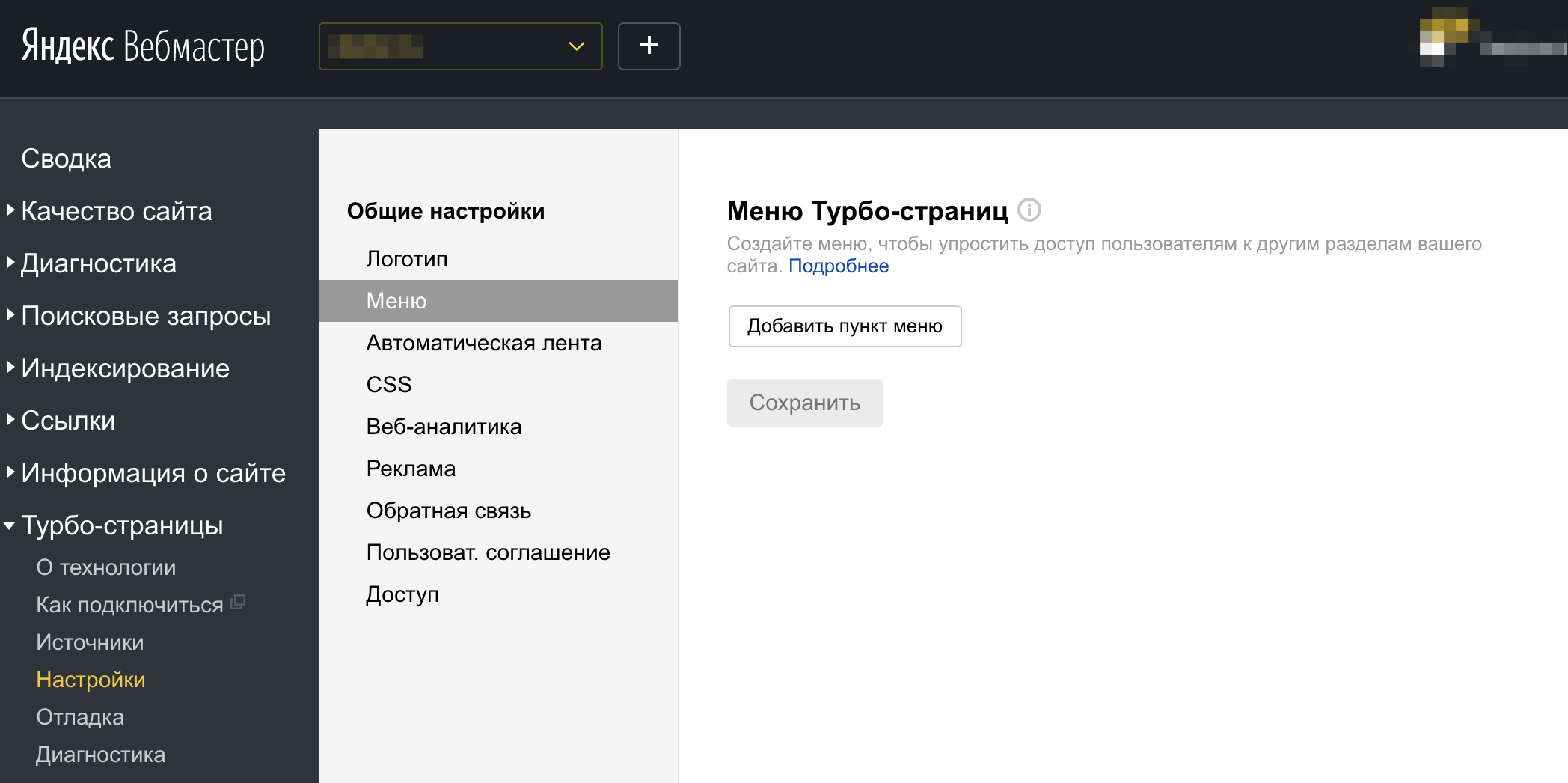

Турбо-страницы

Мобильные технологии шагают вперед достаточно быстро.

Одна из особенность мобильных устройств — это малые размеры, а вторая — небольшие потребности в трафике.

Так, веб-страницы для мобильных устройств должны загружаться быстро.

Причем — очень быстро.

Одна из новых технологий Яндекса — поддержка Турбо-страниц.

Все настройки турбо страниц Вы производите непосредственно в Яндекс Вебмастере — просто настройте свой RSS канал (или загружайте контент через API).

Проверка обычно занимает около двух часов.

В разделе настроек Вы можете выбрать тип отображения Ваших турбо страниц, добавить стили CSS Для персонализации, настроить меню и подключить счетчики отслеживания.

В разделе ОТЛАДКИ Вы сможете проверить отображение своего сайта в простом редакторе.

Если Вы подключены к рекламной сети Яндекса (РСЯ) или сети ADFOX, Вы можете добавить отображение рекламных блоков.

ГЛАВА 7:

Инструменты Яндекс Вебмастера

В этом разделе мы рассмотрим инструменты, которые доступны внутри интерфейса Яндекс.Вебмастер

Еще Яндекс Вебмастер, как и Гугл Вебмастер, предлагает свои утилиты.

Валидатор XML фидов

Валидатор XML фидов позволит проверить экспортные файлы XML, которые используются в сервисах Яндекс: в Яндекс.Недвижимости, Авто, Работе, Видео, Яндекс.

Отзывах, Маркете и Справочнике.

Просто выберите тип файла, укажите ссылку (или загрузите) и проверьте результат соответствия.

Незаменима для программистов — часто приходится настраивать.

Валидатор микроразметки

Валидатор микроразметки позволит проверить корректность установки микроразметки на Вашем сайте и даст рекомендации по ее настройке.

Есть удобный инструмент.

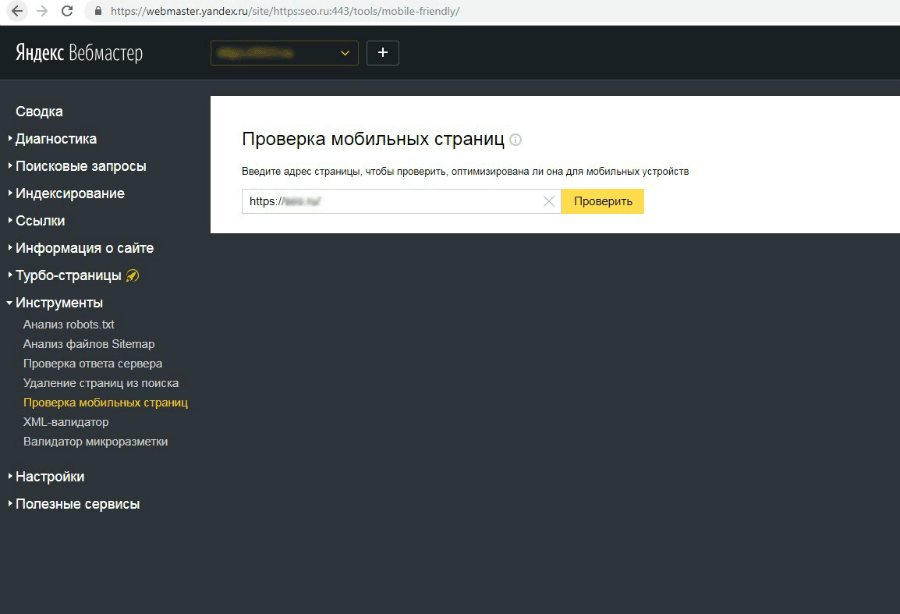

Проверка мобильных страниц.

Проверка мобильных страниц.

Позволяет проверить, оптимизирована ли конкретная посадочная страница для мобильных устройств, покажет превью мобильной версии и даст рекомендации относительно отдельных ошибок.

Утилита достаточно простая.

Вставьте ссылку и подождите несколько минут.

Готовый чеклист проверяет, прописали ли Вы Viewport для мобильных устройств, не прогружается ли горизонтальная прокрутка, отсутствуют ли Flash/Silverlight/JAVA элементы, и размер шрифта достаточно крупный, чтобы был удобен для чтения.

Также Яндекс не преминет напомнить о Турбо страницах, если Вы их не внедрили.

Удалите ссылку из индексации

Удалите ссылку из индексации.

Иногда бывает, что ссылки могли ошибочно попасть в индекс, (например — плохой программист или SEO оптимизатор открыл все страницы в Robots.txt) а на их удаление может пройти несколько месяцев.

А нужно все решить в считанные часы.

На помощь приходит простой и понятный инструмент.

Поддерживает два интерфейса.

Удаление по URL позволяет закинуть списком ссылки, которые требуется удалить вручную.

В день можно закинуть по 500 страниц.

Второй способ пригодится в более тяжелых случаях — например, для удаления из индекса целых разделов сайта.

Не забудьте внести правки затем в файл robots.txt во избежание повторного попадания в индекс.

Проверка ответа сервера

Проверка ответа сервера позволит отслеживать важные страницы, а также в ручном режиме проверить работоспособность страниц и их обход поисковым роботом.

Утилита достаточно понятная, и отображает, как поисковый робот воспринимает контент каждой страницы.

Инструмент проверки Sitemap.xml

Инструмент проверки Sitemap.xml позволит проверить качество собранного файла карты сайта.

Просто вставьте ссылку и проверьте, есть ли ошибки — попадают ли в карту закрытые от индексации страницы.

Сервис отклонения ссылок Яндекс.Вебмастер

К сожалению, сервиса, аналогичного Disavow Links, как у Гугла, у Яндекса пока не предвидится, поэтому, если конкуренты разместили на Вас много ссылок, в вебмастере Вы ничего сделать не сможете.

Есть огромное количество жалоб по этой теме в сети, и Яндекс всячески старается дорабатывать алгоритм по отслеживанию некачественных ссылок.

Как я говорил, также не стоит забывать, что в Вебмастере есть собственная техподдержка, где можно изложить претензии и написать сообщение напрямую.

ВЫВОДЫ

Яндекс Вебмастер — один из наиболее мощных инструментов для анализа ошибок Вашего сайта.

Те SEO оптимизаторы, которые не анализируют ошибки при помощи Вебмастеров, обычно затем не понимают, почему их сайты не продвигаются в ТОП и вообще почему теряют позиции в Яндекс.

Хотите проверить качество Ваших оптимизаторов?

Зайдите в вебмастер Яндекс и изучите следущие отчеты в первую очередь:

- Есть ли ошибки в разделе Диагностика. Если они были, посмотрите, когда были отправки на повторный анализ

- Нет ли никаких санкций в разделе Безопасность и нарушения?

- Какие запросы находятся в избранных? Идет ли отслеживание позиций по ним? Соответствуют ли они Вашему семантическому ядру сайта?

- Проводите ли Вы мониторинг Важных страниц сайта? Есть ли они в индексе?

- Добавлены ли карта сайта в вебмастере?

- Добавляются ли новый контент для статей в раздел Оригинальные тексты?

- Используется ли привязка к региону в справочнике и вебмастере?

- Включен ли раздел Товары и Цены для интернет-магазинов?

- Используется ли раздел Турбо-страницы для блога и новостного сайта?

- Проверьте статус URL важных страниц. Есть ли они в индексе и обходятся ли они роботом.

Этот несложный чеклист позволит Вам узнать, проводит ли Ваш SEO оптимизатор работу над сайтом и как он держит его в тонусе.

Оставляйте комментарии и делитесь своими успехами в продвижении!

Почему страницы сайта удаляются из поиска Яндекса и Google?

Не так страшен чёрт, как его малюют

– русская пословица

Иногда довольно сложно понять, что от тебя хотят поисковые системы, что именно они понимают под значением «страницы низкого качества»? Порой смотришь на страницу и откровенно не понимаешь, почему же её невзлюбил Яндекс или Google. В этой статье мы рассмотрим страницы, которые ПС удаляют из поиска, считая недостаточно качественными.

Страницы низкого качества в понимании поисковых систем

В блоге Яндекса Елена Першина даёт следующее определение страницы низкого качества: «Под понятием некачественная страница мы понимаем страницы, вероятность показа которых в поиске практически нулевая. По понятным причинам мы не рассказываем способы определения таких страниц, но это чёткий сигнал, что если вы хотите видеть эту страницу в поиске, то со страницей нужно что-то делать».

Внесём немного корректив в слова представителя Яндекса: так как алгоритмы иногда дают сбой, причём в пользу сайтов, страница может занимать ТОП, а потом бесследно пропасть из выдачи.

То есть, страницы низкого качества – это документы, которые не имеют ценности, не несут новую и полезную информацию, не дают релевантный ответ на вопрос пользователя, с точки зрения поисковых систем.

Как обнаружить удалённые низкокачественные страницы

Яндекс.Вебмастер

Проще всего найти исключённые страницы, воспользовавшись инструментом Яндекс.Вебмастер.

Переходим в раздел «Индексирование» – «Страницы в поиске».

Переходим на вкладку «Исключённые страницы» – выбираем статус «Недостаточно качественная».

Можно, не переходя с «Последних изменений», выбрать статус «Удалено: Недостаточно качественная».

Google Search Console

В отличие от Яндекса, Google не предоставляет информацию о том, какие страницы были удалены из поиска из-за качества. Даже в новой бета-версии Google Search Console, к сожалению, эта функция отсутствует.

Единственным сигналом от Google сейчас можно считать «Отправленный URL возвращает ложную ошибку 404». В таких случаях нужно проанализировать страницы, убедиться, что они существуют, а не удалены (и просто ответ сервера некорректен). Подробнее о мягкой 404 можно прочесть в нашем блоге.

Итак:

- Переходим в новую версию Google Search Console.

- В боковом меню находим «Статус» – «Индексирование отправленных URL».

- Выбираем строку «Отправленный URL возвращает ложную ошибку 404».

- Анализируем исключённые страницы.

Причины удаления страниц

Проанализировав большое количество различных сайтов и выявив закономерность у страниц, удалённых по причине низкого качества, мы пришли к следующим выводам:

1) Алгоритм Яндекса недоскональный: вместо того, чтобы отнести страницу в удалённые, например, по причине дублирования, он исключает её как низкокачественную.

2) Страницы низкого качества чаще встречаются на коммерческих сайтах – интернет-магазинах и агрегаторах, чем на информационных (за счёт автоматической генерации).

Типология удалённых страниц низкого качества

1. «Жертвы» некорректной работы алгоритма

К этой категории мы отнесём страницы, которые должны были быть удалены по другим причинам.

1.1. Дубли страниц

К страницам низкого качества довольно часто попадают дубликаты страниц.

Такие страницы довольно легко определить, если кроме URL ничего не уникализированно.

1.2. Страницы сортировки, пагинации и GET-параметры

Чаще Яндекс исключает такие страницы, как дубли, но, как показано на примере ниже, они могут быть удалены и по другой причине.

Страницы сортировки:

Страницы пагинации:

GET-параметры:

В этом примере GET-параметры определяют регион пользователя.

1.3. Неглавное зеркало

Сайт переехал на защищённый протокол. Долгое время робот Яндекса не знал, что делать со старой страницей на HTTP и, то удалял её как некачественную, то добавлял обратно в поиск. По итогу, спустя несколько месяцев, он удалил страницу как неглавное зеркало.

1.4. Страницы, закрытые в файле robots.txt

Директивы в файле robots.txt не являются прямыми указаниями для поисковых роботов, а служат больше рекомендациями. Исходя из практики, бот Яндекса больше придерживается установок, прописанных в файле, чем Google. Но не в этот раз. Как и в прошлом примере, «помучив» несколько раз страницу, он всё-таки «снизошёл» и удалил её из поиска как запрещённую в файле robots.txt.

2. Действительные недостаточно качественные страницы

В эту группу «я плох, бесполезен и никому не нужен» попадают страницы низкого качества, которые действительно являются таковыми.

2.1. Шаблонная генерация страниц

Часто шаблонное заполнение и генерация страниц влечёт за собой ошибки внутренней оптимизации: неуникальные Title, отсутствует Description, с h2 что-то не так и т. д.

Тут важно сказать, что пользователь без проблем поймёт разницу в страницах и для него они могут быть даже полезными, но он о них не узнает, так как роботы стоят на страже порядка не допустят попадания данных страниц в поиск.

Увидев Title на странице, долго не пришлось гадать, что с ней не так.

2.2. Плохое заполнение карточек товара

Создать карточку товара просто, а вот наполнить её качественным контентом, описанием товара, изображениями – не каждому под силу.

2.3. Листинг без листинга

Создавать страницы категорий/подкатегорий без товара – лишено смысла, так как:

- вряд ли такая страница попадёт в ТОП;

- вероятнее всего, показатель отказов на такой странице будет максимальный.

Об этом скажет и сам Яндекс, исключив страницу из поиска как недостаточно качественную.

2.4. Страницы с малым количеством контента

Несмотря на слова поддержки Яндекса, что важно не количество контента, а качество, его отсутствие – не очень хорошая идея.

Например, на этой странице, кроме шаблонной части и двух изображений, ничего нет.

2.5. Страницы, не предназначенные для поиска

В эту группу относятся страницы robots.txt, Sitemap, RSS-ленты.

Чуть ли не в каждом проекте можно встретить файл robots.txt, удалённый из поиска как недостаточно качественная страница.

Не стоит паниковать, робот о нём знает и помнит. Страница просто не будет отображаться в поисковой выдаче – ну а зачем она там нужна?

XML- и HTML-карты сайта также исключаются. Особенно если у вас многостраничная карта сайта – какая польза от неё в поиске?

Яндекс считает, что RSS-лентам в поиске тоже нет места.

2.6. Страницы с некорректным ответом сервера

В эту группу мы отнесём страницы, которые должны выдавать 404 ответ сервера, а вместо этого отвечают 200 ОК.

Например, это могут быть несуществующие страницы пагинации. Яндекс исключил восьмую страницу пагинации, при имеющихся семи.

Также это могут быть пустые страницы. В таком случае нужно анализировать и принимать решение: настраивать 404 ответ сервера или 301 редирект.

Google может удалить такие страницы, как SOFT 404, но об этом чуть позже.

2.7. «Нужно больше страниц»

Этим часто грешат агрегаторы и интернет-магазины, считая, что чем больше страниц, тем больше видимость и трафик. Страницы создают, не беря во внимание их качество и надобность.

Например, низкокачественными являются страницы, созданные под каждый вопрос из FAQ.

Часто бесполезные страницы создаются с помощью применения всех фильтров. Я соглашусь, что нужно думать о посетителях и удобстве пользования сайтом. Если у интернет-магазина большой ассортимент, то структура сайта должна состоять из множества категорий и подкатегорий, а также иметь различные фильтры. Но, во-первых, нужно ли создавать страницу для «Фарфоровых кукол 20 см с голубыми глазами в розовом платье с корзинкой» и, во-вторых, нужны ли такие страницы в поиске?

2.8. Технические ошибки

Яндекс не жалует страницы с pop-upом, который перекрывает текст без возможности его закрыть, или случайно созданные страницы под изображения.

Как должно быть и как реализовано на сайте:

Случайно созданная страница:

2.9. SOFT 404

Как мы уже говорили, Google прикрепляет страницам именно такой ярлык. Это могут быть пустые страницы или же страницы с очень малым количеством контента.

Влияние низкокачественных страниц на ранжирование

Сколько бы страниц ни было исключено из поиска по этой причине, на ранжировании остальных страниц сайта это никак не отразится.

Этот алгоритм удаления страниц анализирует каждую страницу отдельно, пытаясь ответить на вопрос: «Если страница будет в поиске, даст ли она релевантный ответ на вопрос пользователя?».

Как говорит Яндекс, страница может быть исключена из поиска даже в том случае, если отсутствуют запросы. Робот может вернуть её, если количество запросов, которым будет релевантна страница, увеличится.

Что же делать со страницами низкого качества

Принимать меры можно только после того, как вы определили причину исключения страницы из поиска. Без выяснения обстоятельств не стоит паниковать, сразу удалять страницы, настраивать 301 редирект.

Алгоритм действий после определения причины удаления страницы:

Дубли страниц: 301 редирект или rel=“canonical”.

Страницы сортировки, пагинации и GET-параметры: настраиваем rel=“canonical”/уникализируем страницы пагинации.

Неглавное зеркало: проверяем 301 редирект, отправляем на переиндексацию.

Страницы, закрытые в файле robots.txt: если страница не нужна в поиске, настраиваем метатег noindex.

Шаблонная генерация страниц: если страница нужна в поиске – уникализируем её, работаем над качеством.

Плохое заполнение карточек товара: добавляем описание товара, изображения и т. д.

Листинг без листинга:

- проверяем, приносили ли такие страницы трафик;

- определяем, нужны ли они пользователям;

- временно ли на них отсутствует товар или его не было и не будет.