Где находится файл robots.txt в wordpress, где лежит и как найти

Если вы посетили эту страницу тогда вас интересует где находится файл robots.txt в WordPress. С данной проблемой обычно сталкиваются чайники в WordPress. После прочтения короткой статьи вы выясните все что вам нужно знать.

По большому счету я могу написать просто “Файл расположен в корневой директории сайта”. Увы этот ответ удовлетворит лишь часть посетителей, не все знают о “корнях” и тому подобном. По этому давайте все разберем, как в первый раз.

Как проверить существует ли файл robots.txt

Сперва проверим есть ли нужный файл вообще, для этого вписываем в строке браузера адрес-сайта.ru/robots.txt, если документ откроется, и вы увидите текст на английском, примерно такого рода:

Значит все в порядке, файл существует, в противном случае, скорее всего, отсутствует, или находиться не там где нужно, его потребуется создать.

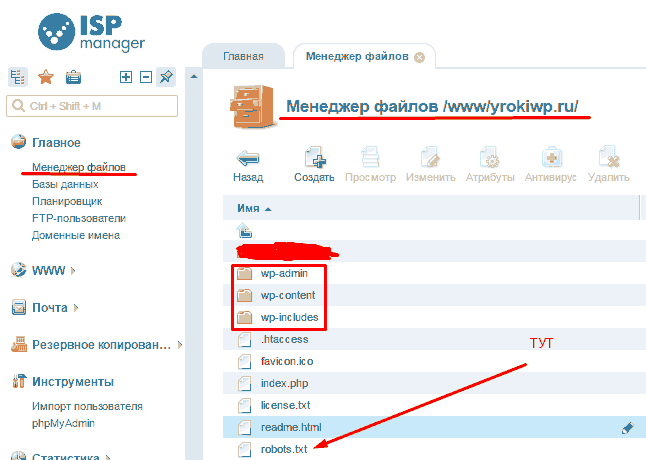

Давайте для начала определимся как вам удобно работать с файлами сайта. Для этого существует несколько способов. Первый не очень удобный, но зато более привычен для любителей Windows — это программа на вашем хостинге, с помощью которой вы создаете и удаляете файлы и папки своего сайта. Выглядеть это все дело должно примерно так:

В папке WWW/ВАШ-САЙТ должны быть папки wp-includes, wp-content, wp-admin ниже них расположен нужный вам файл роботс. Один способ разобрали, можно идти к следующему.

Если вы умеете пользоваться FTP, тогда заходим в соответствующую программу на вашем компьютере и переходим на ваш сайт, проходим тот же путь по папкам что в примере выше и находим необходимый документ.

Файл robots.txt в WordPress должен лежать именно в той же папке, что и wp-includes, wp-content, wp-admin. Не ищите его в других местах, его либо там нет либо он там валяется без толку, роботы его не найдут.

Создать правильное руководство для поисковых систем поможет эта статья.

Правильный robots.txt для WordPress — 2020

Robots.txt – текстовой файл, который сообщает поисковым роботам, какие файлы и папки следует сканировать (индексировать), а какие сканировать не нужно.

Поисковые системы, такие как Яндекс и Google сначала проверяют файл robots.txt, после этого начинают обход с помощью веб-роботов, которые занимаются архивированием и категоризацией веб сайтов.

Файл robots.txt содержит набор инструкций, которые просят бота игнорировать определенные файлы или каталоги. Это может быть сделано в целях конфиденциальности или потому что владелец сайта считает, что содержимое этих файлов и каталогов не должны появляться в выдаче поисковых систем.

Если веб-сайт имеет более одного субдомена, каждый субдомен должен иметь свой собственный файл robots.txt. Важно отметить, что не все боты будут использовать файл robots.txt. Некоторые злонамеренные боты даже читают файл robots.txt, чтобы найти, какие файлы и каталоги Вы хотели скрыть. Кроме того, даже если файл robots.txt указывает игнорировать определенные страницы на сайте, эти страницы могут по-прежнему появляться в результатах поиска, если на них ссылаются другие просканированные страницы. Стандартный роботс тхт для вордпресс открывает весь сайт для интдекса, поэтому нам нужно закрыть не нужные разделы WordPress от индексации.

Оптимальный robots.txt

User-agent: * # общие правила для роботов, кроме Яндекса и Google, # т.к. для них правила ниже Disallow: /cgi-bin # системная папка на хостинге, закрывается всегда Disallow: /? # все параметры запроса на главной Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет, # правило можно удалить) Disallow: *?s= # запрос поиска Disallow: *&s= # запрос поиска Disallow: /search/ # запрос поиска Disallow: /author/ # архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть # архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть Disallow: /users/ # архив авторов Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой # ссылки на статью Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: */embed # все встраивания Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете, # правило можно удалить) Disallow: /xmlrpc.php # файл WordPress API Disallow: *utm*= # ссылки с utm-метками Disallow: *openstat= # ссылки с метками openstat Allow: */uploads # открываем папку с файлами uploads # Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent # не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже. Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Host прописывать больше не нужно.

Расширенный вариант (разделенные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google, # т.к. для них правила ниже Disallow: /cgi-bin # папка на хостинге Disallow: /? # все параметры запроса на главной Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет, # правило можно удалить) Disallow: *?s= # поиск Disallow: *&s= # поиск Disallow: /search/ # поиск Disallow: /author/ # архив автора Disallow: /users/ # архив авторов Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой # ссылки на статью Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: */embed # все встраивания Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете, # правило можно удалить) Disallow: /xmlrpc.php # файл WordPress API Disallow: *utm*= # ссылки с utm-метками Disallow: *openstat= # ссылки с метками openstat Allow: */uploads # открываем папку с файлами uploads User-agent: GoogleBot # правила для Google (комментарии не дублирую) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета) Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета) Allow: /wp-*.png # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д. Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS User-agent: Yandex # правила для Яндекса (комментарии не дублирую) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать # от индексирования, а удалять параметры меток, # Google такие правила не поддерживает Clean-Param: openstat # аналогично # Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent # не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже. Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Host прописывать больше не нужно.

Оптимальный Robots.txt для WooCommerce

Владельцы интернет-магазинов на WordPress – WooCommerce также должны позаботиться о правильном robots.txt. Мы закроем от индексации корзину, страницу оформления заказа и ссылки на добавление товара в корзину.

User-agent: *

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Sitemap: https://site.ru/sitemap_index.xmlГде находится файл robots.txt в WordPress

Обычно robots.txt располагается в корне сайта. Если его нет, то потребуется создать текстовой файл и загрузить его на сайт по FTP или панель управления на хостинге. Если Вы не смогли найти robots.txt в корне сайта, но при переходе по ссылке вашсайт.ру/robots.txt он открывается, значит какой то из SEO плагинов сам генерирует его.

К примеру плагин Yoast SEO создает виртуальный файл, которого нет в корне сайта.

Как редактировать robots.txt с помощью Yoast SEO

- Зайдите в админ панель сайта

Админа панель находится по следующему адресу вашсайт.ру/wp-admin/

- Слева в консоли наведите на кнопку SEO и в выпадающем окне выберите “Инструменты”. Перейдите в раздел, как указано на картинке.

- Зайдите в редактор файлов

Этот инструмент позволит быстро отредактировать такие важные для вашего SEO файлы, как robots.txt и .htaccess (при его наличии).

- Если файла robots.txt нет, нажмите на кнопку создать, либо вставьте нужное содержимое.

Содержимое файла для WordPress и WooCommerce можно взять из примеров выше.

- Сохраните изменения в robots.txt

После сохранения файла вы можете проверить правильность через сервисы проверки.

Чтобы установить плагин Yoast SEO воспользуйтесь данной статьей – ссылка.

Часто задаваемые вопросы

Закрывать ли feed в robots.txt?По умолчанию мы рекомендуем закрывать feed от индексации в robots.txt. Открытие feed может потребоваться, если вы например настраиваете Турбо-страницы от Яндекса или выгружаете свою ленту в другой сервис.

Добавьте директиву: Allow: /feed/turbo/, тогда Яндекс сможет проверять ваши турбо-страницы и обновлять их.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Как создать файл robots.txt для WordPress. 4 способа

Всем, привет! Сегодня небольшой пост — как автоматически создать файл robots.txt для WordPress? Друзья, вы можете создать правильный robots.txt для WordPress в пару кликов, прочитав данное руководство. Создание правильного файла robots.txt для WordPress очень важно. Благодаря ему поисковые системы будут знать, какие страницы индексировать и показывать в поиске. То есть, результаты поиска будут именно такими, как вам нужно, без дублирования страниц WordPress.

robots.txt для сайта WordPress

robots.txt для сайта WordPressЧитайте, дамы и господа — WordPress robots.txt: лучшие примеры для SEO.

Файл robots.txt для WordPress

WordPress robots.txt где лежит/находится? По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы ни чего не делали, на вашем сайте ВордПресс уже должен быть файл robots.txt. Вы можете проверить, так ли это, добавив /robots.txt в конец вашего доменного имени. Например, так https://ваш сайт/robots.txt

Виртуальный файл robots.txt в WordPress

Виртуальный файл robots.txt в WordPressПоскольку этот файл является виртуальным, вы не можете его редактировать. Однако, если вы хотите отредактировать свой файл robots.txt WordPress как надо, вам необходимо создать физический файл на вашем хостинге. Создайте свой правильный robots.txt для WordPress, который вы сможете легко редактировать по мере необходимости.

Как создать файл robots.txt для WordPress

Robots.txt — это текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем.

Файл robots.txt сообщает поисковым роботам, какие страницы или файлы на вашем сайте можно или нельзя обрабатывать.

Яндекс и Google

Для начала напомню вам, создать (и редактировать) файл robots.txt для WordPress можно вручную и с помощью плагина Yoast SEO

Создать файл robots.txt

Создать файл robots.txtДрузья, имейте ввиду, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots.txt ВордПресс:

Редактирование robots.txt в плагине Yoast SEO

Редактирование robots.txt в плагине Yoast SEOЧто должно быть в правильно составленного robots.txt? Идеального файла не существует. Например, сайт Yoast SEO использует такой robots.txt для WordPress:

User-agent: *И всё. Для большинства сайтов WordPress лучший пример. Вот даже скриншот сделал у Yoast SEO:

Что это значит? Директива говорит что, все поисковые роботы могут свободно сканировать этот сайт без ограничений. Этого хватит для правильной индексации сайта WP. А наша SEO специалисты рекомендуют почти тоже самое. Пример, правильно составленного robots.txt для WordPress сайта:

User-agent: *

Disallow:

Sitemap: https://mysite.ru/sitemap.xmlДанная запись в файле роботс делает доступным для индексирования полностью сайт для роботов всех известных поисковиков. Здесь, также прописан путь к карте сайта XML.

Создать и редактировать файл также можно при помощи All in One SEO Pack прямо из интерфейса SEO плагина. Модуль robots.txt в SEO-пакете Все в одном позволяет вам настроить файл robots.txt для вашего сайта, который переопределит файл robots.txt по умолчанию, который создает WordPress:

Применение плагина All in One SEO Pack

Применение плагина All in One SEO PackВы сможете управлять своим файлом Robots.txt, в разделе All in One SEO Pack — Robots.txt. Сам официальный сайт плагина использует вот такой роботс:

Правила по умолчанию, которые отображаются в поле Создать файл Robots.txt (показано на снимке экрана выше), требуют, чтобы роботы не сканировали ваши основные файлы WordPress. Для поисковых систем нет необходимости обращаться к этим файлам напрямую, потому что они не содержат какого-либо релевантного контента сайта.

А если вы не используете данные SEO модули, то предлагаю вам воспользоваться специальным плагином — Robots.txt Editor.

Плагин Robots.txt Editor

Плагин Robots.txt для WordPress — создание и редактирование файла robots.txt для сайта ВордПресс. Очень простой, лёгкий и эффективный плагин.

WordPress плагин Robots.txt Editor

WordPress плагин Robots.txt EditorПлагин Robots.txt Editor (редактор) позволяет создать и редактировать файл robots.txt на вашем сайте WordPress.

Плагин Robots.txt возможности

- Работает в сети сайтов Multisite на поддоменах;

- Пример правильного файла robots.txt для WordPress;

- Не требует дополнительных настроек;

- Абсолютно бесплатный.

Как использовать? Установите плагин robots.txt стандартным способом. То есть, из админки. Плагины — Добавить новый. Введите в окно поиска его название — Robots.txt Editor:

Добавить плагин Robots.txt Editor

Добавить плагин Robots.txt EditorУстановили и сразу активировали. Всё, готово. Теперь смотрим, что получилось. Заходим, Настройки — Чтение и видим результат. Автоматически созданный правильный файл robots.txt для WordPress со ссылкой на ваш файл Sitemap. Пример, правильный robots.txt для сайта ВордПресс:

Созданный файл robots.txt WordPress

Созданный файл robots.txt WordPressЕстественно, вы можете его легко отредактировать под свои нужды. А также просмотреть, нажав соответствующею ссылку — Просмотр robots.txt.

Как создать robots.txt вручную

Если вы не захотите использовать плагины, которые предлагают функцию robots.txt, вы все равно можете создать и управлять своим файлом robots.txt на своём хостинге. Как создать файл robots.txt самостоятельно?

В текстовом редакторе создайте файл с именем robots в формате txt и заполните его:

Создать файл с именем robots.txt

Создать файл с именем robots.txtФайл должен иметь имя robots.txt и никакое другое больше. Сохраните данный файл локально на компьютере. А затем, загрузите созданный файл в корневую директорию вашего сайта.

Корневая папка (корневая директория/корневой каталог/корень документа) — это основная папка, в которой хранятся все файлы сайта. Обычно, это папка public_html (там где находятся файлы — .htaccess, wp-config.php и другие). Именно в эту папку загружается файл robots.txt:

Загрузите файл в корневую папку вашего сайта

Загрузите файл в корневую папку вашего сайта Чтобы проверить, получилось ли у вас положить файл в нужное место, перейдите по адресу: https://ваш_сайт.ru/robots.txt

Теперь, когда ваш файл robots.txt создан и загружен на сайт, вы можете проверить его на ошибки.

Проверка вашего файла robots.txt

Вы можете проверить файл robots.txt WordPress в Google Search Console и Яндекс.Вебмастер, чтобы убедиться, что он правильно составлен.

Например, проверка файла robots.txt WordPress в Яндекса.Вебмастер. В блоке Результаты анализа robots.txt перечислены директивы, которые будет учитывать робот при индексировании сайта.

Анализ robots.txt в Яндекс.Вебмастер

Анализ robots.txt в Яндекс.ВебмастерЕсли будет найдена ошибка, информация об этом будет показана вам.

В заключение

Для некоторых сайтов WordPress нет необходимости срочно изменять стандартный виртуальный файл robots.txt (по умолчанию). Но, если вам нужен физический файл robots.txt, то используйте плагины Robots.txt Editor, All in One SEO Pack или Yoast SEO. С ними можно легко редактировать файл прямо из панели инструментов WordPress, чтобы добавить свои собственные правила.

До новых встреч, друзья и я надеюсь, что вам понравилось это маленькое руководство. И не стесняйтесь, обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы по использованию файла robots.txt на сайте WordPress.

Как настроить robots txt для сайта WordPress. Как создать robots txt для WordPress

От автора: одним из файлов, которые используют поисковики при индексации вашего сайта, есть файл robots.txt. Не сложно понять из названия файла, что он используется для роботов. И действительно, этот файл позволяет указать поисковому роботу что можно индексировать на вашем сайте, а что вы не хотите видеть в поисковом индексе. Итак, давайте посмотрим, как настроить robots txt для сайта WordPress.

Статей на эту тему в сети множество. Практически в каждой из этих статей можно найти свой вариант файла robots txt, который можно взять и использовать практически без правок на своем сайте WordPress. Я не буду в очередной раз переписывать в данной статье один из таких вариантов, поскольку особого смысла в этом нет — все эти варианты вы без труда сможете найти в сети. В этой же статье мы просто разберем, как как создать robots txt для WordPress и какой минимум правил там должен быть.

Начнем с того, где должен располагаться файл robots.txt и что в него писать. Данный файл, как и файл sitemap.xml, должен быть расположен в корне вашего сайта, т.е. он должен быть доступен по адресу http://site/robots.txt

Попробуйте обратиться по такому адресу, заменив слово site адресом вашего сайта. Вы можете увидеть при этом примерно такую картину:

Бесплатный курс «Основы создания тем WordPress»

Изучите курс и узнайте, как создавать мультиязычные темы с нестандартной структурой страниц

Скачать курсХотя можете увидеть и вот такую картину:

Странная ситуация — скажете вы. Действительно, адрес один и тот же, но в первом случае файл доступен, во втором — нет. При этом если заглянуть в корень сайта, то никакого файла robots.txt вы там не обнаружите. Как так и где же находится robots.txt в WordPress?

Все дело в простой настройке — это настройка ЧПУ. Если на вашем сайте включены ЧПУ, тогда вы увидите динамически сгенерированный движком robots.txt. В противном случае будет возвращена ошибка 404.

Включим ЧПУ в меню Настройки — Постоянные ссылки, отметив настройку Название записи. Сохраним изменения — теперь файл robots.txt будет динамически генерироваться движком.

Как видно на первом рисунке, в этом файле используются некие директивы, задающие определенные правила, а именно — разрешить или запретить индексировать что-либо по заданному адресу. Как несложно догадаться, директива Disallow запрещает индексирование. В данном случае это все содержимое папки wp-admin. Ну а директива Allow разрешает индексирование. В моем случае разрешено индексирование файла admin-ajax.php из запрещенной выше папки wp-admin.

В общем, поисковикам этот файл, конечно, без надобности, даже и не представляю, из каких соображений WordPress прописал это правило. Ну да мне и не жалко, в принципе ![]()

К слову, я специально добавлял выше фразу «в моем случае «, поскольку в вашем случае содержимое robots.txt уже может отличаться. Например, может быть запрещена к индексированию папка wp-includes.

Кроме директив Disallow и Allow в robots.txt мы видим директиву User-agent, для которой в качестве значения указана звездочка. Звездочка означает, что идущий далее набор правил относится ко всем поисковикам. Также можно вместо звездочки указывать названия конкретных поисковиков. Файл robots.txt поддерживает и другие директивы. Я на них останавливаться не буду, все их с примерами можно посмотреть в консоли для веб-мастеров Гугла или Яндекса. Также можете прочесть информацию на данном сайте.

Как создать robots txt для WordPress

Итак, файл для поисковых роботов у нас есть, но вполне вероятно, что он вас не устроит в текущем виде. Как же составить свой файл. Здесь есть несколько вариантов. Начнем с первого — ручное создание файла. Создайте обычный текстовый документ в блокноте и сохраните его под именем robots с расширением txt. В этом файле запишите необходимый набор правил и просто сохраните его в корень вашего сайта WordPress, рядом с файлом конфигурации wp-config.php.

На всякий случай проверьте, что файл загрузился и доступен, обратившись к нему из браузера. Это был первый способ. Второй способ — это все та же динамическая генерация файла, только теперь это сделает плагин. Если вы используете популярный плагин All in One SEO, тогда можно воспользоваться одним из его модулей.

Сначала этот модуль нужно включить. Идем в меню All in One SEO — Управление модулями и активируем модуль Robots.txt.

После этого в меню плагина появится новый пункт — Robots.txt. Перейдем туда и увидим уже предлагаемый набор правил, который можно сохранить.

Давайте сохраним и проверим изменения, обратившись на сайте WordPress к robots.txt.

Как видим, все работает. Теперь вы можете написать robots txt для WordPress на свой вкус и так, как вам нужно. Ну а у меня на этом все. Удачи!

Бесплатный курс «Основы создания тем WordPress»

Изучите курс и узнайте, как создавать мультиязычные темы с нестандартной структурой страниц

Скачать курс

WordPress-Ученик

12 фишек без которых Вы не создадите полноценный сайт на WordPress!

СмотретьГде находится robots.txt в WordPress? — Хабр Q&A

Добрый день. Дали сайт на вордпрессе, набираю домент site.ru/robots.txt — в нёмUser-agent: * Disallow: /

Лезу по ftp, в корне лежит robots.txt

User-agent: *

Disallow: /cgi-bin

Disallow: /search

Disallow: /author/

Disallow: *?attachment_id=

Disallow: */trackback

Disallow: */feed

Disallow: */embed

#Disallow: /wp/

Host: www.site.ruКак убрать Disallow то от всех поисковиков?

.htaccess

RewriteBase /

RewriteRule ^index\.php$ - [L]

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule . /index.php [L]

</IfModule>

# BEGIN W3TC Browser Cache

<IfModule mod_deflate.c>

<IfModule mod_headers.c>

Header append Vary User-Agent env=!dont-vary

</IfModule>

AddOutputFilterByType DEFLATE text/css text/x-component application/x-javascript application/javascript text/javascript text/x-js text/html text/richtext image/svg+xml text/plain text/xsd text/xsl text/xml image/bmp application/java application/msword application/vnd.ms-fontobject application/x-msdownload image/x-icon application/json application/vnd.ms-access application/vnd.ms-project application/x-font-otf application/vnd.ms-opentype application/vnd.oasis.opendocument.database application/vnd.oasis.opendocument.chart application/vnd.oasis.opendocument.formula application/vnd.oasis.opendocument.graphics application/vnd.oasis.opendocument.presentation application/vnd.oasis.opendocument.spreadsheet application/vnd.oasis.opendocument.text audio/ogg application/pdf application/vnd.ms-powerpoint application/x-shockwave-flash image/tiff application/x-font-ttf application/vnd.ms-opentype audio/wav application/vnd.ms-write application/font-woff application/font-woff2 application/vnd.ms-excel

<IfModule mod_mime.c>

# DEFLATE by extension

AddOutputFilter DEFLATE js css htm html xml

</IfModule>

</IfModule>

<FilesMatch "\.(bmp|class|doc|docx|eot|exe|ico|json|mdb|mpp|otf|_otf|odb|odc|odf|odg|odp|ods|odt|ogg|pdf|pot|pps|ppt|pptx|svg|svgz|swf|tif|tiff|ttf|ttc|_ttf|wav|wri|woff|woff2|xla|xls|xlsx|xlt|xlw|BMP|CLASS|DOC|DOCX|EOT|EXE|ICO|JSON|MDB|MPP|OTF|_OTF|ODB|ODC|ODF|ODG|ODP|ODS|ODT|OGG|PDF|POT|PPS|PPT|PPTX|SVG|SVGZ|SWF|TIF|TIFF|TTF|TTC|_TTF|WAV|WRI|WOFF|WOFF2|XLA|XLS|XLSX|XLT|XLW)$">

<IfModule mod_headers.c>

Header unset Last-Modified

</IfModule>

</FilesMatch>

# END W3TC Browser Cache

# BEGIN W3TC CDN

<FilesMatch "\.(ttf|ttc|otf|eot|woff|woff2|font.css)$">

<IfModule mod_headers.c>

Header set Access-Control-Allow-Origin "*"

</IfModule>

</FilesMatch>

# END W3TC CDN

# BEGIN W3TC Page Cache core

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteBase /

RewriteCond %{HTTP:Accept-Encoding} gzip

RewriteRule .* - [E=W3TC_ENC:_gzip]

RewriteCond %{HTTP_COOKIE} w3tc_preview [NC]

RewriteRule .* - [E=W3TC_PREVIEW:_preview]

RewriteCond %{REQUEST_METHOD} !=POST

RewriteCond %{QUERY_STRING} =""

RewriteCond %{HTTP_COOKIE} !(comment_author|wp\-postpass|w3tc_logged_out|wordpress_logged_in|wptouch_switch_toggle) [NC]

RewriteCond "%{DOCUMENT_ROOT}/wp-content/cache/page_enhanced/%{HTTP_HOST}/%{REQUEST_URI}/_index%{ENV:W3TC_PREVIEW}.html%{ENV:W3TC_ENC}" -f

RewriteRule .* "/wp-content/cache/page_enhanced/%{HTTP_HOST}/%{REQUEST_URI}/_index%{ENV:W3TC_PREVIEW}.html%{ENV:W3TC_ENC}" [L]

</IfModule>

# END W3TC Page Cache core

# BEGIN WordPress

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteBase /

RewriteRule ^index\.php$ - [L]

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule . /index.php [L]

</IfModule>Файл robots.txt — где взять и как установить в WordPress

Привет, читатель блога Веб Остров! Вчера мы узнали о том, как установить плагин транслитерации Cyr-to-lat. А на сегодняшнем занятии я вам расскажу о важном значении файла robots.txt, где его откопать и куда пристроить.

Настраивается он в самом начале, когда вы только создали блог. Итак, делайте всё пошагово, как я вам расскажу. Тогда проблем возникнуть не должно 😉

Что такое файл robots.txt

Для начала расскажу немного о нём. Это файл, который содержит необходимые команды для поисковых систем. Разумеется, поисковики и так увидят ваш сайт и будут индексировать. Но нужно ли проводить индексацию всего подряд? Конечно, нет.

Ведь там и технические файлы имеются, какие-то ненужные архивы и т.д. Поэтому файл robots.txt укажет роботам поисковых систем, что подлежит индексации, а что надо скрыть.

Где взять файл robots.txt

Чтобы вы не заморачивались сами с написанием этого документа, я рекомендую скачать его у меня в качестве шаблона. Да и навыки эти есть далеко не у всех. Когда-то и для меня это был просто набор букв. Так что со временем и вы во всём разберётесь.

<<<Скачать файл robots.txt>>>

Как скачаете, обязательно проверьте, чтобы его название было именно robots. Потому что если вы вдруг случайно нажали на скачивание два раза, то во второй раз создастся копия с отличным названием. Например, такая robots(1). В этом случае можно просто переименовать файл.

Меняем содержимое файла robots.txt

Вы же помните, что скачали лишь шаблон? А значит, открываем файл и производим изменения в двух последних строчках. А именно, меняем ontortuga.ru на название вашего сайта. И сохраняем. Тут всё просто. Но между делом хочу обратить ваше внимание на следующее.

Так как вы только начали работу по созданию сайта, то установка сертификата SSL будет у вас впереди. Поэтому именно так выглядят адреса в двух последних строках. А когда SSL установлен, то в этих строках немного поменяем вид. В строке Host к адресу добавляется https, а в строке Sitemap буква s.

Только после установки SSL

Только после установки SSLСейчас это запоминать не обязательно. Это так, чтобы вы знали на будущее.

Теперь запомните, в какой папке вашего компьютера он сохранился. И переходим к установке.

Куда установить файл robots.txt

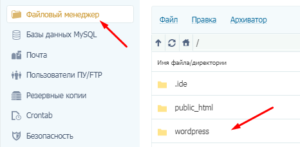

Далее заходим в панель управления хостинга. Я буду показывать на примере хостинга Timeweb, так как именно он пришёлся мне по душе, и я сама им пользуюсь. Слева открываем вкладку Файловый менеджер и заходим в корневую папку сайта. Если вы не помните или не знаете, где она, то можете прочесть урок об определении корня сайта.

В моём случае это папка wordpress. Заходим в неё и далее открываем папку с названием public_html. И вот теперь нажимаем вкладку Файл -> Загрузить на сервер, как я показала на скриншоте.

Перед вами появится окно загрузки. Жмём Прикрепить файл. Затем вам нужно выбрать на своём ПК сохранённый robots.txt, проверив ещё раз правильность написания. И следом жмём кнопку Загрузить. Смотрим следующий скриншот.

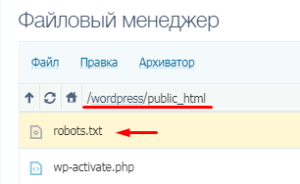

Готово. Он должен у вас появиться в списке.

Готово. Он должен у вас появиться в списке.

Если вы взгляните на адресную строку, то она должна выглядеть таким образом.

Если корневая папка у вас имеет другое название, то первая часть адреса будет отличаться.

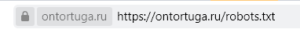

Проверка отображения

А теперь о самом главном. Когда мы сделали загрузку, нам необходимо убедиться в правильности действий. Для этого в строке браузера к адресу сайта добавляем robots.txt. И в этом случае должно открыться окно с содержимым.

Иными словами, именно то, что мы рассматривали выше, когда открывали этот файл, вы должны увидеть. Если же этого не произошло, где-то вы допустили ошибку. Тогда просто проделайте все шаги ещё раз внимательно.

На этом всё. Надеюсь, что у вас получится с первого раза 😉 До скорых встреч!

В следующем уроке мы настроим граватар и узнаем, как от него получить пользу. Присоединяйтесь)

Если вы только начали работать в WordPress, не лишним будет узнать о самых важных плагинах. Я составила список с кратким описанием.

Правильный Robots.txt для WordPress 2020 — AWayne

Автор Alexander Wayne На чтение 7 мин. Просмотров 10.3k. Обновлено 07.01.2020

Правильный Robots.txt для WordPress в 2020-м году. Несколько версий под разные нужды: простая базовая и расширенная — с проработкой под каждую поисковую систему.

Одной из важнейших вещей при создании и оптимизации сайта для поисковых систем считают Robots.txt. Небольшой файлик, где прописаны правила индексирования для поисковых роботов.

Если файл будет настроен неправильно, то сайт может неправильно индексироваться и терять большие доли трафика. Грамотная настройка наоборот позволяет улучшить SEO, и вывести ресурс в топы.

Сегодня мы поговорим о настройке Robots.txt для WordPress. Я покажу вам правильный вариант, который сам использую для своих проектов.

Что такое Robots.txt

Как я уже и сказал, robots.txt — текстовой файлик, где прописаны правила для поисковых систем. Стандартный robots.txt для WordPress выглядит следующим образом:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Именно в таком виде он создается плагином Yoast SEO. Некоторые считают, что этого хватит для правильной индексации. Я же считаю, что нужна более детальная проработка. А если речь идет о нестандартных проектах, то проработка нужна и подавно. Давайте разберемся в основных директивах:

| Директива | Значение | Пояснение |

| User-agent: | Yandex, Googlebot и т.д. | В этой директиве можно указать к какому конкретно роботу мы обращаемся. Обычно используются те значения, которые я указал. |

| Disallow: | Относительная ссылка | Директива запрета. Ссылки, указанные в этой директиве будут игнорироваться поисковыми системами. |

| Allow: | Относительная ссылка | Разрешающая директива. Ссылки, которые указаны с ней будут проиндексированы. |

| Sitemap: | Абсолютная ссылка | Здесь указывается ссылка на XML-карту сайта. Если в файле не указать эту директиву, то придется добавлять карту вручную (через Яндекс.Вебмастер или Search Console). |

| Crawl-delay: | Время в секундах (пример: 2.0 — 2 секунды) | Позволяет указать таймаут между посещениями поисковых роботов. Нужна в случае, если эти самые роботы создают дополнительную нагрузку на хостинг. |

| Clean-param: | Динамический параметр | Если на сайте есть параметры вида site.ru/statia?uid=32, где ?uid=32 — параметр, то с помощью этой директивы их можно скрыть. |

В принципе, ничего сложного. Дам дополнительные пояснения по директивам Clean-param (откройте вкладку).

Подробнее о Clean-param

Параметры, как правило, используются на динамических сайтах. Они могут передавать поисковым системам лишнюю информацию — создавать дубли. Чтобы избежать этого, мы должны указать в Robots.txt директиву Clean-param с указанием параметра и ссылки, к которой это параметр применяется.

В нашем примере site.ru/statia?uid=32 — site.ru/statia — ссылка, а все, что после знака вопроса — параметр. Здесь это uid=32. Он динамический, и это значит, что параметр uid может принимать другие значения.

Например, uid=33, uid=34…uid=123434. В теории их может быть сколько угодно, поэтому мы должны закрыть от индексации все параметры uid. Для этого директива должна принять такой вид:

Clean-param: uid /statia # все параметры uid для statia будут закрыты

Более подробно о том, что такое Robots.txt можно узнать из Яндекс.Помощи. Или из этого видеоролика:

Базовый Robots.txt для WordPress

Совсем недавно я приобрел плагин Clearfy Pro для своих проектов. Там очень много разных функций, и одна из них — создание идеального Robots.txt. На самом деле насколько он идеален — я не знаю, вебмастера расходятся во мнениях.

Кто-то предпочитает делать более краткие версии роботса, указывая правила для всех поисковых систем сразу. Другие прописывают отдельные правила для каждого поисковика (в основном для Яндекса и Гугла).

Что из этого правильно — точно сказать не могу. Однако я предлагаю вам ознакомиться с базовой версией Robots.txt для WordPress от Clearfy Pro. Я немного подредактировал ее — указал директиву Sitemap. Удалил директиву Host.

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Allow: /*.css Allow: /*.js Sitemap: https://site.ru/sitemap.xml

Не могу сказать, что это лучший вариант для блогов на ВП. Но во всяком случае, он лучше, чем то, что нам предлагает Yoast SEO по умолчанию.

Расширенный Robots.txt для WordPress

Теперь посмотрим на расширенную версию Robots.txt для WordPress. Наверняка вы знаете, что все сайты на WP имеют одинаковую структуру. Одинаковые названия папок, файлов и т.д. позволяют специалистам выявить наиболее приемлемый вариант роботса.

В этой статье я хочу представить вам свой вариант Robots.txt. Его я использую как для своих сайтов, так и для клиентских. Вы могли видеть такой вариант и на других сайтах, т.к. он обладает некоторой популярностью.

Итак, правильный Robots.txt для WordPress выглядит следующим образом:

User-agent: * # Для всех поисковых систем, кроме Яндекса и Гугла Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ # Закрываем метки Disallow: /readme.html # Закрываем бесполезный мануал по установке WordPress (лежит в корне) Disallow: *?replytocom Allow: */uploads User-agent: GoogleBot # Для Гугла Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ # Закрываем метки Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php User-agent: Yandex # Для Яндекса Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: /tag/ # Закрываем метки Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign Clean-Param: openstat Sitemap: https://site.com/sitemap_index.xml # Карта сайта, меняем site.com на нужный адрес.

Важно:

Ранее в Robots.txt использовалась директива Host. Она указывала главное зеркало сайта. Теперь это делается при помощи редиректа. Подробнее об этом можно почитать в блоге Яндекса.Комментарии (текст после #) можно удалить. Указываю Sitemap с https протоколом, т.к. большинство сайтов сейчас используют защищенное соединение. Если у вас нет SSL, то измените протокол на http.

Обратите внимание на то, что я закрываю метки (теги). Делаю это потому, что они создают большое количество дублей. Это плохо сказывается на SEO, но если вы хотите открыть метки, тогда уберите строчку disallow: /tag/ из файла.

Заключение

В общем-то, вот так выглядит правильный Robots.txt для WordPress. Смело копируйте данные в файл и пользуйтесь. Отмечу, что этот вариант подходит только для стандартных информационных сайтов.

В других ситуациях может потребоваться индивидуальная проработка. На этом все. Спасибо за внимание. Буду благодарен, если вы включите уведомления через колокольчик и подпишитесь на почтовую рассылку. Тут будет круто :).

Видео на десерт: Фермер Хотел Найти Воду, но То Что Случилось Удивило Весь Мир

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

( 15 оценок, среднее 5 из 5 )

ОптимизацияWordPress Robots.txt (+ XML Sitemap) — посещаемость веб-сайта, рейтинг и SEO Booster + Woocommerce — плагин WordPress

Better Robots.txt создает виртуальный файл robots.txt WordPress, помогает вам повысить SEO вашего веб-сайта (возможности индексации, рейтинг Google и т. Д.) И производительность загрузки — Совместимость с Yoast SEO, Google Merchant, WooCommerce и сетевыми сайтами на основе каталогов ( МУЛЬТИСИТ)

С помощью Better Robots.txt вы можете определить, каким поисковым системам разрешено сканировать ваш сайт (или нет), указать четкие инструкции о том, что им разрешено (или нет), и определить задержку сканирования (для защиты вашего хостинг-сервера от агрессивные скребки).Better Robots.txt также дает вам полный контроль над содержимым файла robots.txt в WordPress с помощью окна пользовательских настроек.

Уменьшите экологический след своего сайта и выбросы парниковых газов (CO2), обусловленные его существованием в сети.

Краткий обзор:

ПОДДЕРЖИВАЕТСЯ НА 7 ЯЗЫКАХ

ПлагиныBetter Robots.txt переведены и доступны на следующих языках: китайский — 汉语 / 漢語, английский, французский — Français, русский –Руссɤɢɣ, португальский — Português, испанский — Español, немецкий — Deutsch

Знаете ли вы, что…

- Роботы.txt — это простой текстовый файл, размещаемый на вашем веб-сервере, который сообщает поисковым роботам (например, роботу Google), следует ли им обращаться к файлу.

- Файл robots.txt контролирует, как пауки поисковых систем видят ваши веб-страницы и взаимодействуют с ними;

- Этот файл и боты, с которыми они взаимодействуют, являются фундаментальными частями работы поисковых систем;

- Первое, на что смотрит сканер поисковой системы при посещении страницы, — это файл robots.txt;

Роботы.txt — это источник сока SEO, который только и ждет, чтобы его разблокировали. Попробуйте Better Robots.txt!

О версии Pro (дополнительные возможности):

1. Повысьте свой контент в поисковых системах с помощью карты сайта!

Убедитесь, что ваши страницы, статьи и продукты, даже самые последние, принимаются во внимание поисковыми системами!

Плагин Better Robots.txt был создан для работы с плагином Yoast SEO (вероятно, лучшим плагином SEO для веб-сайтов WordPress).Он определит, используете ли вы в настоящее время Yoast SEO и активирована ли функция карты сайта. Если это так, то он автоматически добавит инструкции в файл Robots.txt, предлагая ботам / сканерам прочитать вашу карту сайта и проверить, внесли ли вы последние изменения на свой сайт (чтобы поисковые системы могли сканировать новый доступный контент).

Если вы хотите добавить свою собственную карту сайта (или если вы используете другой плагин SEO), вам просто нужно скопировать и вставить URL-адрес вашей карты сайта и Better Robots.txt добавит его в ваш WordPress Robots.txt.

2. Защитите свои данные и контент

Не позволяйте плохим ботам сканировать ваш сайт и коммерциализировать ваши данные.

Плагин Better Robots.txt помогает заблокировать сканирование и очистку ваших данных наиболее популярными вредоносными ботами.

Когда дело доходит до сканирования вашего сайта, есть хорошие и плохие боты. Хорошие боты, такие как бот Google, сканируют ваш сайт, чтобы проиндексировать его для поисковых систем. Другие сканируют ваш сайт по более гнусным причинам, таким как удаление вашего контента (текст, цена и т. Д.)) для переиздания, загрузки целых архивов вашего сайта или извлечения изображений. Сообщалось, что некоторые боты даже закрывали целые веб-сайты в результате интенсивного использования широкополосного доступа.

Плагин Better Robots.txt защищает ваш сайт от «пауков» / парсеров, которые Distil Networks определили как плохие боты.

3. Скрыть и защитить обратные ссылки

Не позволяйте конкурентам определять ваши прибыльные обратные ссылки.

Обратные ссылки, также называемые «входящими ссылками» или «входящими ссылками», создаются, когда один веб-сайт ссылается на другой.Ссылка на внешний веб-сайт называется обратной ссылкой. Обратные ссылки особенно ценны для SEO, потому что они представляют собой «вотум доверия» от одного сайта к другому. По сути, обратные ссылки на ваш сайт являются сигналом для поисковых систем о том, что другие ручаются за ваш контент.

Если многие сайты ссылаются на одну и ту же веб-страницу или веб-сайт, поисковые системы могут сделать вывод, что контент заслуживает ссылки и, следовательно, также стоит показывать в поисковой выдаче. Таким образом, получение этих обратных ссылок оказывает положительное влияние на позицию сайта в рейтинге или видимость в поисковой сети.В индустрии SEM специалисты очень часто определяют, откуда берутся эти обратные ссылки (от конкурентов), чтобы отсортировать лучшие из них и создать высококачественные обратные ссылки для своих клиентов.

Учитывая, что создание очень прибыльных обратных ссылок для компании занимает много времени (время + энергия + бюджет), позволяя вашим конкурентам так легко идентифицировать и дублировать их, это чистая потеря эффективности.

Better Robots.txt помогает блокировать все поисковые роботы (aHref, Majestic, Semrush), чтобы ваши обратные ссылки не обнаруживались.

4. Избегайте спама обратных ссылок

Боты, заполняющие формы комментариев на вашем веб-сайте, говорят вам «отличная статья», «нравится информация», «надеются, что вы скоро сможете подробнее рассказать о теме» или даже предоставляют персональные комментарии, в том числе имя автора. Спам-боты со временем становятся все более и более умными, и, к сожалению, ссылки для спама в комментариях могут действительно повредить вашему профилю обратных ссылок. Улучшенный файл Robots.txt поможет избежать индексации этих комментариев поисковыми системами.

5.SEO инструменты

При улучшении нашего плагина мы добавили ссылки на 2 очень важных инструмента (если вас беспокоит ваш рейтинг в поисковых системах): Google Search Console и Bing Webmaster Tool. Если вы еще не используете их, теперь вы можете управлять индексированием своего сайта, оптимизируя robots.txt! Также был добавлен прямой доступ к инструменту массового пинга, который позволяет пинговать свои ссылки в более чем 70 поисковых системах.

Мы также создали 4 ярлыка, относящиеся к лучшим онлайн-инструментам SEO, непосредственно доступным на Better Robots.txt SEO PRO. Так что теперь, когда вы захотите, вы можете проверить производительность загрузки вашего сайта, проанализировать свой SEO-рейтинг, определить свой текущий рейтинг в поисковой выдаче с помощью ключевых слов и трафика и даже просканировать весь сайт на наличие мертвых ссылок (ошибки 404, 503, …) Прямо из плагина.

6. Будьте уникальны

Мы подумали, что можем добавить нотку оригинальности в Better Robots.txt, добавив функцию, позволяющую «настраивать» ваш файл robots.txt WordPress с помощью собственной уникальной «подписи».«Большинство крупных компаний в мире персонализировали свой robots.txt, добавив пословицы (https://www.yelp.com/robots.txt), слоганы (https://www.youtube.com/robots.txt) или даже рисунки (https://store.nike.com/robots.txt — внизу). И почему не ты тоже? Вот почему мы выделили специальную область на странице настроек, где вы можете писать или рисовать все, что хотите (действительно), не влияя на эффективность работы robots.txt.

7. Запретить роботам сканировать бесполезные ссылки WooCommerce

Мы добавили уникальную функцию, позволяющую блокировать определенные ссылки («добавить в корзину», «заказать», «заполнить», корзину, учетную запись, оформить заказ и т. Д.) От сканирования поисковыми системами.Большинство этих ссылок требуют значительного использования ЦП, памяти и полосы пропускания (на хост-сервере), поскольку они не кэшируются и / или создают «бесконечные» циклы сканирования (пока они бесполезны). Оптимизация вашего файла robots.txt в WordPress для WooCommerce при наличии интернет-магазина позволяет повысить вычислительную мощность для действительно важных страниц и повысить производительность загрузки.

8. Избегайте ловушек на гусеничном ходу:

«Ловушки поискового робота» — это структурная проблема внутри веб-сайта, которая заставляет сканеры находить практически бесконечное количество нерелевантных URL-адресов.Теоретически сканеры могут застрять в одной части веб-сайта и никогда не завершить сканирование этих нерелевантных URL-адресов. Улучшенный файл Robots.txt помогает предотвратить ловушки сканера, которые сокращают бюджет сканирования и вызывают дублирование контента.

9. Инструменты взлома роста

Сегодня самые быстрорастущие компании, такие как Amazon, Airbnb и Facebook, добились резкого роста, объединив свои команды вокруг высокоскоростного процесса тестирования / обучения. Речь идет о взломе роста. Взлом роста — это процесс быстрого экспериментирования и реализации маркетинговых и рекламных стратегий, которые направлены исключительно на эффективный и быстрый рост бизнеса.Better Robots.txt предоставляет список из 150+ инструментов, доступных в Интернете, чтобы ускорить ваш рост.

10. Robots.txt Post Meta Box для ручных исключений

Этот мета-блок сообщения позволяет установить «вручную», должна ли страница быть видимой (или нет) в поисковых системах, путем внедрения специального правила «запретить» + «noindex» в ваш файл robots.txt WordPress. Почему это полезно для вашего рейтинга в поисковых системах? Просто потому, что некоторые страницы не предназначены для сканирования / индексации. Страницы с благодарностью, целевые страницы, страницы, содержащие исключительно формы, полезны для посетителей, но не для поисковых роботов, и вам не нужно, чтобы они отображались в поисковых системах.Кроме того, некоторые страницы, содержащие динамические календари (для онлайн-бронирования), НИКОГДА не должны быть доступны для поисковых роботов, поскольку они имеют тенденцию заманивать их в бесконечные циклы сканирования, что напрямую влияет на ваш бюджет сканирования (и ваш рейтинг).

11. Возможность сканирования Ads.txt и App-ads.txt

Чтобы гарантировать, что ads.txt и app-ads.txt могут сканироваться поисковыми системами, плагин Better Robots.txt гарантирует, что они по умолчанию разрешены в файле Robots.txt независимо от вашей конфигурации.Для вашей информации, авторизованные цифровые продавцы для Интернета или ads.txt — это инициатива IAB, направленная на повышение прозрачности программной рекламы. Вы можете создать свои собственные файлы ads.txt, чтобы определить, кто имеет право продавать ваши ресурсы. Файлы являются общедоступными и могут сканироваться биржами, платформами поставщиков (SSP) и другими покупателями и сторонними поставщиками. Авторизованные продавцы для приложений или app-ads.txt — это расширение стандарта авторизованных цифровых продавцов. Он расширяет совместимость для поддержки рекламы, отображаемой в мобильных приложениях.

Как всегда, еще впереди…

.Virtual Robots.txt — плагин для WordPress

Virtual Robots.txt — это простое (то есть автоматизированное) решение для создания и управления файлом robots.txt для вашего сайта. Вместо того, чтобы возиться с FTP, файлами, разрешениями и т. Д., Просто загрузите и активируйте плагин, и все готово.

По умолчанию плагин Virtual Robots.txt разрешает доступ к тем частям WordPress, которые нужны хорошим ботам, таким как Google. Остальные части заблокированы.

Если плагин обнаруживает существующий файл карты сайта XML, ссылка на него будет автоматически добавлена в ваш файл robots.txt файл.

- Загрузите папку pc-robotstxt в каталог

/ wp-content / plugins / - Активируйте плагин через меню «Плагины» в WordPress

- После установки и активации плагина вы увидите новую ссылку меню Robots.txt в меню настроек. Щелкните эту ссылку меню, чтобы увидеть страницу настроек плагина. Оттуда вы можете редактировать содержимое вашего файла robots.txt.

Будет ли он конфликтовать с существующим robots.txt файл?

Если на вашем сайте существует физический файл robots.txt, WordPress не будет обрабатывать его запросы, поэтому конфликта не будет.

Будет ли это работать для установки WordPress в подпапках?

Из коробки, нет. Поскольку WordPress находится в подпапке, он не «узнает», когда кто-то запрашивает файл robots.txt, который должен находиться в корне сайта.

Изменяет ли этот плагин отдельные сообщения, страницы или категории?

Нет, не так.

Почему плагин по умолчанию блокирует определенные файлы и папки?

По умолчанию виртуальный файл robots.txt настроен на блокировку файлов и папок WordPress, к которым не требуется доступ поисковых систем. Конечно, если вы не согласны со значениями по умолчанию, вы можете легко их изменить.

Прекрасно работает, прост в использовании и настройке. Он уже установил по умолчанию каталоги, которые нужно исключить из сканирования / индексации поисковыми системами… Очень им доволен!

То, что я увидел, было не тем, что я получил. XML-карта сайта не была включена в файл robots.txt, хотя это было описано как функция, которая должна работать из коробки. Кроме того, при установке этого плагина он без запроса блокировал определенные каталоги. Наконец, он вставляет строку вверху файла, продвигая плагин. Это должна быть дополнительная функция, которую пользователи могут отключить.В целом, он предлагает функциональность, но не хватает и разочаровывает в других областях.

Я думал, это будет просто. Конечно, звучит просто. Но после того, как я сохранил предложенный вами текст в моем новом «виртуальном robots.txt», я щелкнул ссылку, где говорится: «Вы можете предварительно просмотреть свой файл robots.txt здесь (открывается в новом окне). Если ваш файл robots.txt этого не делает» t соответствует тому, что показано ниже, у вас может быть физический файл, который отображается вместо этого.» В этом новом окне отображается текст, который действительно отличается от текста плагина. Я понимаю, что это означает, что на моем сервере есть физический файл robots.txt. Итак, какой из них на самом деле будет использоваться? Ваш FAQ предлагает следующее: В: Будет ли он конфликтовать с существующим файлом robots.txt? О: Если на вашем сайте существует физический файл robots.txt, WordPress не будет обрабатывать для него запросы, поэтому конфликта не будет. Если физический файл существует, WP не будет обрабатывать НИКАКИХ запросов на него? Эти ЗВУКИ, такие как WP, будут игнорировать как физический файл, так и ваш виртуальный.В таком случае в чем смысл? Мне кажется, может и не быть. Когда я вручную перехожу на mydomain.com/robots.txt, я вижу, что находится в физическом файле, а не то, что сохранил плагин. Итак … это работает? Я не знаю! Следует ли мне удалить физический файл и предположить, что виртуальный будет работать? Я не знаю! Следует ли мне удалить этот плагин и отредактировать физический файл вручную? Наверняка. 2 звезды вместо 1, потому что я ценю возможность включения предложенных строк в мой файл.

Мне нравится, что он такой чистый.Спасибо за создание!

Awesome, простое решение распространенной проблемы (менеджеры контента сайтов, которые хотят скрыть определенные страницы из результатов поиска Google). Небольшое примечание: в моем случае существующий файл Sitemap, созданный плагином «Google (XML) Sitemaps Generator» Арне Браххолда, не был обнаружен.

Посмотреть все 8 отзывов«Virtual Robots.txt» — программное обеспечение с открытым исходным кодом. Следующие люди внесли свой вклад в этот плагин.

авторов1,9

- Fix для PHP 7. Спасибо SharmPRO.

1,8

- Отмена последних исправлений, так как они имели непредвиденные побочные эффекты.

1,7

- Дальнейшие исправления проблемы с удалением новой строки. Спасибо FAMC за отчет и исправление кода.

- После обновления посетите и повторно сохраните свои настройки и убедитесь, что они выглядят правильно.

1,6

- Исправлена ошибка, при которой удалялись новые строки.Спасибо FAMC за отчет.

1,5

- Исправлена ошибка, из-за которой плагин предполагал, что robots.txt будет находиться по адресу http, хотя он может находиться по адресу https. Спасибо jeffmcneill за сообщение.

1,4

- Исправлена ошибка ссылки на robots.txt, которая не настраивалась для установки подпапок WordPress.

- Обновлены директивы robots.txt по умолчанию в соответствии с последними практиками для WordPress.

- Разработка и поддержка плагина переданы Мариосу Александру.

1,3

- Теперь использует хук do_robots и проверяет is_robots () в действии плагина.

1,2

- Добавлена поддержка существующего файла sitemap.xml.gz.

1,1

- Добавлена ссылка на страницу настроек, возможность удаления настроек.

1.0

.php — Где находится robots.txt в WordPress

Переполнение стека- Около

- Товары

- Для команд

- Переполнение стека Общественные вопросы и ответы

- Переполнение стека для команд Где разработчики и технологи делятся частными знаниями с коллегами

- Вакансии Программирование и связанные с ним технические возможности карьерного роста

- Талант Нанимайте технических специалистов и создавайте свой бренд работодателя

- Реклама Обратитесь к разработчикам и технологам со всего мира

- О компании

Загрузка…

- Авторизоваться зарегистрироваться

текущее сообщество

WordPress Robots.txt — Где разместить и как оптимизировать

Глубокое понимание robot.txt будет иметь большое значение для улучшения SEO вашего сайта. В этом руководстве вы узнаете, что такое robot.txt, и, самое главное, научитесь его использовать.

По сути, robot.txt создан для роботов, которые, например, представляют собой программное обеспечение, которое просматривает веб-страницы и индексирует их для результатов поиска. Это позволяет владельцам веб-сайтов запрещать поисковым роботам сканировать определенные страницы или контент на своем веб-сайте.

Неправильное использование robot.txt может испортить SEO вашего сайта. Таким образом, его следует использовать с осторожностью. Но не волнуйтесь, все, что вам нужно узнать по этой теме, описано в этом руководстве.

В этой статье:

Что такое файл WordPress Robots.txt?

Содержимое файла robots.txt обычно выглядит следующим образом:

User-agent: *

Disallow: / wp-admin /

Allow: /wp-admin/admin-ajax.php

Disallow , в этом случае, сообщает поисковым роботам: «Эй, вам не разрешено сканировать папку wp-admin».И Позвольте, ну вы угадали.

Каждый день в Интернете публикуются тысячи новых веб-сайтов. Чтобы облегчить поиск этих веб-сайтов, Google и другие поисковые системы индексируют каждый веб-сайт. Учитывая огромный объем работы, Google полагается на своих поисковых ботов, чтобы быстро выполнить работу.

Когда поисковый робот приземляется на ваш сайт, он сначала изучает карту сайта в формате XML, чтобы узнать все содержащиеся в ней страницы.Затем бот переходит к сканированию и индексированию не только страниц веб-сайта, но и его содержимого, включая папку JS и CSS. Если это веб-сайт WordPress, бот также просканирует папку wp-admin . Вы точно не хотите, чтобы это произошло, и единственный способ остановить их — запретить им это в файле robots.txt .

Хотя создание файла robots.txt не является обязательным — так как поисковые боты будут сканировать ваш веб-сайт независимо от того, есть он у вас или нет, у него есть много преимуществ

Преимущества создания оптимизированного txt файла для роботов

Основная причина для создания роботов.txt предназначен для предотвращения сканирования роботами поисковых систем определенного содержания вашего сайта. Например, вы не хотите, чтобы пользователи имели доступ к папке темы и администратора, файлам плагинов и странице категорий вашего веб-сайта.

Кроме того, оптимизированный файл robots.txt помогает сохранить так называемую квоту сканирования. Квота сканирования — это максимально допустимое количество страниц, которые поисковые роботы веб-сайта могут сканировать за раз. Вы хотите убедиться, что сканируются только полезные страницы, иначе ваша квота на сканирование будет потрачена впустую.Это значительно улучшит SEO вашего сайта.

В-третьих, хорошо написанный файл robots.txt может помочь вам свести к минимуму активность поисковых роботов, в том числе плохих, вокруг вашего веб-сайта. Таким образом, скорость загрузки вашего сайта значительно улучшится.

Где находится файл Robots.txt?

По умолчанию файл robots.txt создается и сохраняется в корневом каталоге вашего веб-сайта всякий раз, когда вы устанавливаете веб-сайт WordPress. Чтобы просмотреть его, откройте свой веб-сайт в браузере и добавьте «/ robots.txt »в конце. Например:

https://mywebsite.com/robots.txt

Вот как выглядит наш в Fixrunner:

Файл robots.txt WordPress по умолчанию является виртуальным, поэтому к нему нельзя получить доступ и отредактировал. Чтобы получить к нему доступ или отредактировать, вам придется его создать — и есть много способов сделать это. Посмотрим на некоторые из них!

Как создать файл robots.txt в WordPress

Создание файла robots.txt в WordPress — простой процесс.Вы можете сделать это вручную или с помощью плагинов WordPress. Здесь мы увидим оба процесса, а плагин, который мы собираемся использовать, — это Yoast SEO.

Использование плагина Yoast SEO

Плагин Yoast SEO может создавать файл robot.txt для WordPress на лету. Конечно, когда дело доходит до SEO для WordPress, он делает гораздо больше.

Во-первых, установите и активируйте плагин, если у вас его еще нет.

После того, как Yoast будет запущен и запущен на своем веб-сайте, перейдите к SEO >> Инструменты

Затем щелкните ссылку Редактор файлов на панели инструментов Yoast.

Вы попадете на страницу, где можете создать файл robots.txt. Нажмите кнопку Create .

Откроется редактор, в котором вы сможете добавлять и редактировать правила в файле robots.txt вашего WordPress.

.