Узнать дубли главной страницы сайта | Найти дубли онлайн

03.12.2019 13:13

Добавили возможность сохранения галочки Google в чекере позиций

Нарастив ресурсы для съема позиций в Google, теперь мы можем дать возможность сохранять проекты с галочкой — https://be1.ru/s/kdx9o

28.11.2019 18:21

Дополнили функционалом инструмент по проверке позиций сайта

Добавилась возможность выбора домена и языка результата в проверке по Google.

12.08.2019 10:00

Разработали новый SEO-инструмент, определяющий частотность запросов!

Инструмент поможет определить базовые виды частотностей поисковых запросов, данные тянутся непосредственно из Яндекс Вордстат. Ссылка на инструмент: https://be1.ru/wordstat/

02.07.2019 12:00

Обновили дизайн старого инструмента!

Мы до неузнаваемости обновили инструмент определяющий IP адрес компьютера, теперь в нем куча плюшек и современный дизайн! Ссылка на инструмент: https://be1.ru/my-ip/

13.06.2019 14:34

Добавили новый SEO-инструмент!

Он умеет быстро и бесплатно определять систему управления контентом (CMS) сайта.

07.05.2019 10:05

Мы переехали на новый сервер!

В связи с невероятной популярностью проекта, нам стало слишком тесно на нашем сервере. Смена сервера даст более стабильную и быструю работу проекта. В ближайшие дни мы будем писать сотни строк кода по 20 часов в сутки, чтобы перенастроить наши скрипты под новый сервер. Просим понять, простить и помочь найти баги, сообщить о которых Вы можете в форме связи раздела FAQ.

26.03.2019 10:47

Падение сервера 25.03.18

Остановка в работе сервиса связанна c DDoS атакой, в данный момент работа Be1 полностью восстановлена. Будем укрепляться и ждать следующую волну. Извините за временные неудобства.

19.02.2019 10:00

Новое расширение для анализа сайтов!

Наше расширение помогает бесплатно в один клик провести глубокий SEO-анализ сайта. Рекомендуем: https://be1.ru/goto/extension

14.12.2017 12:07

Обновления для Антиплагиата!

Функциональность инструмента Антиплагиат обновилась — исчезла строка «Исключить URL». Теперь эта функция работает автоматически при использовании вкладки «Проверить URL». Также, первая проверка инструмента осуществляется намного быстрее. Однако, если Вы нацелены проверить всё до деталей, нажимайте кнопку «Расширенная проверка».

24.11.2017 14:26

Black Friday! 40% скидка на рекламу!

Успейте заказать рекламу с максимальной скидкой! Оформить заявку можно на странице https://be1.ru/advertising/

Ручная проверка сайта на дубли страниц. Как найти и удалить?

При поисковой оптимизации самое главное — не допустить ошибок. И самая распространенная ошибка — это большое количество дублей страниц. Сегодня мы расскажем, как убрать если не все, то 99% всех дублей с сайта простой ручной проверкой.

Что такое дубли страниц

Для начала давайте разберемся — что это такое и откуда они берутся?

Самый простой пример дубля — это домен третьего уровня www. Например, у нас есть сайт — site.ru. Как вы знаете, в браузере можно его вводить следующим образом — www.site.ru. По сути — оба этих варианта абсолютно идентичны, поэтому поисковые системы могут проиндексировать один из вариантов и в итоге при переходе, например, с Google — пользователи будут попадать на страницу www.site.ru, а при переходе с Яндекса — на страницу site.ru.

Почему от них надо избавляться

Есть две основных причины:

1. Внутренние и внешние ссылки.

Запомнить — какое именно зеркало (дубль) страницы используется — практически невозможно. Особенно если над сайтом работает не один человек, а несколько. В итоге, кто-то ссылается на страницу с www, кто-то без. В итоге — вес ссылок размывается и продвигать сайт становится сложнее. Кроме того — сами пользователи добавляют масла в огонь, оставляя ссылки в соцсетях и на форумах на разные дубли.

2. Скачки позиций в поиске

Из-за того, что ссылки ведут на разные зеркала — в поисковиках могут наблюдаться серьезные скачки позиций. Сначала Яндекс посчитает, что страница с www более релевантная, потом вдруг изменит решение и сделает релевантной страницу без www. Как итог — позиции могут сильно прыгать и трафик будет расти не равномерно.

Как удалить дубли страниц

Опять же, есть несколько способов убрать зеркала на сайте. Рассмотрим подробнее каждый из них:

1. 301 редирект

Этот способ чаще всего используется для технических зеркал. Срабатывает он следующим образом — пользователь попадает на сайт с www, а его автоматически перебрасывает на сайт без поддомена.

2. Запрет на индексацию в robots.txt

Используется для запрета индексации отдельных типов зеркал. Например — фильтров в интернет-магазинах, или поисковых страниц вида ?search=…

Для того, чтобы запретить индексацию — достаточно в файле robots.txt дописать строчку:

Disallow: /*?*search=

3. Атрибут rel=»canonical»

Аналогичен предыдущему варианту, но чаще всего используется в системах пагинации (например, просмотр предыдущей и следующей страниц в каталоге магазина). Подробнее об этом методе можно почитать на странице помощи Яндекса.

Попытаемся найти дубли страниц

Теперь, когда мы разобрались что это и как это исправить — найдем все возможные дубли на сайте. Просто добавляйте указанные значения к своему сайту и проверяйте, есть ли дубли. Если страница открывается так же, как и без параметра — значит это явное зеркало.

Примеры:

site.ru -> www.site.ru site.ru -> site.ru/ site.ru -> site.ru/index.php и т.д.

1. Дубли главной страницы

www / на конце /index.php /index.html /index.htm /index /index/ /home.php /home.html /home.htm /home /home/

2. Пагинация

Проверьте, добавлен ли атрибут rel="canonical" на страницах пагинации.

3. UTM-разметка и рекламные параметры:

Добавьте в robots.txt следующий код

Disallow: /*?*openstat= Disallow: /*?*yclid= Disallow: /*?*utm

4. На внутренних страницах сайта

/ на конце .php на конце

5. Страница поиска

Если хотите закрыть страницу поиска от индексации, введите запрос на своем сайте в поисковой форме и найдите параметр вида ?search=запрос. После этого внесите параметр «?search» в robots.txt вот так:

Disallow: /*?*search=

6. Фильтры и сортировка

Для интернет-магазинов и каталогов так же нужно убирать дубли фильтров и сортировок. Просто выберете любой фильтр на сайте и получите ссылку вида ?sort=price. Найдите параметр типа «?sort» и добавьте его в robots.txt следующим образом:

Disallow: /*?*sort

С ручной проверкой — закончено! Можете быть уверены, если вы проверите все вышеперечисленное — то уже избавитесь от большого количества дублей на сайте.

Обратите внимание! Если в индексе поисковиков было много зеркал, то после их удаления — сайт может временно «просесть» в позициях, так что лучше проводить чистку постепенно, чтобы дать возможность Яндексу и Гуглу постепенно переиндексировать сайт.

alferov.su

Как проверить сайт на дубли страниц

Добрый день, друзья! Уже очень давно меня просили читатели блога сделать пост о том, как избавиться от replytocom. Тема эта актуальна, так как из-за этого в индексе получается огромное число похожих страничек с параметрами коммента. Все дело в том, что многие блоги созданы на CMS WordPress, который грешит дубликацией комментариев. Поэтому я решил дать всю информацию не только о replytocom. В статье я раскрываю понятие дублированного контента, даю методику поиска дублей страниц сайта и поясняю, почему от них нужно избавляться. А в следующем посте я покажу, как нужно их удалять.

Добрый день, друзья! Уже очень давно меня просили читатели блога сделать пост о том, как избавиться от replytocom. Тема эта актуальна, так как из-за этого в индексе получается огромное число похожих страничек с параметрами коммента. Все дело в том, что многие блоги созданы на CMS WordPress, который грешит дубликацией комментариев. Поэтому я решил дать всю информацию не только о replytocom. В статье я раскрываю понятие дублированного контента, даю методику поиска дублей страниц сайта и поясняю, почему от них нужно избавляться. А в следующем посте я покажу, как нужно их удалять.

Дублированный контент на сайте

Дубли бывают разными — тихими и заразными. 🙂 Если серьезно, то дублированная страница — это документ сайта, который может иметь полностью или частично одинаковый контент. Разумеется, каждый дубль имеет свой адрес (url страницы). Четкий дубль страницы может возникнуть по следующим причинам:

- искусственно создаются владельцем сайта для специальных нужд. Например, страницы для печати, которые позволяют пользователю коммерческого сайта скопировать информацию по выбранному товару / услуге.

- генерируются движком ресурса, так как это у них заложено в теле. Некоторые современные CMS выдают похожие страницы с другими урлами, размещенные по своим разным дерикториям.

- появляются за счет ошибок веб-мастера, который управляет сайтом. Например, ресурс обзаводиться двумя одинаковыми главными страницами с разными адресами (например, site.ru и site.ru/index.php).

- возникают по случаю изменения структуры сайта. Например, при создании нового шаблона с другой системой урлов, новые страницы со старым контентом получают совершенно другие адреса.

Нечеткий дубль получают страницы, которые частично дублируют контент. Такие страницы имеют общую часть шаблона сайта, но отличаются небольшим контентным наполнением. Например, такими небольшими дублями могут быть страницы ресурса, имеющие результаты поиска или отдельные элементы статьи (например, картинки — такое очень часто бывает во многих шаблонах блогов).

На следующем рисунке я собрал самые частые варианты дублей страниц, которые присущие блогу с движком Вордпресс (без учета различных плагинов и фишек шаблона, которые также частенько создают дублированные документы):

Наличие дублей страниц на сайте может говорить о том, что или веб-мастер не знает об их присутствии, или он просто не умеет с ними бороться. А бороться с ними нужно, так как они приводят к различным ошибкам и проблемам в плане поискового продвижения. Об этом сейчас и поговорим.

Почему нужно удалять дубли страниц

Дублированные страницы — это не какой-то вирусняк или паразитирующий организм. Он конечно тоже плодиться, но не за счет себя или своих функций. То есть он плодиться не по своей воле. Дубли на самом деле — это результат неправильного кода сайта, итог огрехов веб-мастера или блоггера.

Но какими бы не были пассивными дубли страниц, они могут подложить конкретную свинью владельцу любого сайта или блога. Итак, чем же так опасен дублированный контент? Вот основные проблемы, которые возникают при наличии дублей:

Ухудшение индексации сайта. Я называю это проблемой №1. Дело в том, что в зависимости от источника и ошибок веб-мастера, страница сайта может иметь от одного до нескольких или больше дублей. Например, главная может грешить двумя-тремя дупликатами, а посты блогов из-за вездесущего replytocom скопируются по количеству комментариев. И если блог популярный, то и число «левых» страниц будет огромным. А поисковые системы (особенно Google) не любят дубли и поэтому частенько занижают позиции самого сайта.

Замена релевантной страницы. Алгоритм поисковой системы может посчитать дубль более релевантным, чем продвигаемая страница-оригинал (моя статья о понятии релевантности). Тем самым в выдаче будет находиться не целевая страница, а ее клон. Но у этого клона совсем другие незначительные параметры (ссылочный вес, метрики посещаемости), которые со временем пессимизируют сайт в серпе поисковой системы.

Бесполезность естественных ссылок. Представьте себе картину — на Ваш сайт пришел посетитель. Ему понравился Ваш контент и он решился поделиться с друзьями полезным адресом понравившейся страницы. А эта страница — дубль оригинала. В итоге ссылку получит дублированный контент, а не наш реальный документ. Таким образом мы просто теряем настоящую естественную ссылку.

Итак, подытожим вышесказанное. Дубли страниц создают помеху в нормальной индексации сайта, становятся источником неправильного выбора поисковиком релевантной страницы, забирают влияние естественных внешних ссылок. Также дубли неправильно распределяют внутренний ссылочный вес, отбирая силу у продвигаемых страниц и меняя поведенческие показатели:

В общем, дубли — это большое зло в поисковом продвижении и страшный сон оптимизатора. 🙂

Как определить и проверить дубли страниц

Есть разные способы поиска и проверки дублей страниц. Они требуют разного уровня знаний CMS и понимание работы поискового индекса. Я покажу самый простой из способов. Это не значит, что если он простой, то не точный. С его помощью легко находятся дубликаты документов сайта. И самое главное — этот способ не требует особых знаний и не займет много времени.

Для того, чтобы найти и проверить свой сайт на наличие дубликатов страниц, нужно или воспользоваться расширенным поиском Яндекса (Гугла) или сразу ввести в поисковую строку специальный запрос. Сначала рассмотрим первый вариант.

Проверка сайта на дубли с помощью расширенного поиска

Расширенный поиск Яндекса позволяет получить более точную выдачу благодаря уточняющим параметрам запроса. В нашем случае нам нужно только два параметра — адрес сайта и кусочек текста той страницы, по которой мы ищем дубли. Сначала мы выделяем текст, который находится на той странице нашего сайта (для примера взят абсолютно чужой ресурс), которую будем проверять на дубли. Затем идет в расширенный поиск Яндекса и вносим в соответствующие позиции кусочек контента и адрес сайта:

Далее мы нажимаем заветное слово «Найти» и русский поисковик начинает формировать выдачу. Она получится не той, которую мы обычно наблюдаем — она будет состоять полностью из заголовков и сниппетов только нашего ресурса. Причем, если в выдаче будет только один результат поиска, то все хорошо — дублированного контента этой страницы нет. Если же есть в полученном серпе несколько результатов, то придется доставать лопату:

В моем примере поисковик нашел несколько нечетких дублей — ряд страниц из пагинации по некоторым рубрикам. Сразу видно, что на данном сайте страница с выделенным текстом про рецепт салата явно размещалась сразу в разных рубриках. А так как запрет на индексацию страниц пагинации для этого ресурса не ставился, в индексе повылазили всевозможные дубли.

Теперь рассмотрим те же действия для зарубежного поисковика. Заходим на страницу расширенного поиска Google и совершаем те же самые действия:

Заполнив все необходимое на расширенном поиске, получаем индексацию исследуемого сайта согласно указанному куску текста:

Как видим, Гугл также проиндексировал неточные дубли исследуемой страницы — в выдаче все те же страницы рубрик.

В принципе получить те же самые результаты можно и не используя расширенный поиск. Для этого нужно в простом варианте Гугла или Яндекса прописать следующий запрос. И в этом заключается второй способ определения дублей.

Поиск дублей страниц с помощью специального запроса

С помощью расширенного поиска легко находятся все дубликаты по заданному тексту. Конечно, с помощью данного способа мы не получим дубли страниц, которые не содержат текст. Например, если дубль создается «кривым» шаблоном, который зачем-то показывает на другой странице картинку, которая находится на странице-оригинале. То такой дубликат выше описанным способом найти не получиться. В таком случае придется использовать другой способ.

Его суть проста — с помощью специального оператора мы запрашиваем индексацию всего нашего сайта (или отдельной страницы) и уже вручную смотрим выдачу в поисках дубликаторов. Вот правила синтаксиса этого запроса:

Когда мы в запросе указываем адрес главной страницы,то получаем просто список проиндексированных страниц поисковым роботом. Если же мы указывает адрес конкретной страницы, то получаем список проиндексированных дублей этой страницы. В Яндексе они сразу видны. А вот в Гугле все немного сложнее — сначала нам покажут те страницы, которые есть в основной выдаче:

Как видно на картинке, в основной выдаче у нас находится одна страница сайта и она же является оригиналом. Но в индексе есть и другие страницы, которые являются дублями. Чтобы их увидеть, нужно нажать на ссылку «Показать скрытые результаты»:

В итоге нам выдается список дублей, которые Гугл проиндексировал и связал со страницей-оригиналом (цифра 1 на картинке). В моем примере такими дублями стали страницы с позициями 2 и 3.

На второй позиции находится дубль, который является трекбэком данного документа (автоматическое уведомление для других сайтов данной публикации). Вещь конечно нужная, но ее присутствие в индексе не желательно. Хозяин данного сайта это прекрасно понимает и поэтому прописал запрет на индексацию трэкбеков с сайта. Об этом говорит надпись «Описание веб-страницы недоступно из-за ограничений в файле robots.txt». Если посмотреть инструкцию для поисковых систем (robots.txt), то увидим следующую картину:

Благодаря последним директивам, автор сайта указал на запрет индексации трэкбеков. Но к сожалению, Гугл заносит в свой индекс все, что ему попадется под руку. И здесь уже нужно просто удалять дубли из базы данных. об этом поговорим уже во второй статье, посвященной дублированному контенту.

На третьей позиции показан горячо любимый многими блоггерами replytocom. Он получается путем использования комментирования на блогах и сайтах. И благодаря ему возникает просто огромная куча дублей — обычно это количество примерно равно число комментов на ресурсе. В нашем примере этот атрибут, как и трэкбек закрыты для индексации. Но Гугл и его схавал в свой индекс. Тоже нужно чистить вручную.

Кстати, если мы немного изменим наш запрос, то можем получить те же результаты, что дает расширенный поиск дублей по кусочку текста:

Итак, друзья, в этой статье я приоткрыл занавес над понятием дублей страниц и их успешным поиском и проверкой. В качестве закрепления пройденного материала предлагаю посмотреть мой видеоролик на эту тему. В нем я наглядно показал не только сегодняшний материал в двух частях, но и добавил другие примеры дублированного контента:

В следующей статье Вы узнаете, как можно убрать дубли страниц. До встречи!

С уважением, Ваш Максим Довженко

maksimdovzhenko.ru

ComparseR проверит сайт на дубли страниц

Дубли страниц ресурса – это доступность одной или нескольких страниц сайта по разным адресам. Нахождение и удаление дублей является одним из первоочередных действий SEO-оптимизатора при продвижении сайта. Подобное действие архиважное, поскольку наличие дублей страниц делает сайт неуникальным, а это значит, что поисковые системы рано или поздно пессимизируют его, как следствие, раскрутка станет временно невозможной. Рекомендуем воспользоваться специальной SEO программой для поиска дублей страниц сайта «ComparseR». Описание программы, видеообзор и ссылка на скачивание внизу этой страницы.

Полные и неполные дубли страниц сайта

Различают полные и неполные дубли страниц. Полный дубль – это 100% повторение одной страницы содержания другой. На неполных дублях материал повторяется частично: к ним относится дублирование анонсов новостей в ленте сайта, сквозные пункты меню и так далее.

Самое главное правило – не допустить индексации дублей страниц. Однако зачастую SEO-специалисты обнаруживают дубли страниц непосредственно в процессе продвижения.

Основные причины появления дублей страниц:

- присутствие параметров в URL-адресах страниц;

- адреса сайта с приставкой «www» и без нее не склеены и доступны в двух вариантах;

- не склеены адреса страниц без слеша на конце и с ним.

Для того чтобы проверить сайт на дубли страниц, нужно взять любой сайт, например, ваш_сайт_ру со слешем на конце, и перейти по нему, затем ввести его же, только без слеша в конце. Если браузер открывает страницу со слешем и во втором случае, то эт

xn--c1adanapngcb0ao4b.xn--p1ai

Как проверить сайт на дубли страниц? Основные способы

Доброго времени суток!

Доброго времени суток!

Дубликаты страниц, или дубли — одна из тех проблем, о которой не подозревают многие вебмастера. Из-за такой ошибки, некоторые полезные WordPress-блоги теряют позиции по ряду запросов, и порою их владельцы даже не догадываются об этом. Каждый видит в статистике, что посещаемость веб-страницы упала, но разыскать и исправить ошибку могут не все. В этой статье пойдет речь о том, как найти дубли страниц сайта.

Что такое дубликаты страниц?

Дубли – это две и больше страниц с одинаковым контентом, но разными адресами. Существует понятие полных и частичных дублей. Если полные — это стопроцентный дублированный контент исходной (канонической) страницы, то частичным дублем может стать страница, повторяющая ее отдельные элементы. Причины появления дублей могут быть разными. Это могут быть ошибки вебмастера при составлении или изменении шаблона сайта. Но чаще всего дубли возникают автоматически из-за специфики работы движков, таких как WordPress и Joomla. О том, почему это происходит, и как с этим справляться я расскажу ниже. Очень важно понимать, что вебсайты с такими повторениями могут попасть под фильтры поисковых систем и понижаться в выдаче, поэтому дублей стоит избегать.

Как проверить сайт на дубли страниц?

Практика показывает, что отечественный поисковик Яндекс относится к дублям не так строго, как зарубежный Гугл. Однако и он не оставляет такие ошибки вебмастеров без внимания, поэтому для начала нужно разобраться с тем, как найти дубликаты страниц.

Во-первых, нам нужно определить, какое количество страниц нашего сайта находится в индексе поисковых систем. Для этого воспользуемся функцией site:my-site.ru, где вместо my-site.ru вам нужно подставить свой url. Покажу, как это работает на примере своего блога. Начнем с Яндекса. Вводим в строку поиска site:pro-wordpress.ru

Как видим, Яндекс нашел 196 проиндексированных страниц. Теперь проделаем то же самое с Google.

Мы получили 1400 страниц в общем индексе Гугл. Кроме основных страниц, участвующих в ранжировании, сюда попадают так называемые «сопли». Это дубли, либо малозначимые страницы. Чтобы проверить основной индекс в Google, нужно ввести другой оператор: site:pro-wordpress.ru/&

Итого в основном индексе 165 страниц. Как видим, у моего блога есть проблема с количеством дублей. Чтобы их увидеть, нужно перейти на последнюю страницу общей выдачи и нажать «показать скрытые результаты».

Снова перейдя в конец выдачи, вы увидите примерно такое:

Это и есть те самые дубли, в данном случае replycom. Такой тип дублей в WordPress создается при появлении комментариев на странице. Есть множество разных видов дублей, их названия и способы борьбы с ними, будут описаны в следующей статье.

Наверняка у вас возник вопрос, почему в Яндексе мы не увидели такого количества дублей, как в Google. Все дело в том, что в файле robots.txt (кто не знает что это, читайте «Правильный robots.txt для WordPress») на блоге стоит запрет на индексацию подобных дублей с помощью директивы Disallow (подробнее об этом в следующем посте). Для Яндекса этого достаточно, но Гугл работает по своим алгоритмам и все равно учитывает эти страницы. Но их контент он не показывает, говорит, что «Описание веб-страницы недоступно из-за ограничений в файле robots.txt».

Проверка на дубли страниц по отрывку текста, по категориям дублей

Кроме вышеописанного способа, вы можете проверять отдельные страницы сайта на наличие дублей. Для этого в окне поиска Яндекс и Google, можно указать отрывок текста страницы, после которого употребить все тот же site:my-site.ru. Например, такой текст с одной из моих страничек: «Eye Dropper — это дополнение позволяет быстро узнать цвет элемента, чем-то напоминает пипетку в Photoshop». Его вставляем в поиск Гугл, а после через пробел site:my-site

Google не нашел дублей это страницы. Для Яндекса проделываем то же самое, только текст страницы берем в кавычки «».

Кроме фрагментов текста, вы можете вставлять ключевые фразы, по которым, к примеру, у вас снизились позиции.

Есть другой вариант такой же проверки через расширенный поиск. Для Яндекса — yandex.ru/advanced.html.

Вводим тот же текст, url сайта и жмем «Найти». Получим такой же результат, как и с оператором site:my-site.

Либо такой поиск можно осуществить, нажав кнопку настроек в правой части окна Яндекс.

Для Гугла есть такая же функция расширенного поиска.

Теперь посмотрим, как можно выявить группу дублей одной категории. Возьмем, к примеру, группу tag.

И увидим на странице выдачи по данному запросу следующее:

А если попросить Гугл вывести скрытые результаты, дублей группы tag станет больше.

Как вы успели заметить, дубликатов страниц создается очень много и наша задача – предотвратить их попадание в индекс поисковиков.

Поиск дублей страниц сайта: дополнительные способы

Кроме ручных способов, есть также возможность автоматически проверить сайт на дубли страниц.

Например, это программа Xenu, предназначенная для технического аудита сайта. Кроме дубликатов страниц, она выявляет битые ссылки. Это не единственная программа для решения таких задач, но наиболее распространенная.

Также в поиске дублей страниц помогает Google Webmaster, здесь можно выявить страницы с повторяющимися мета-тегами:

Тут вы посмотрите список урлов с одинаковыми тайтлами или описанием. Часть из них может оказаться дублями.

На сегодня все. Теперь вы знаете, как найти дубликаты страниц. В следующей статье мы подробно разберем, как предотвратить их появление и удалить имеющиеся дубли.

pro-wordpress.ru

Поиск дубликатов на сайте — Smart SEO Auditor.

В этой статье Вы узнаете о вреде дубликатов для поисковой оптимизации сайтов, о видах дубликатов, причинах появления и о способах их поиска на сайте.

Чем опасны дубликаты на сайте?

Одна из возможных причин потери позиций в поиске – это дубликаты страниц на веб-сайте. Эта проблема может затронуть как небольшие сайты, так и крупные веб-порталы. Можно выделить два типа дубликатов:

- полные дубликаты – это страницы на сайте, которые имеют разные адреса и одинаковое содержимое (контент),

- частичные дубликаты — это страницы на сайте, которые имеют разные адреса и частично повторяющийся контент.

Дубли на сайте могут появиться как по вине веб-мастера, так и по другим причинам. На пример, из-за особенностей системы управления сайтом (CMS). В любом случае – с дублями необходимо бороться. Полные дубли – это совсем недопустимо, так как они приводят к санкциям со стороны поисковых систем (Google, Yandex). Частичные дубли – могут привести как к санкциям, так и к конкуренции страниц сайта между собой в результатах поиска.

Поиск дубликатов заголовков, описаний и h2.

После завершения сканирования сайта перейдите на вкладку «Заголовок, описание, h2, h3».

В нижнем правом углу Вы видите количество повторяющихся заголовков (Title), описаний (Description), h2. В нашем примере повторяющихся заголовков 62, описаний — 0, h2 – 2. В идеале все три значения должны быть равны нулю.

Если у двух страниц повторяются Title, Description и h2 – то, скорее всего, мы имеем дело с полными дублями.

Это очень тревожный сигнал для SEO специалиста.

Частичные дубли также вредны. На пример, две страницы имеют одинаковый заголовок Title. Это значит, что обе страницы

будут конкурировать между собой в результатах поиска. Выиграть может совсем не та страница, на которую Вы делаете ставку.

Очень часто обе страницы могут проиграть из-за повторения Title. Прописав двум страницам одинаковый Title, веб-мастер,

фактически, запутывает поисковую систему. Такого нужно избегать.

Каждая страница должна иметь уникальный Title, Description и h2.

В таблице на против каждой строки, которая повторяется, имеется красный значок. Если Вы, на пример, хотите проанализировать дубли по Title – отсортируйте столбец «Заголовок (Title)» кликом мышки. Таким образом вы сможете легко увидеть перечень страниц с повторяющимися Title и, за одно, проверить, не повторяются ли у них Description и h2.

Вместо вывода.

Ваша задача как оптимизатора, или владельца сайта, добиться, чтобы дублей не было совсем. Дубли, как частичные, так и полные, утяжеляют сайт, не дают ему возможности попасть в ТОП 10. Многие недооценивают проблему дублей. Как показал опыт сканирования различных сайтов программой Smart SEO Auditor – проблема дубликатов актуальна даже для больших и уважаемых веб-порталов, интернет магазинов и прочих ресурсов. Так что, устанавливайте программу Smart SEO Auditor на Ваш компьютер, сканируйте сайт и исправляйте ошибки. Исправив одну ошибку, Вы немного улучшите поисковую оптимизацию сайта. Исправив десятки ошибок, Вы заметно улучшите оптимизацию веб-сайта.

smart-seo-tool.ru

Дубликаты страниц на сайте и их поиск: чем вредны дубли и как от них избавиться

При анализе сайта на предмет технических ошибок мы часто сталкиваемся с такой проблемой, как дубликаты страниц. Давайте подробнее разберемся, что это такое, какие виды дубликатов существуют, как их выявить и избавиться.

При анализе сайта на предмет технических ошибок мы часто сталкиваемся с такой проблемой, как дубликаты страниц. Давайте подробнее разберемся, что это такое, какие виды дубликатов существуют, как их выявить и избавиться.Примечание: если вы знаете что такое дубли страниц и чем они вредны для продвижения, можно сразу перейти в четвертый раздел «Как выявить дубли страниц».

Разберем общее понятие:

Дубликаты страниц — это полная или частичная копия основной веб-страницы на сайте, которая участвует в продвижении. Как правило копия находится на отдельном URL-адресе.

Чем вредны дубликаты страниц при продвижении сайта?

Многие владельцы сайтов даже не подозревают о том, что на сайте может присутствовать большое количество дубликатов, наличие которых плохо сказывается на общем ранжировании сайта. Поисковые системы воспринимают данные документы как отдельные, поэтому контент страницы перестает быть уникальным, тем самым снижается ссылочный вес страницы.

Наличие небольшого количества дублей страниц не будет являться большой проблемой для сайта. Но если их число зашкаливает, то от них необходимо избавляться в срочном порядке.

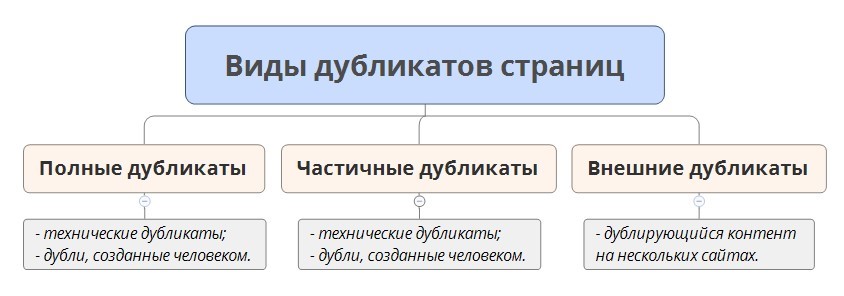

Виды дубликатов страниц

Существуют различные виды дубликатов страниц, самые распространенные из них представлены в рисунке 1:

Рис. 1. Виды дубликатов страниц

Разберем подробнее представленные виды дублей страниц.

Полные дубликаты страниц — полное дублирование контента веб-документа, различия только в URL-адресе.

Частичные дубликаты страниц — частичное дублирование контента веб-документов, когда дублируется наполнение сайта с небольшими различиями. Например, большие фрагменты текстов дублируются на нескольких страницах сайта — это уже частичные дубликаты или похожие карточки товаров, которые отличаются только одной незначительной характеристикой.

Внешние дубликаты страниц — полное или частичное дублирование контента на разных сайтах.

Технические дубликаты — это дубликаты, которые генерируются автоматически из-за неправильных настроек системы управления сайтом.

Дубликаты, созданные человеком — это дубликаты страниц, которые были созданы по невнимательности самим вебмастером.

Как выявить дубли страниц?

Способов обнаружить дубликаты страниц — множество. В данной статье рассмотрим несколько основных методов, которые используются в работе чаще всего.

1. Парсинг сайта в сервисе

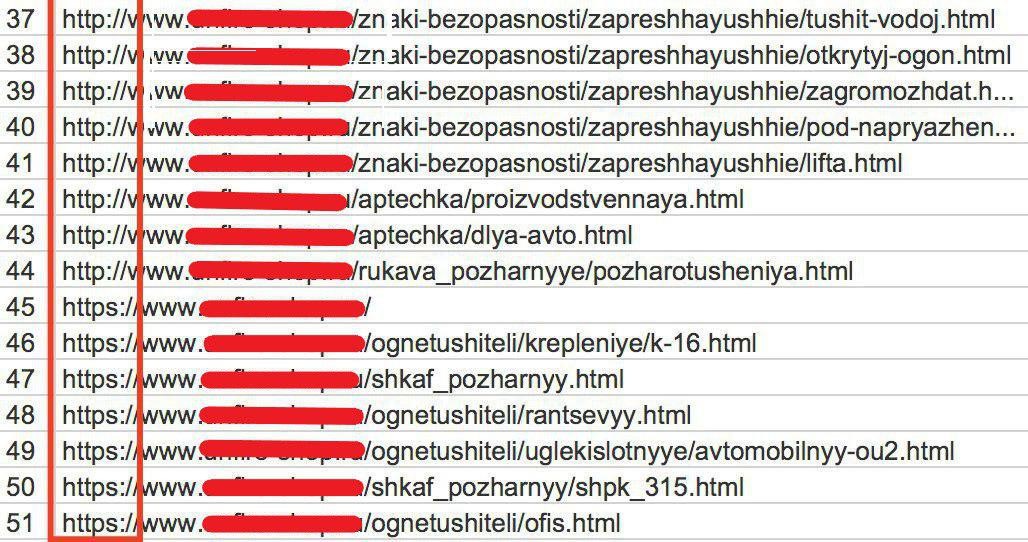

При парсинге сайта в каком-либо сервисе (в последнее время чаще всего используют сервис Screaming Frog) наглядно можно увидеть страницы-дубликаты.

К примеру, когда не склеены зеркала либо у страниц есть какие-то параметры, которые добавляются автоматически при отслеживании эффективности рекламных кампаний и др.

Рис. 2. Пример парсинга сайта в сервисе Screaming Frog при не склеенных зеркалах

Небольшой лайфхак для работы с сервисом Screaming Frog: если у сайта огромное количеством страниц, и вы сразу заметили, что зеркала не склеены и поставили проект на парсинг, естественно процесс замедлится и уменьшит скорость работы вашей системы (если у вашего ПК, конечно, не мощные системные характеристики).

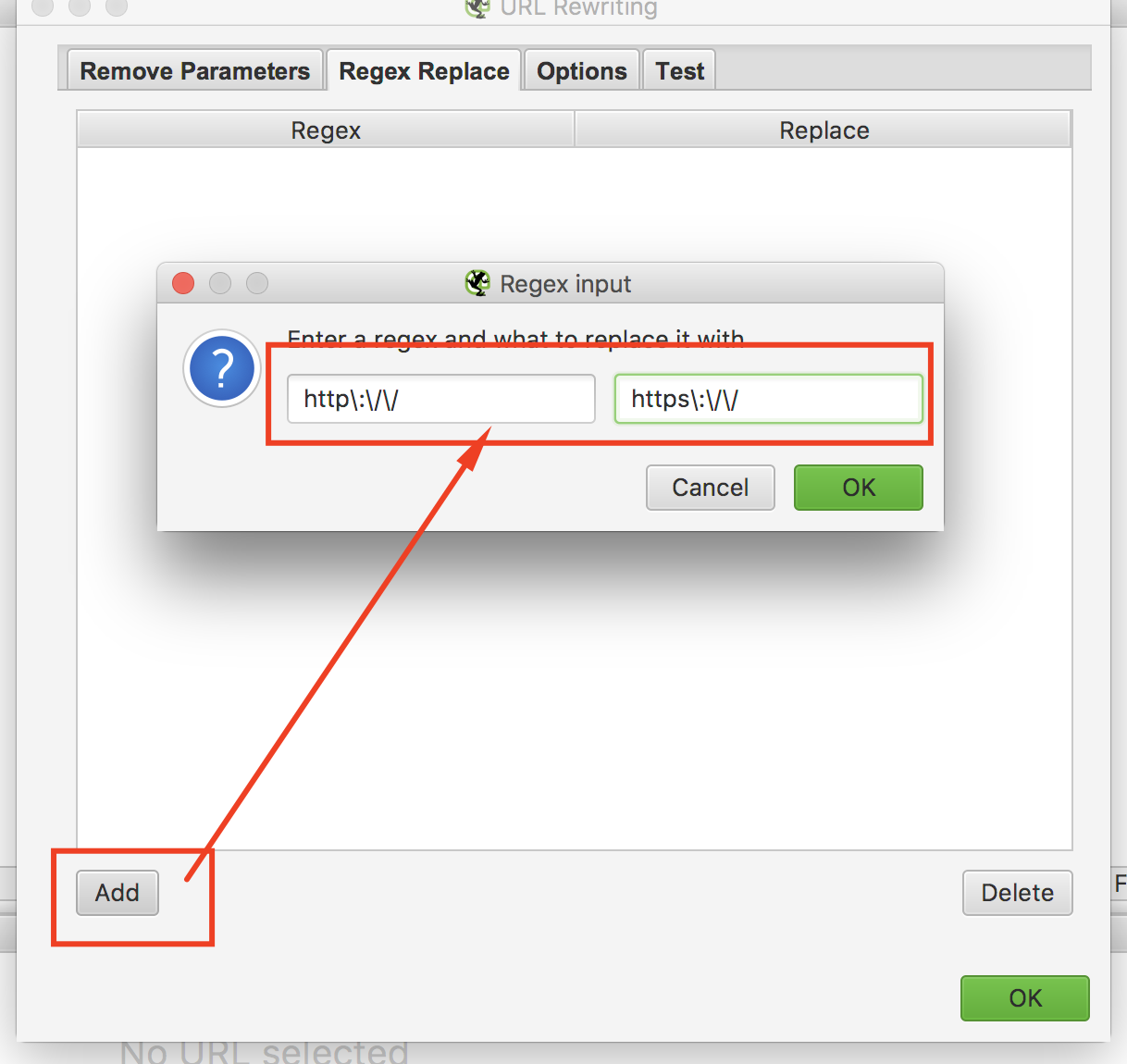

Чтобы этого избежать можно использовать функцию Configuration – URL Rewriting – Regex Replace.

В вкладке Regex Replace создаем следующее правило (используя регулярное выражение, «говорим» сервису, как нужно склеивать зеркала, чтобы он выводил только страницы с HTTPS):

Рис. 3. Скриншот из сервиса Screaming Frog — Использование функции URL Rewriting

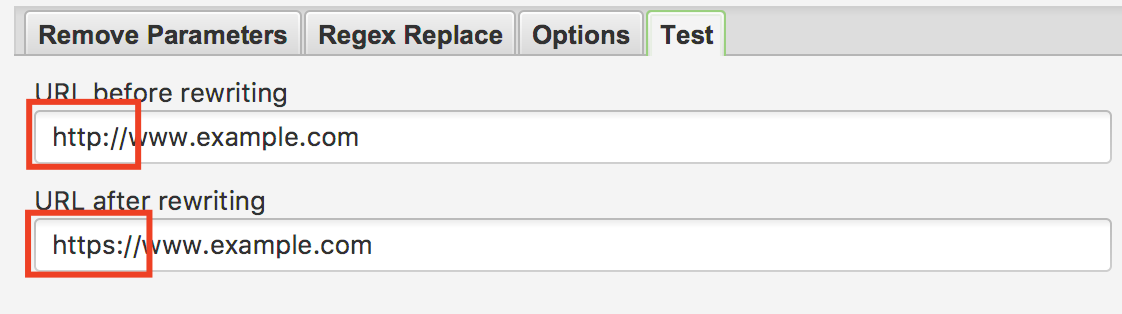

Далее нажимаем кнопку «ОК» и переходим во вкладку «Test». В данной вкладке сервис вам покажет, правильно ли вы задали правило и как будут склеиваться зеркала. В нашем случаем должен выходить такой результат:

Рис. 4. Скриншот из сервиса Screaming Frog — Использование функции Test

Таким же способом можно склеивать страницы с «www» и без «www», а также задавать различные параметры, чтобы не выводить ненужные страницы (например, страницы пагинации).

После всех операций спокойно запускаем парсинг сайта без дополнительной нагрузки на систему.

2. Использование панели Яндекс.Вебмастер

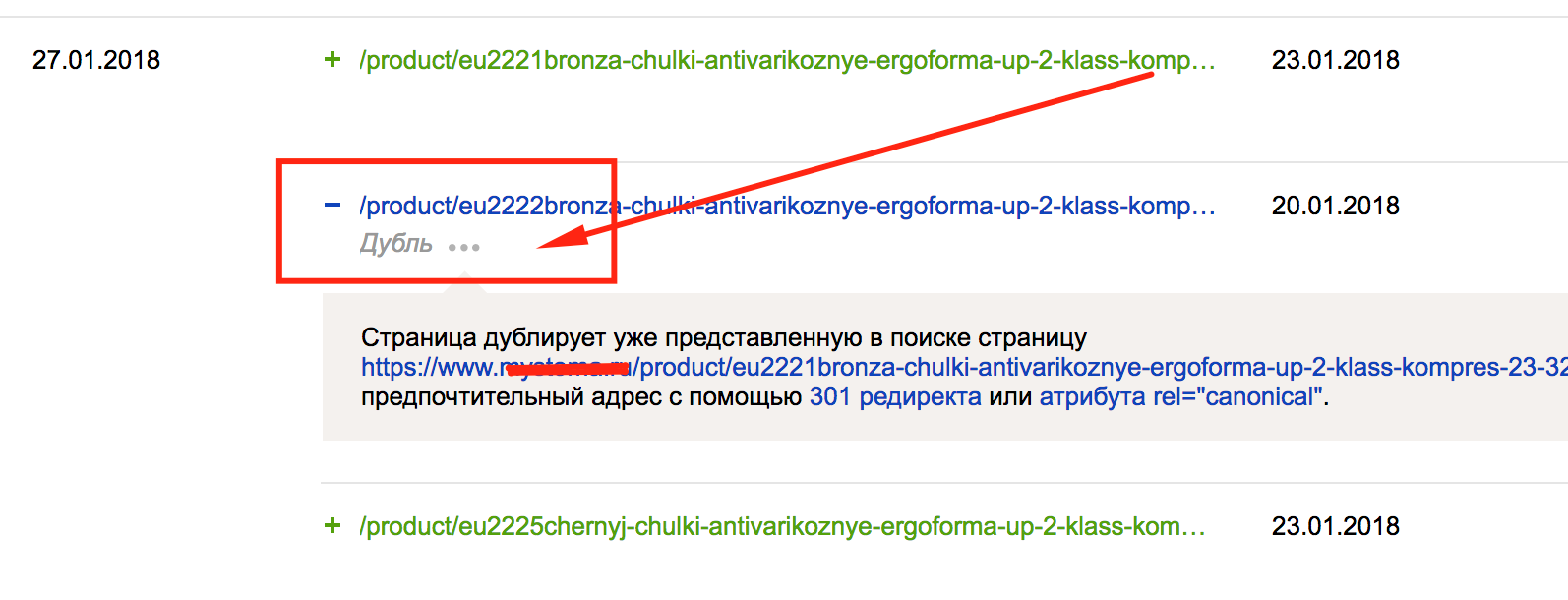

В Яндекс.Вебмастер есть очень удобный пункт сервиса — «Индексирование» — «Страницы в поиске». Данный пункт наглядно показывает текущую индексацию сайта, а также дубликаты страниц (то, что мы ищем):

Рис. 5. Скриншот из панели Яндекс.Вебмастер — Использование функции Страницы в Поиске

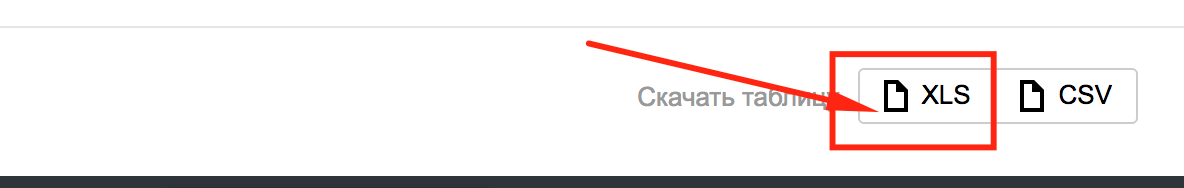

Для полного анализа дубликатов страниц рекомендуется выгрузить xls-файл всех страниц, которые присутствуют в поиске:

Рис. 6. Выгрузка страниц в поиске из панели Яндекс.Вебмастер

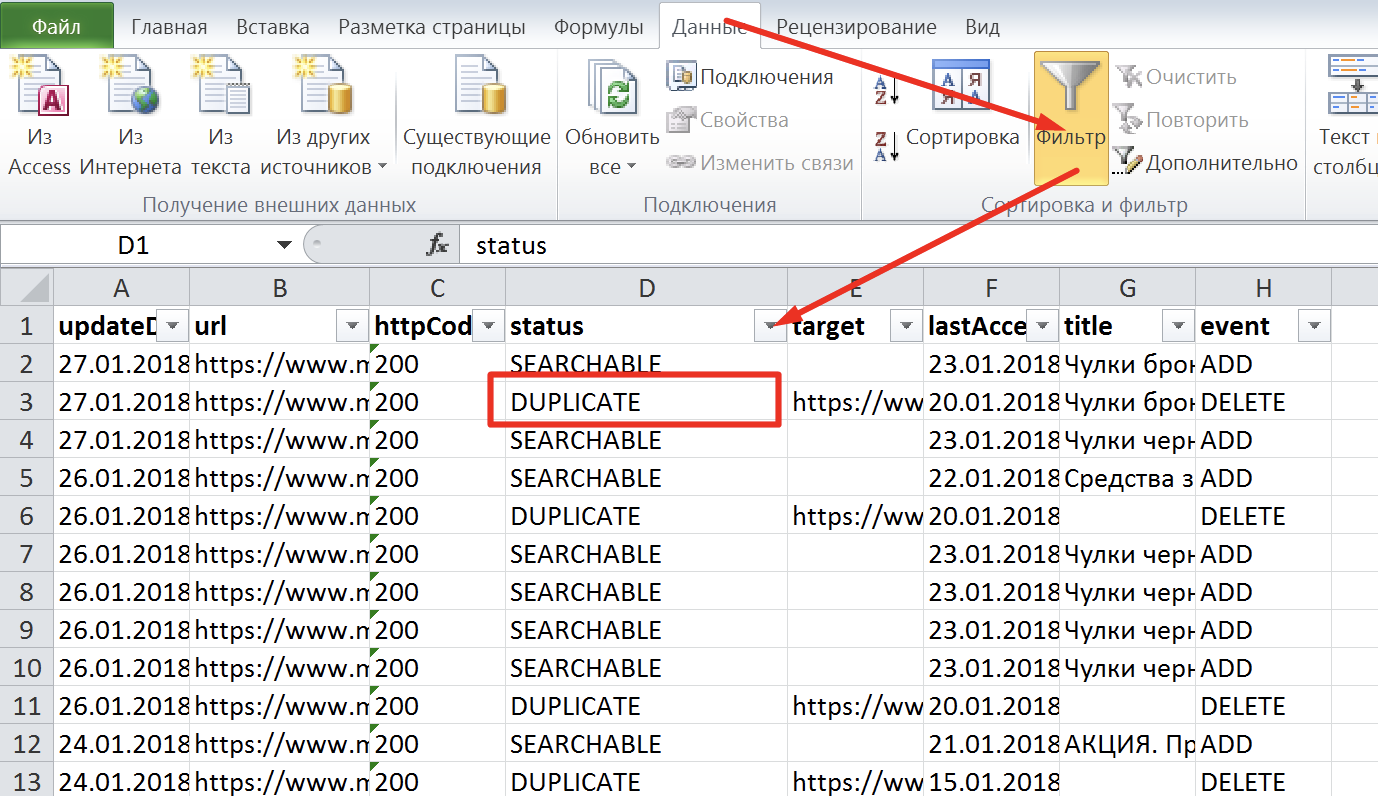

Открываем наш xls-файл и включаем фильтр: Данные – Фильтр:

Рис. 7. Скриншот из xls-файла «Выгрузка страниц в поиске из панели Яндекс.Вебмастер»

В фильтре выбираем «DUPLICATE», и перед нами будет список дубликатов страниц. Рекомендуется проанализировать каждую страницу или один тип страниц, (если, например, это только карточки товаров) на предмет дублирования.

Например: поисковая система может признать дубликатами похожие карточки товаров с незначительными отличиями. Тогда необходимо переписать содержание страницы: основной контент, теги и метатеги, если они дублируются, либо такие карточки склеить с помощью атрибута rel=”canonical”. Другие рекомендации по избавлению от дубликатов страниц подробно описаны в пункте 5.

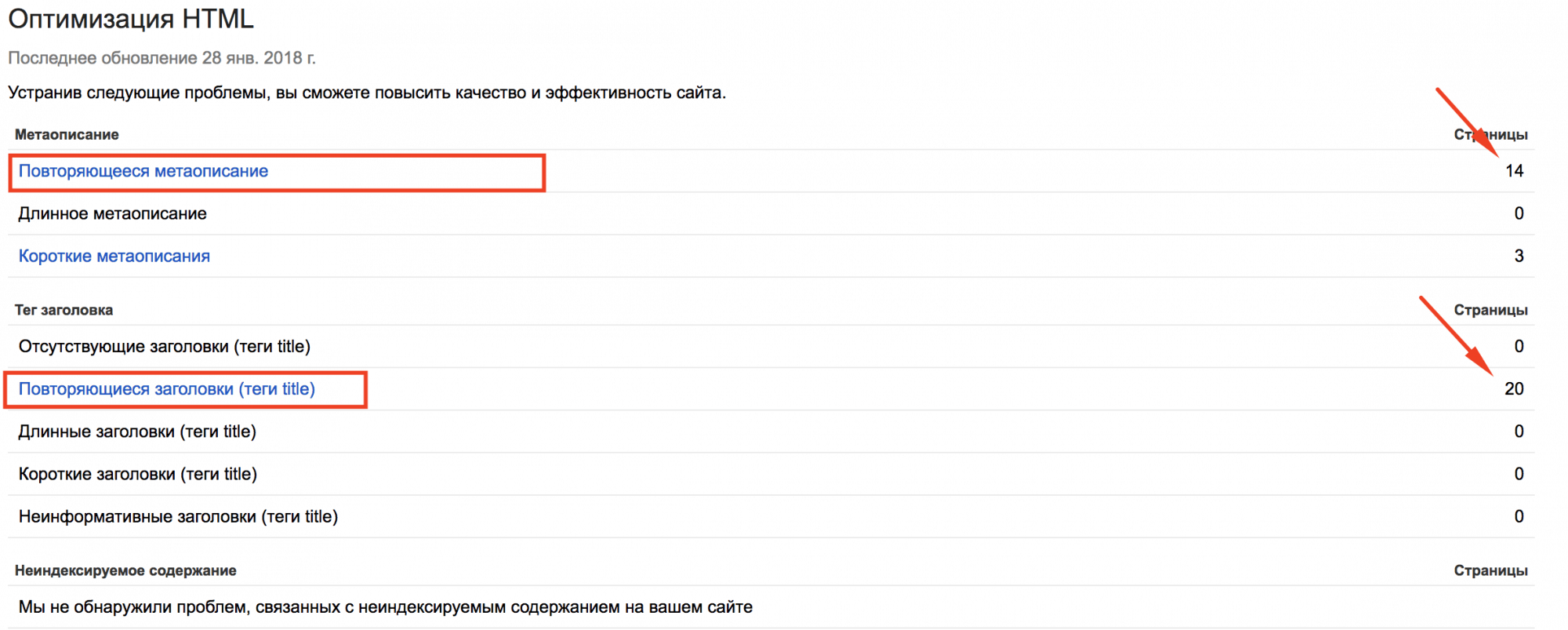

3. Использование Google Search Console

Заходим в Google Search Console, выбираем свой сайт, в левом меню кликаем «Вид в поиске» – «Оптимизация HTML» и смотрим такие пункты, которые связаны с термином «Повторяющееся»:

Рис. 8. Скриншот из панели «Google Console»

Данные страницы могут и не являются дубликатами, но проанализировать их нужно и при необходимости устранить проблемы с дублированием.

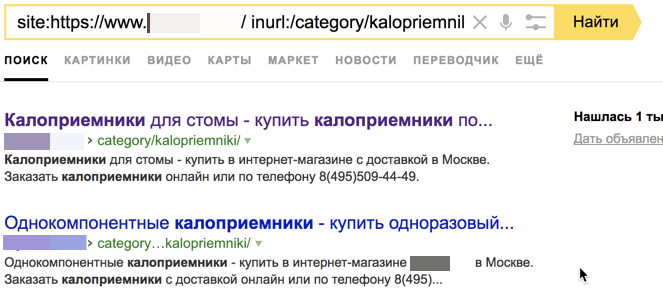

4. Использование операторов поиска

Для поиска дубликатов также можно использовать операторы поиска «site:» и «inurl», но данный метод уже устарел. Его полностью заменила функция «Страницы в поиске» в Яндекс.Вебмастере.

Рис. 9. Скриншот из поисковой выдачи – использование поисковых операторов

5. Ручной поиск

Для ручного поиска дубликатов страниц необходимо уже обладать знаниями о том, какие дубликаты могут быть. Вручную обычно проверяются такие типы дубликатов, как:

一 URL-адрес с “/” и без “/” в конце. Проверяем первую страницу сайта с “/” и без “/” в конце в сервисе bertal. Если обе страницы отдают код ответа сервера 200 ОК, то такие страницы являются дубликатами и их необходимо склеить 301 редиректом

一 добавление в URL-адрес каких-либо символов в конце адреса или в середине. Если после перезагрузки страница не отдает 404 код ответа сервера или не настроен 301 Moved Permanently на текущую основную страницу, то перед нами, по сути, тоже дубликат, от которого необходимо избавиться. Такая ошибка является системной, и ее нужно решать на автоматическом уровне.

Как избавиться от дубликатов страниц: основные виды и методы

В данном пункте разберем наиболее часто встречающиеся виды дубликатов страниц и варианты их устранения:

- Не склеенные страницы с «/» и без «/», с www и без www, страницы с http и с https.

Варианты устранения:

一 Настроить 301 Moved Permanently на основное зеркало, обязательно выполните необходимые настройки по выбору основного зеркала сайта в Яндекс.Вебмастер.

- Страницы пагинации, когда дублируется текст с первой страницы на все остальные, при этом товар разный.

Выполнить следующие действия:

一 Использовать теги next/prev для связки страниц пагинации между собой;

一 Если первая страница пагинации дублируется с основной, необходимо на первую страницу пагинации поставить тег rel=”canonical” со ссылкой на основную;

一 Добавить на все страницы пагинации тег:

|

< meta name=»robots» content=»noindex, follow» / > |

Данный тег не позволяет роботу поисковой системы индексировать контент, но дает переходить по ссылкам на странице.

- Страницы, которые появляются из-за некорректно работающего фильтра.

Варианты устранения:

一 Корректно настроить страницы фильтрации, чтобы они были статическими. Также их необходимо правильно оптимизировать. Если все корректно настроено, сайт будет дополнительно собирать трафик на страницы фильтрации;

一 Закрыть страницы-дубликаты в файле robots.txt с помощью директивы Disallow.

- Идентичные товары, которые не имеют существенных различий (например: цвет, размер и т.д.).

Варианты устранения:

一 Склеить похожие товары с помощью тега rel=”canonical”;

一 Реализовать новый функционал на странице карточки товара по выбору характеристики. Например, если есть несколько почти одинаковых товаров, которые различаются только, к примеру, цветом изделия, то рекомендуется реализовать выбор цвета на одной карточке товара, далее – с остальных настроить 301 редирект на основную карточку.

- Страницы для печати.

Вариант устранения:

一 Закрыть в файле robots.txt.

- Страницы с неправильной настройкой 404 кода ответа сервера.

Вариант устранения:

一 Настроить корректный 404 код ответа сервера.

- Дубли, которые появились после некорректной смены структуры сайта.

Вариант устранения:

一 Настроить 301 редирект со страниц старой структуры на аналогичные страницы в новой структуре.

- Дубли, которые появляются из-за некорректной работы Яндекс.Вебмастера. Например, такие URL-адреса, которые заканчиваются на index.php, index.html и др.

Варианты устранения:

一 Закрыть в файле robots.txt;

一 Настроить 301 редирект со страниц дубликатов на основные.

- Страницы, к примеру, одного и того же товара, которые дублируются в разных категориях по отдельным URL-адресам.

Варианты устранения:

一 Cклеить страницы с помощью тега rel=”canonical”;

一 Лучшим решением будет вынести все страницы товаров под отдельный параметр в URL-адресе, например “/product/”, без привязки к разделам, тогда все товары можно раскидывать по разделам, и не будут “плодиться” дубликаты карточек товаров.

- Дубли, которые возникают при добавлении get-параметров, различных utm-меток, пометок счетчиков для отслеживания эффективности рекламных кампаний: Google Analytics, Яндекс.Метрика, реферальных ссылок, например, страницы с такими параметрами как: gclid=, yclid=, openstat= и др.

Варианты устранения:

一 В данном случае необходимо проставить на всех страницах тег rel=”canonical” со ссылкой страницы на саму себя, так как закрытие таких страниц в файле robots.txt может повредить корректному отслеживанию эффективности рекламных кампаний.

Устранение дублей позволит поисковым системам лучше понимать и ранжировать ваш сайт. Используйте советы из этой статьи, и тогда поиск и устранение дублей не будет казаться сложным процессом.

И повторюсь: малое количество дубликатов не так значительно скажется на ранжировании вашего сайта, но большое количество (более 50% от общего числа страниц сайта) явно нанесет вред.

www.seonews.ru